Allen AI提出MERLOT,视频理解领域新SOTA!

文 | Yimin_饭煲

2021年,多模态领域大概是人工智能研究者们关注者最多的一个领域了。随着各种模态数据集的增长和算力的发展,研究者们开始不断地尝试在一个模型中融合来自各个模态的信息。

而在多模态领域的研究中,和视频相关的任务被认为是最复杂的。

一方面,高质量的视频数据集比图像数据集更加困难,因此数据集的数量和质量往往受限;另一方面,视频数据集中含有文本、图像、语音等多个模态的信息,还要考虑时间线,融合起来比单纯的图像-文本数据更加复杂。

在AI领域久负盛名的Allen研究所向这一复杂的问题发起了挑战,提出了MERLOT系列工作。

第一篇 MERLOT:Multimodal Neural Script Knowledge Models 发表于Neurips 2021, 使用了大量的视频数据进行自监督预训练,在12个视频问答任务上取得了SOTA;

而第二篇 MERLOT Reserve:Neural Script Knowledge through Vision and Language and Sound 则于今年年初刚刚发布,进一步深度融合了视频中的语音信息,在多个任务上又取得了明显提升。下面,就让我们一起来学习这两篇十分Solid的工作吧~

论文链接:

MERLOT:

https://arxiv.org/pdf/2106.02636.pdf

MERLOT Reserve:

https://arxiv.org/pdf/2201.02639.pdf

主要方法

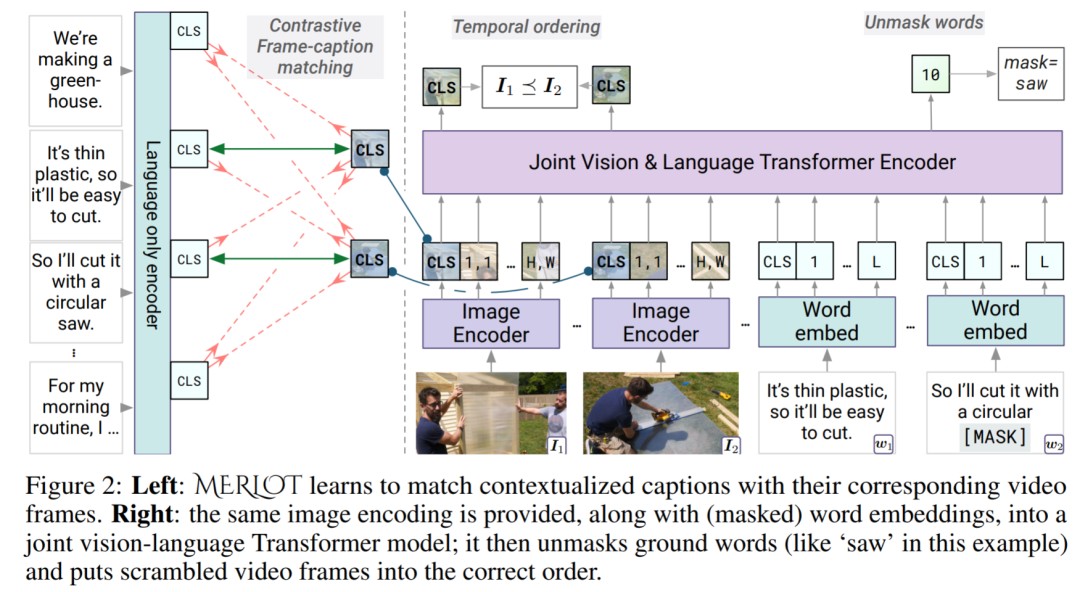

MERLOT这一工作使用了视觉编码器、语言编码器和联合编码器。作者们设计了三个任务来进行优化。

第一个任务是Contrastive Frame-caption matching(标题-帧匹配),作者们使用视觉编码器编码图片得到的[CLS]表示和文本编码器编码句子得到的[CLS]表示进行对比学习,使得图像编码器具备较好的表示学习性能。

第二个任务是Masked Language Modeling,对模型的语言建模能力进行优化。

第三个任务是Temporal Reordering, 在40%的情况下, 随机选择一个整数 , 从视频输入中的所有帧中随机选取 帧并进行打乱,将位置编码 (e.g. )替换为随机且独特的位置编码(e.g. ). 这些随机的位置编码和原有的位置编码分别进行学习,可以让模型学到恢复被扰乱的帧顺序的能力。

这个任务的损失函数是针对一对视频帧 拼接隐状态 ,使用两层MLP分类器进行二分类( 和 的前后关系)。

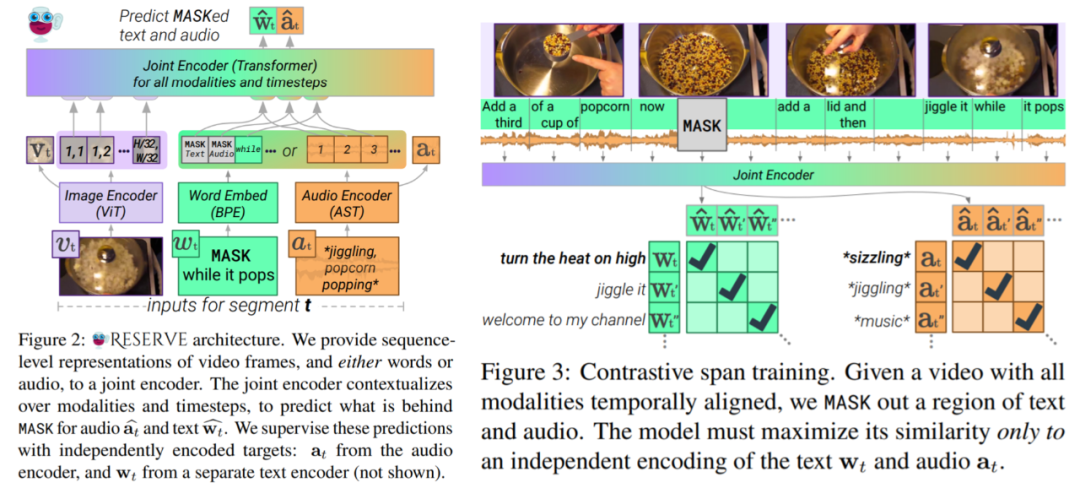

MERLOT Reserve这一工作相比于MERLOT引入了新的模态:语音。

为了更好的融合来自三个模态的信息,作者们提出了更通用,更统一的训练任务。

对于每一个Batch的输入,只输入视频的帧和文本/语音中的一个(由于文本和语音的信息具有重复性), 并且MASK文本/语音中的一部分。作者们提出了对比区域匹配(Contrastive Span Matching)这一任务, 给定匹配的视频帧/文本/语音数据,以文本为例,最小化交叉熵损失函数:

其中 为[MASK]位置的隐状态表示, 为[MASK]掉的信息的隐状态表示, 为Batch中其他样本(负样本)的隐状态表示。同理定义了 ,定义:

同样的,可以定义 和 。定义总体的损失函数为:

作者们还使用了一些技巧来提升得到的特征表示的质量,感兴趣的小伙伴可以去原文细读~。

数据集

对于大规模的预训练工作,除开训练方法之外另一个值得关注的部分就是使用的数据集了。

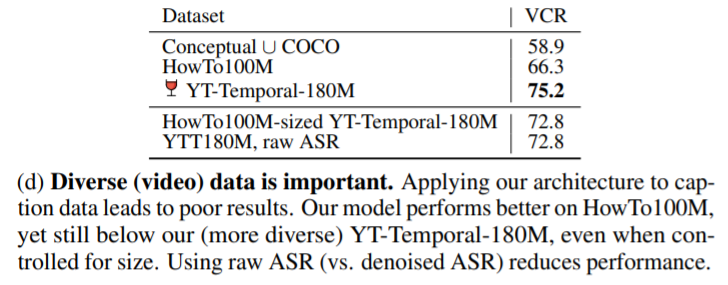

MERLOT收集的数据集为YT-Temporal-180M,从600万公开的YouTube视频中抽取得到。

作者们选取的数据集比起HowTo100M和VLOG等局限于特定领域的数据集范围更大,主题更广。

后来的实验表明,如果仅使用HowTo100M这样的数据集进行训练,会降低模型在下游任务上的性能。

在MERLOT Reserve这一工作中,作者们扩充了数据集,提出了YT-Temporal-1B数据集,包含2000万Youtube视频,进一步提升了数据集的多样性,而模型强大的性能也说明了扩充数据的有效性。

结果

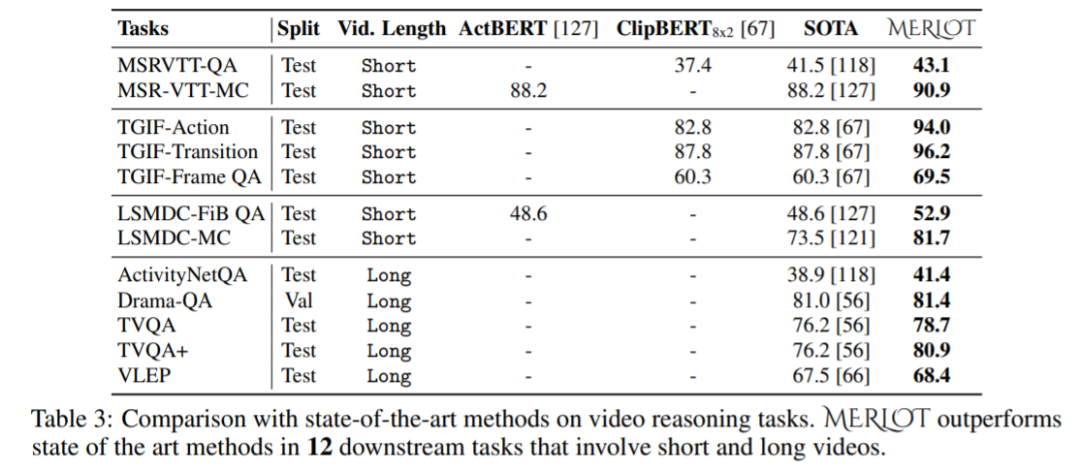

作者们通过大量的实验证实了MERLOT和MERLOT Reserve的有效性。对于MERLOT模型,作者们在12个视频问答数据集上开展了实验,大幅度刷新了SOTA。

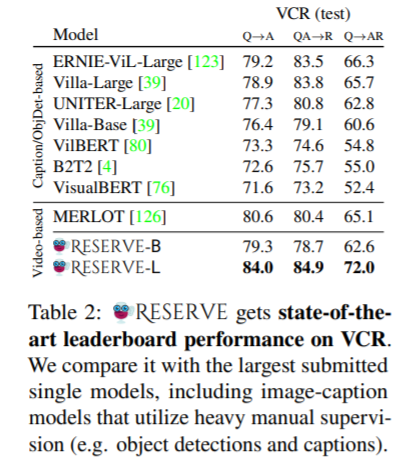

MERLOT Reserve模型同样也有非常强大的表现,在视频常识推理数据集上取得了不小的性能提升,超过了许多使用了其他监督信息的模型。

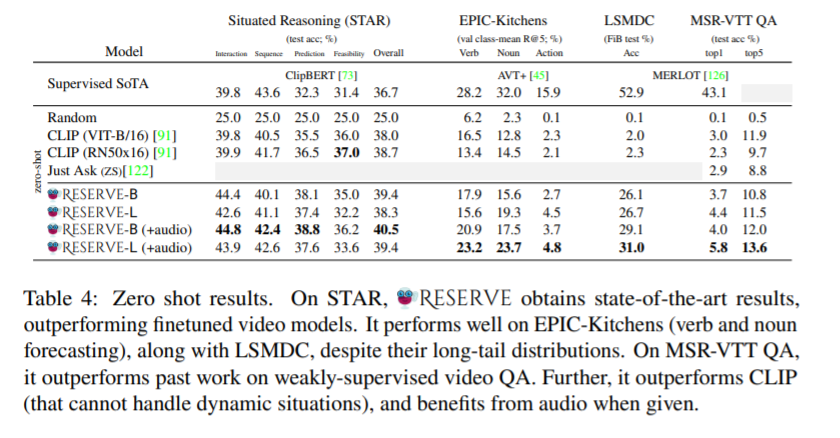

由于MERLOT Reserve使用了大量的数据进行了自监督预训练,因此在零样本学习上有着不错的性能,在STAR数据集上相比于有监督的SOTA都有着明显的提升。

结语

多模态技术的发展和商业化,也许将会带来人工智能应用的新一轮爆发。以往的多模态应用面临着模型架构复杂、缺少数据、缺少算力等一系列问题,而随着Transformer结构一统天下,互联网上各模态数据的井喷式增长,计算资源越发普及,这些问题都在慢慢得到解决。

MERLOT系列工作刷新了我们认知中视频理解领域的上限,向我们展示了视频、语音、文本多模态高效融合的一种可能性。未来,让我们一起努力朝着多模态领域的"BERT"模型进发吧!

萌屋作者:Yimin_饭煲

在微软NLC组搬砖的联培博士生,爱好摄影和运动,希望卖萌屋早日开通视频业务,我来当摄影师!

作品推荐

后台回复关键词【入群】

加入卖萌屋NLP/IR/Rec与求职讨论群

后台回复关键词【顶会】

获取ACL、CIKM等各大顶会论文集!

![]()

萌屋作者:Yimin_饭煲

萌屋作者:Yimin_饭煲 后台回复关键词【

后台回复关键词【