知识图谱如何用于可解释人工智能中?KGC2019这份教程为你讲解(附34页ppt)

【导读】 知识图谱KGC是一个世界级会议,将有经验的实践者、技术领导者、前沿研究人员、学者和供应商聚集在一起,就知识图的主题进行为期两天的演讲、讨论和网络交流。KGC2019在5月7号到9号举行。来自加拿大CortAIx 首席人工智能科学家Freddy Lecue做了关于《知识图谱在机器学习系统中应用》的报告,特别对可解释人工智能以及知识图谱在可解释机器学习中的作用进行了重点讲述,是非常好的学习资料。

请关注专知公众号(点击上方蓝色专知关注)

后台回复“KGXAI” 就可以获取《知识图谱在可解释机器学习中应用》的下载链接~

Freddy Lecue

Freddy Lecue博士是加拿大蒙特利尔泰勒斯人工智能技术研究中心的首席人工智能科学家。他也是法国索菲亚安提波利斯温姆斯的INRIA研究所的研究员。在加入泰雷兹新成立的人工智能研发实验室之前,他曾于2016年至2018年在埃森哲爱尔兰实验室担任人工智能研发主管。在加入埃森哲之前,他曾担任研究科学家,2011年至2016年在IBM research担任大规模推理系统首席研究员,2008年至2011年在曼彻斯特大学(University of Manchester)担任研究员,2005年至2008年在Orange Labs担任研究工程师。

知识图谱在可解释人工智能的应用

报告摘要

尽管围绕基于机器学习的人工智能系统出现了大量创新,但各大行业仍对其大规模影响感到困惑。这在关键系统的上下文中尤其有效,因为大规模采用需要健壮性、信任,特别是解释。纯基于机器学习的方法已经出现,但未能解决可解释性的核心原则,即如何用人类可理解的方式来解释一个决定。为了解决机器学习中的可解释性问题,知识图表现出了适合目的的特征。我们将回顾知识图如何适应人工智能系统的进展解释,并最终大规模采用人工智能。

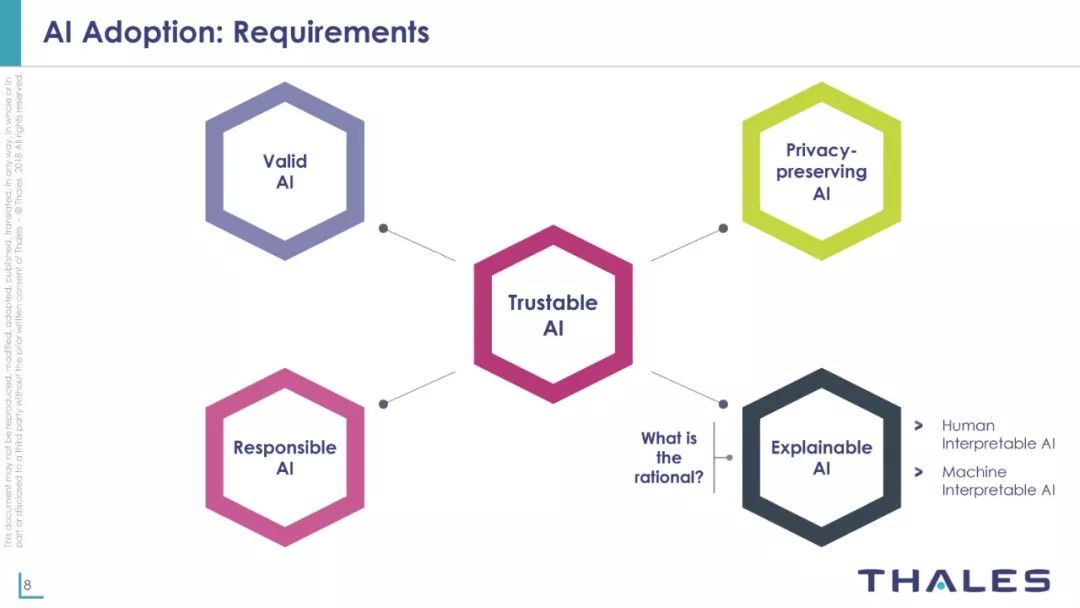

可信赖人工智能包含要素

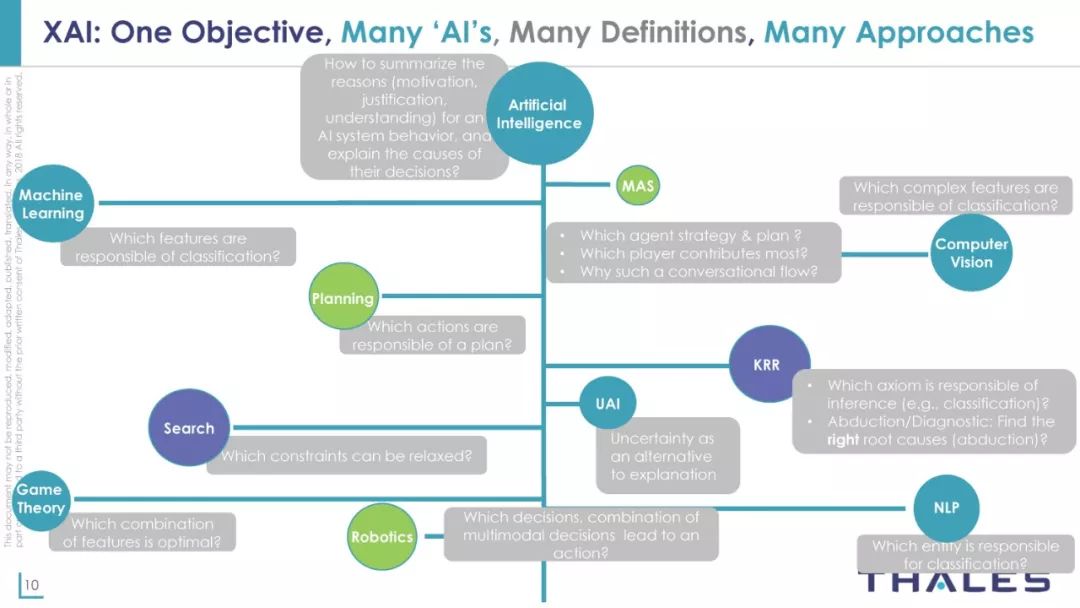

可解释人工智能涵义

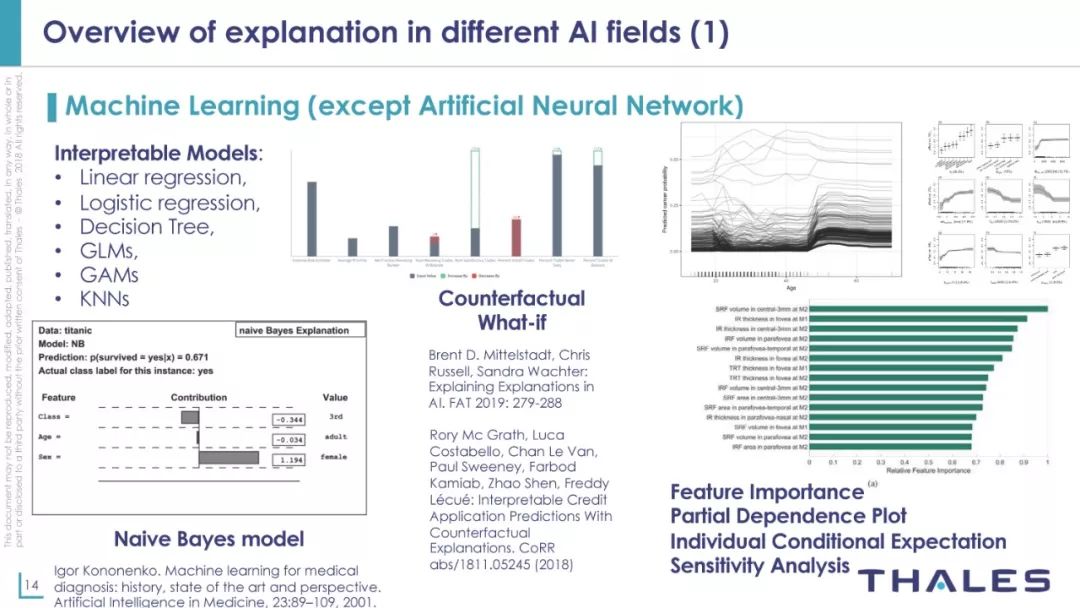

可解释机器学习模型包括线性回归、逻辑回归、决策树、GLMs、GAMs、KNNs等

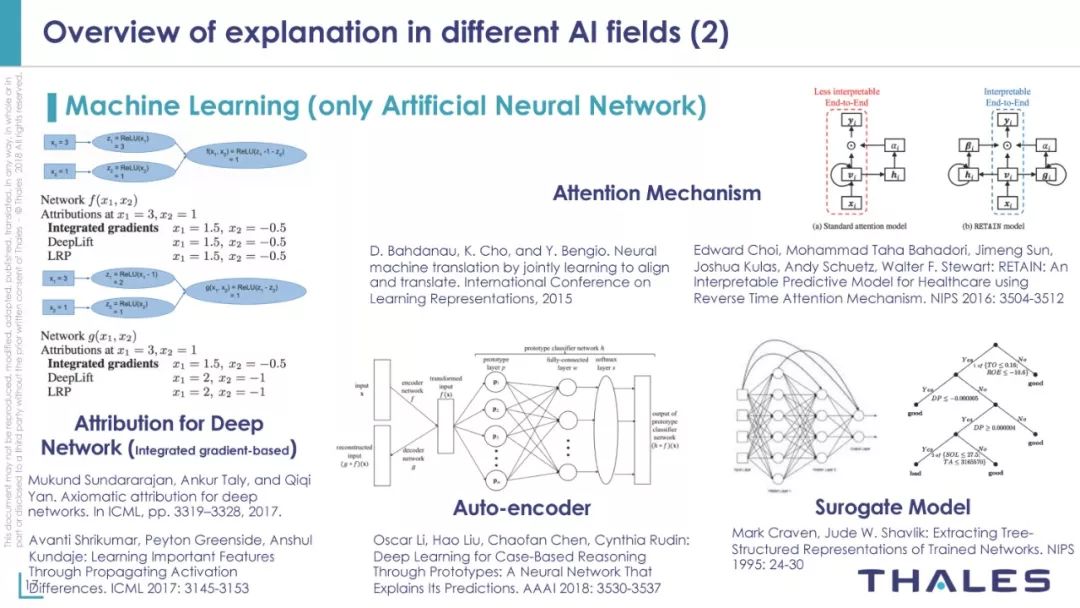

深度神经网络模型

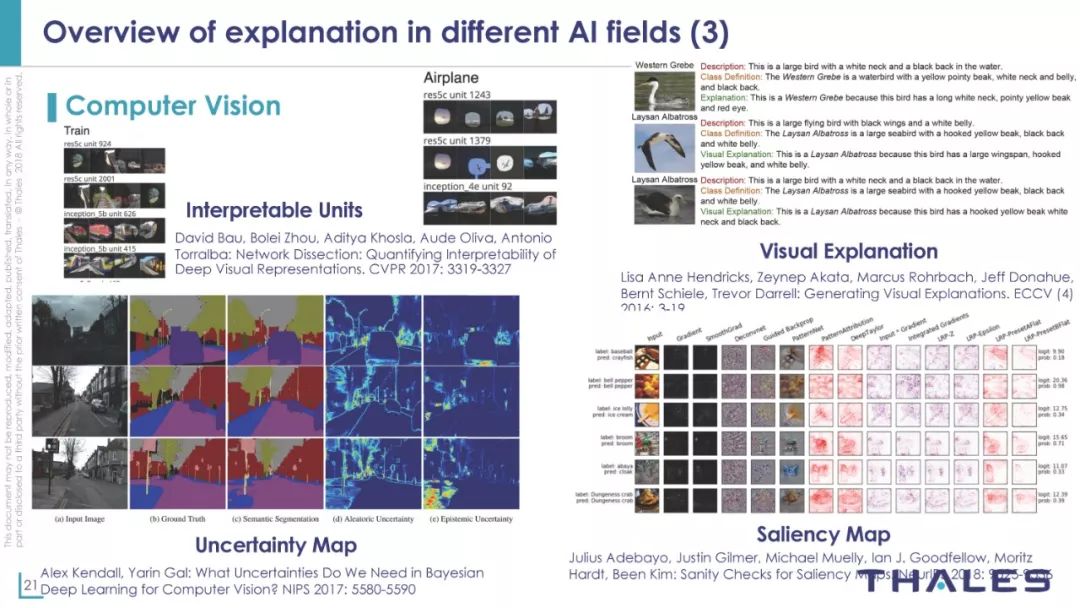

计算机视觉可解释实例

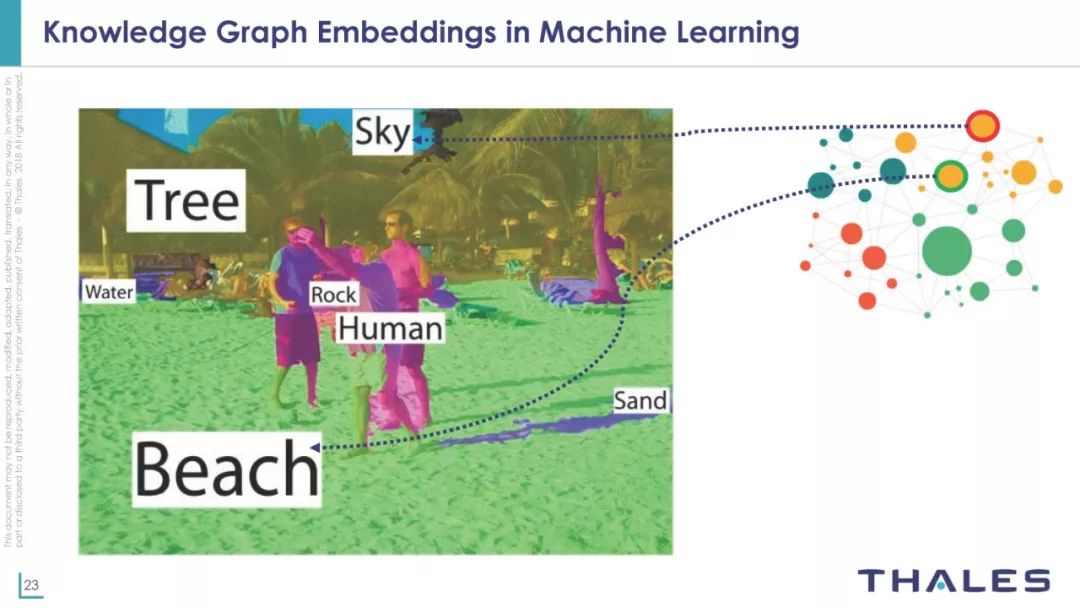

机器学习中的的知识图谱嵌入

知识图谱决策树

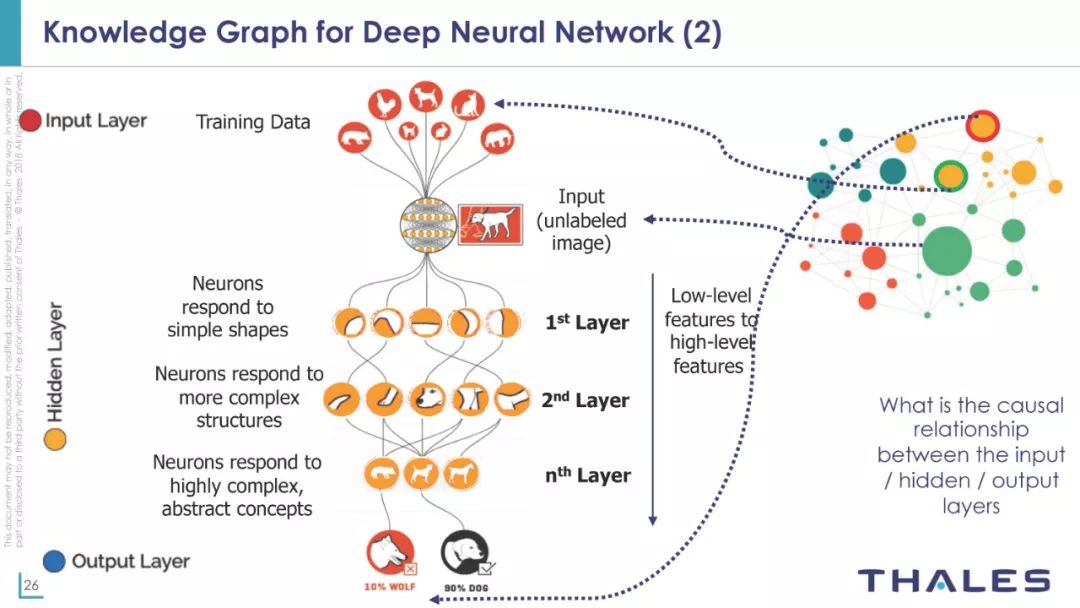

知识图谱用于神经网络

结论

可解释的人工智能是工业上采用人工智能的强烈要求

有很多方法可以解释机器学习,但没有附加语义

需要在联合学习和推理系统方面做更多的工作

(总的来说):很多有趣的/互补的方法

-END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~

专知《深度学习:算法到实战》课程全部完成!540+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程