【导读】2020 年 2 月 7 日-2 月 12 日,AAAI 2020 于美国纽约举办。AAAI2020关于可解释人工智能的Tutorial引起了人们极大的关注,这场Tutorial详细阐述了解释黑盒机器学习模型的术语概念以及相关方法,涵盖基础、工业应用、实际挑战和经验教训,是构建可解释模型的重要指南.

可解释AI:基础、工业应用、实际挑战和经验教训

地址: https://xaitutorial2020.github.io/

Tutorial 目标 本教程的目的是为以下问题提供答案:

-

什么是可解释的AI (XAI)

- 什么是可解释的AI(简称XAI) ?,人工智能社区(机器学习、逻辑学、约束编程、诊断)的各种流有什么解释?解释的度量标准是什么?

-

我们为什么要关心?

- 为什么可解释的AI很重要?甚至在某些应用中至关重要?阐述人工智能系统的动机是什么?

-

哪里是关键?

- 在大规模部署人工智能系统时,真正需要解释的实际应用是什么?

-

它是如何工作的?

- 在计算机视觉和自然语言处理中,最先进的解释技术是什么?对于哪种数据格式、用例、应用程序、行业,什么有效,什么没有效?

-

我们学到了什么?

- 部署现有XAI系统的经验教训和局限性是什么?在向人类解释的过程中?

-

下一个是什么?

- 未来的发展方向是什么?

概述

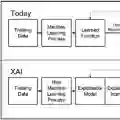

人工智能的未来在于让人们能够与机器合作解决复杂的问题。与任何有效的协作一样,这需要良好的沟通、信任、清晰和理解。XAI(可解释的人工智能)旨在通过结合象征性人工智能和传统机器学习来解决这些挑战。多年来,所有不同的AI社区都在研究这个主题,它们有不同的定义、评估指标、动机和结果。

本教程简要介绍了XAI迄今为止的工作,并调查了AI社区在机器学习和符号化AI相关方法方面所取得的成果。我们将激发XAI在现实世界和大规模应用中的需求,同时展示最先进的技术和最佳实践。在本教程的第一部分,我们将介绍AI中解释的不同方面。然后,我们将本教程的重点放在两个特定的方法上: (i) XAI使用机器学习和 (ii) XAI使用基于图的知识表示和机器学习的组合。对于这两种方法,我们将详细介绍其方法、目前的技术状态以及下一步的限制和研究挑战。本教程的最后一部分概述了XAI的实际应用。

Freddy Lecue博士是加拿大蒙特利尔泰勒斯人工智能技术研究中心的首席人工智能科学家。他也是法国索菲亚安提波利斯温姆斯的INRIA研究所的研究员。在加入泰雷兹新成立的人工智能研发实验室之前,他曾于2016年至2018年在埃森哲爱尔兰实验室担任人工智能研发主管。在加入埃森哲之前,他是一名研究科学家,2011年至2016年在IBM research担任大规模推理系统的首席研究员,2008年至2011年在曼彻斯特大学(University of Manchester)担任研究员,2005年至2008年在Orange Labs担任研究工程师。

目录与内容

第一部分: 介绍和动机

人工智能解释的入门介绍。这将包括从理论和应用的角度描述和激发对可解释的人工智能技术的需求。在这一部分中,我们还总结了先决条件,并介绍了本教程其余部分所采用的不同角度。

第二部分: 人工智能的解释(不仅仅是机器学习!)

人工智能各个领域(优化、知识表示和推理、机器学习、搜索和约束优化、规划、自然语言处理、机器人和视觉)的解释概述,使每个人对解释的各种定义保持一致。还将讨论可解释性的评估。本教程将涵盖大多数定义,但只深入以下领域: (i) 可解释的机器学习,(ii) 可解释的AI与知识图和机器学习。

第三部分: 可解释的机器学习(从机器学习的角度)

在本节中,我们将处理可解释的机器学习管道的广泛问题。我们描述了机器学习社区中解释的概念,接着我们描述了一些流行的技术,主要是事后解释能力、设计解释能力、基于实例的解释、基于原型的解释和解释的评估。本节的核心是分析不同类别的黑盒问题,从黑盒模型解释到黑盒结果解释。

第四部分: 可解释的机器学习(从知识图谱的角度)

在本教程的这一节中,我们将讨论将基于图形的知识库与机器学习方法相结合的解释力。

第五部分: XAI工具的应用、经验教训和研究挑战

我们将回顾一些XAI开源和商业工具在实际应用中的例子。我们关注一些用例:i)解释自动列车的障碍检测;ii)具有内置解释功能的可解释航班延误预测系统;(三)基于知识图谱的语义推理,对企业项目的风险层进行预测和解释的大范围合同管理系统;iv)识别、解释和预测500多个城市大型组织员工异常费用报销的费用系统;v)搜索推荐系统说明;vi)解释销售预测;(七)贷款决策说明;viii)解释欺诈检测。