神经网络的基础是MP模型?南大周志华组提出新型神经元模型FT

选自arXiv

作者:张绍群、周志华

机器之心编译

在此论文中,来自南京大学的张绍群博士和周志华教授提出一个新型神经元模型 Flexible Transmitter (FT),该模型具备灵活的可塑性并支持复杂数据的处理。据论文介绍,这项研究为神经网络提供了一种新的基本构造单元,展示了开发具有神经元可塑性的人工神经网络的可行性。

当前的神经网络大多基于 MP 模型,即按照生物神经元的结构和工作原理构造出来的抽象和简化模型。此类模型通常将神经元形式化为一个「激活函数复合上输入信号加权和」的形式。

近日,来自南京大学张绍群博士和周志华教授提出了一个名为 Flexible Transmitter (FT) 的模型,这是一种具备灵活可塑性的新型生物拟真神经元。

FT 模型利用一对参数来建模神经元之间的传输递质(transmitter),并设置一个神经递质调节的记忆单元来记录所关注神经元的长期学习信息。因此,该研究将 FT 模型形式化为一个二元二值函数,常用的 MP 神经元模型是其特殊形式。FT 模型可以处理更加复杂的数据,甚至时序信号。

为了展示 FT 模型的能力和潜力,研究者提出了 Flexible Transmitter Network (FTNet)。FTNet 基于最常见的全连接前馈架构而构建,并使用 FT 神经元作为其基本构造块。FTNet 允许梯度计算,并且可以通过在复数域中的反向传播算法来实现。在一系列任务上的实验结果展示了 FTNet 的优越性能。这项研究为神经网络提供了另一种基本构造块,展示了开发具有神经元可塑性的人工神经网络的可行性。

论文链接:https://arxiv.org/pdf/2004.03839v2.pdf

常见的 MP 模型

神经网络的基础计算单元是神经元,对应于生物神经系统的细胞。尽管神经网络研究已经持续 50 余年,多种神经网络算法和架构层出不穷,然而人们对神经元建模方面的研究仍然不够。

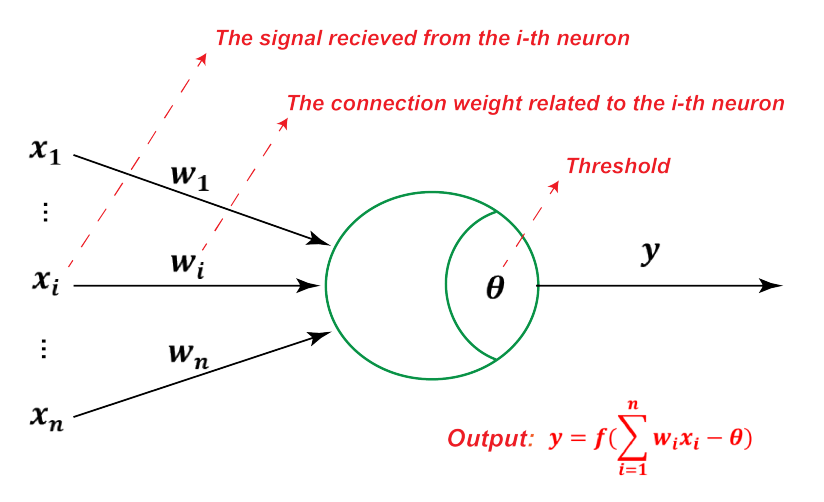

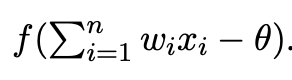

最著名也最常用的神经元表示是 MP 模型 [12],如下图 1 所示:

图 1:MP 模型

MP 模型接收到来自 n 个其他神经元传递过来的输入信号 x_i,这些输入信号通过带权重的连接 w_i 进行传递,神经元接收到的总输入值将与神经元的阀值进行比较,然后通过激活函数 f 处理以产生神经元的输出,即

尽管刻画方式非常简单,但 MP 模型很成功。然而实际中神经元细胞结构要复杂得多,因此探索具备其他生物拟真形式的神经元模型成为计算神经相关领域的一个基本问题。人们在建模细胞的放电行为方面做出了很多努力,提出了尖峰神经元模型(spiking neuron model)和以尖峰神经元作为基本计算单位的脉冲神经网络 [9, 18]。

是否存在另一种形式的神经元模型?

南京大学的研究者考虑了另一个有趣的角度,并提出一种新型神经元模型。

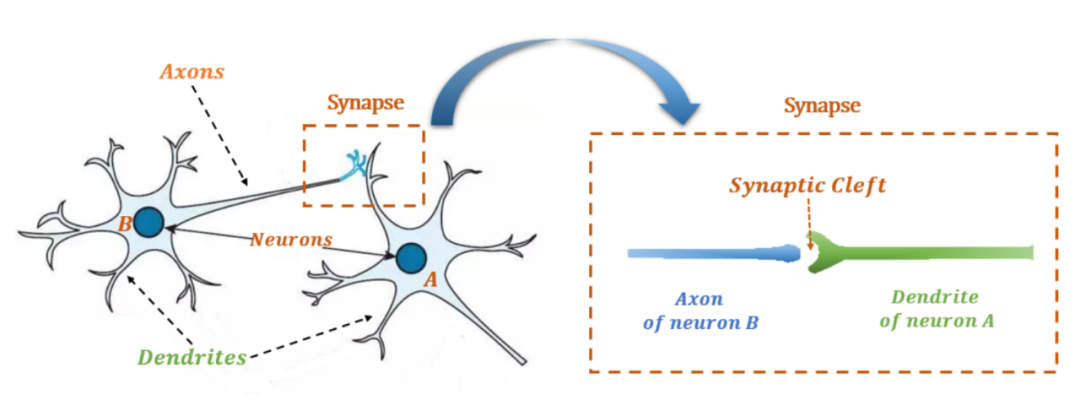

神经科学研究 [2, 7] 揭示了,突触可以确保两个神经元之间的单向通信机制,即信息流的流向是从突触前细胞到突触后细胞。突触通常在突触前细胞的轴突和突触后细胞的树突之间形成。在常见的突触结构中,树突和轴突之间存在大约 20 微米的间隙(在神经科学中叫作「突触间隙」),如图 2 所示。

图 2:生物神经元(左)及其突触结构(右)。

这意味着尽管密切相关,但突触前细胞的轴突传递强度(axonal transmission strength)和突触后细胞的树突浓度(dendritic concentration)是不同的。因此,自然有必要在神经元模型中区分突触前和突触后的部分。

与简单地将整个突触结构视为可学习的实值参数 w 的 MP 模型和使用具有自衰减累积(leaky integration)结构的 ODE 方程建模突触的尖峰神经元相反,该研究使用一对相关参数 (w, v) 来分别表示轴突传递强度和树突浓度,这就是灵活传输递质(flexible transmitter)。

此外,很多实验研究 [8, 6] 指出,神经元拥有对过去学习行为的记忆,并且生物电压根据近期的活动模式得到持续的加强或抑制,即长期増强(LTP)或抑制(LTD)。这项研究专门设置了一个记忆变量,即神经递质自调节记忆元,用来记录神经元对长期学习行为的记忆信息。

Flexible Transmitter 模型

神经科学方面的这一有趣发现表明,神经元 A 接收到来自神经元 B 的刺激信号后的响应不仅取决于神经元 B 的轴突传递强度,还依赖于神经元 A 的树突浓度,而这与神经元 A 的记忆单元有关,如图 2 所示。

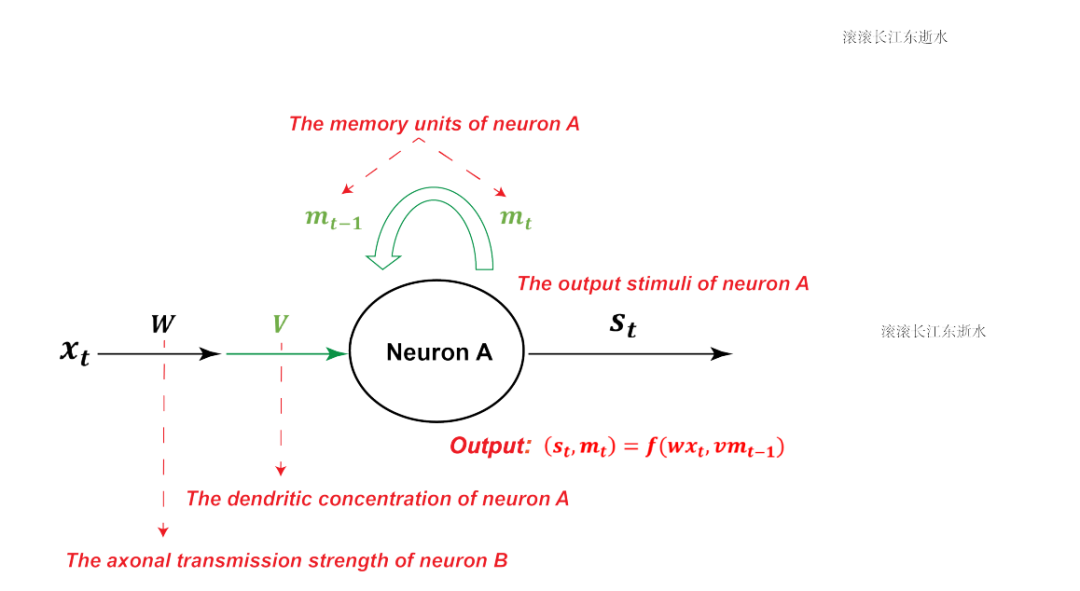

受此启发,该研究提出了 Flexible Transmitter 模型,如下图 3 所示:

图 3:FT 模型图示。其中 (w, v) 是传输递质参数对,m_t 表示神经元 A 的记忆单元在时间 t 处的强度。

与 MP 模型相反,FT 模型中的交互包括两个部分:wx_t,x_t 表示当下通过对应的轴突传递强度 w 发送至相关神经元的刺激信号;vm_t−1,m_t−1 表示在第 (t − 1) 时刻与树突浓度 v 相关的记忆强度。也就是说,FT 模型使用传输递质参数对 (w, v),而不是 MP 模型中的实数权重 w,来表示突触可塑性。

另一方面,FT 神经元在第 t 时刻的输出也包括两部分:s_t 和 m_t,其中 s_t 是神经元生成的生物电/化学刺激信号,m_t 是神经元的当前记忆强度。在该时刻结束后,刺激信号 s_t 被传输到下一个神经元,而相关神经元的记忆强度也更新为 m_t。

FT 模型利用参数对 (w, v) 表示突触可塑性,用神经元唯一的变量 m_t 表示神经递质调节的记忆单元。进而,FT 模型可以形式化为带有参数对 (w, v) 的二元二值函数,如下所示:

研究者将该模型叫作 Flexible Transmitter 模型。显然,这种建模方法使 FT 神经元不仅更具生物逼真度,也更有潜力处理复杂结构的数据。

Flexible Transmitter Network

FTNet 采用全连接网络架构,研究者用 FT 神经元代替了实值 MP 模型。他们还相应地开发了用于训练 FTNet 的实用、高效反向传播算法。

FT 模型的实现

根据公式 1,FT 模型本质上是由二元二值函数 f 和参数对 (w, v) 主导的。FT 模型的输入和输出包含两个部分,它们之间的关系非常复杂。多数现有的神经元模型都依赖于单值函数,而单值函数很难直接应用于这一问题。一种有趣的解决方法是利用复变函数来表示神经元的输入和输出,得到的神经元模型如下所示:

在复变分析中,复变函数输出的实部和虚部是成对的,即 s_t 和 m_t 共享同一个复变函数 f 和参数对 (w, v)。

FTNet 的简单架构

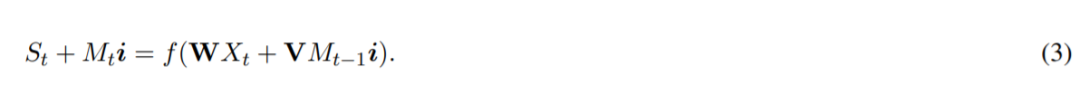

FT 神经元是神经网络的基本单元。为了评估它的潜力,研究者考虑使用最简单的全连接前馈神经网络架构,用 FT 神经元做构造块,替代原来的 MP 神经元,从而得到 FTNet。基于公式 2,我们为一层 FT 神经元提供一个通用向量化表示:

逐层重用式 3 中的向量化表示,可以得到 FTNet 的多层全连接前馈架构。

现在还有两个问题:1)复变函数 f 应该是什么样的?2)如何学习其参数?

为了解决这两个问题,研究者将方程 2 中的复变函数 f 分为两个部分:转换函数 τ : C → C 和激活函数 σ : C → C,其中 f = σ ◦ τ。该复合运算将 f 中的复杂结构与非线性激活函数分离开来:转换函数 τ 表示复数域上的加和运算,通常是可微的,而 σ 表示激活函数。因此,FTNet 允许梯度计算,且能够适应一些传统的激活函数。

复杂的反向传播算法

为了训练 FTNet,研究者提出了一种复杂的反向传播算法(Complex Backpropagation,CBP)。该算法是常用反向传播算法在复数域中的扩展版本。该研究还以单层 FTNet 和双层 FTNet 为例,给出了 CBP 的详细实现过程,详见原论文附录 B。

实验

研究者在三个模拟和实际数据集上对比了 FTNet 和多个常见神经网络。

模拟信号

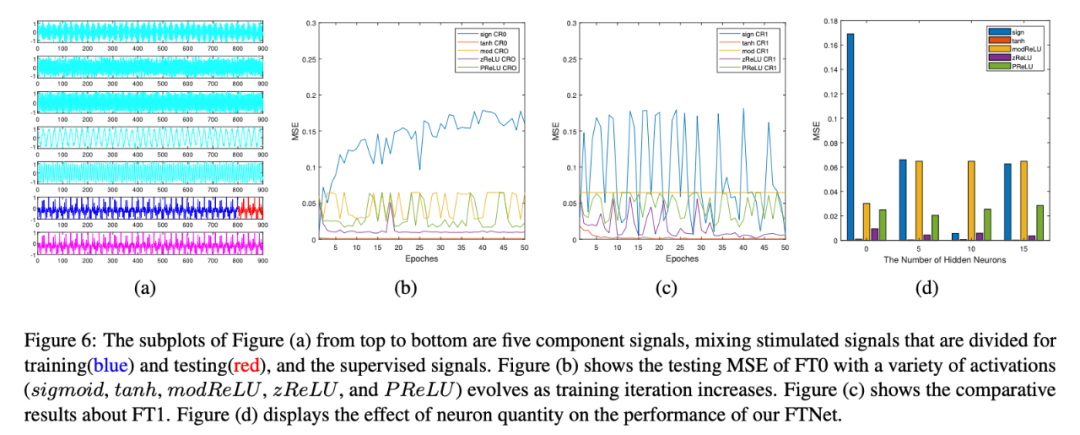

研究者首先探索了使用不同配置的 FTNet 在模拟数据上的性能。

实验发现,tanh 激活函数是最能维持最优性能的,不管是使用 FT0 还是 FT1 架构都是如此。相比之下,sigmoid 和 modReLU 激活函数的性能要差一些。zReLU 的性能略优于 P ReLU。

研究人员猜想其原因在于,对于复数激活函数而言,半径可能比相位更易受影响,也更重要。因此,研究者在接下来的现实世界任务中统一使用 tanh 激活函数和 0.01 的学习率来配置 FTNet。

单变量时序预测:盐城汽车上牌量预测任务

研究者在盐城汽车上牌量预测竞赛数据集上进行了实验,这是一个现实世界单变量时序预测任务。

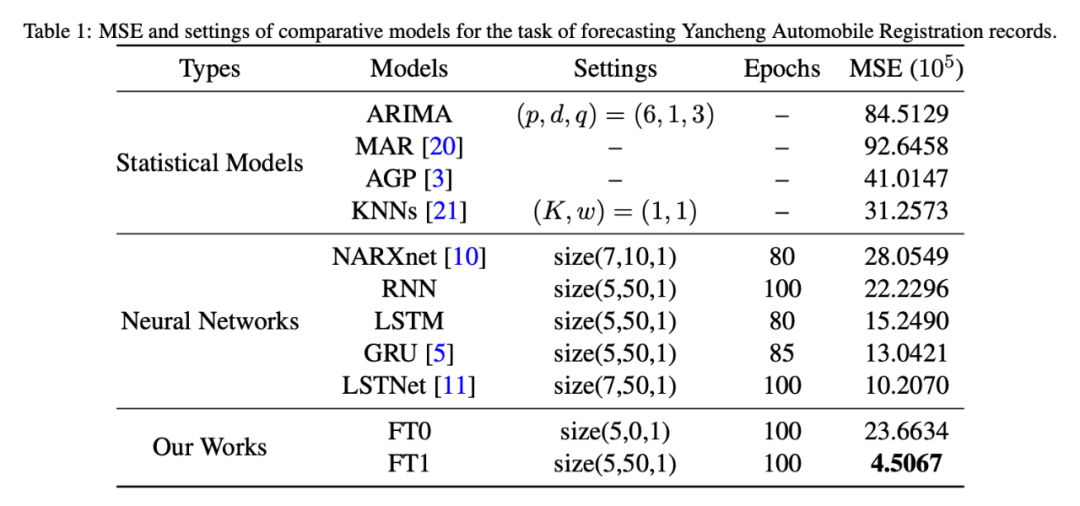

表 1:在盐城汽车上牌量预测任务上的均方差(MSE)和模型设置。

从表 1 中可以看出,FT1 模型的性能极具竞争力。

多变量时序预测:HDUK 交通预测任务

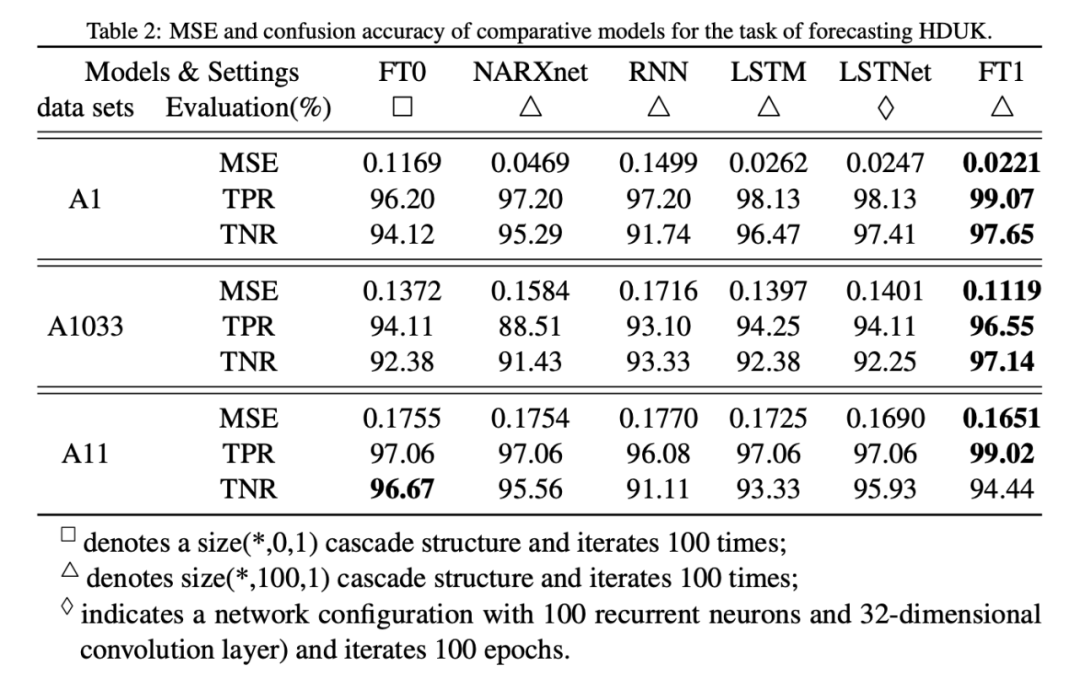

研究者在 HDUK 数据集上验证了 FTNet 的性能,这是一个典型的多变量时序预测数据集。实验表明,在相同设置下,FTNet 的性能超过其他神经网络。

表 2:模型在 HDUK 交通预测任务上的 MSE 和 confusion accuracy。

在 pixel-by-pixel MNIST 数据集上的图像识别性能

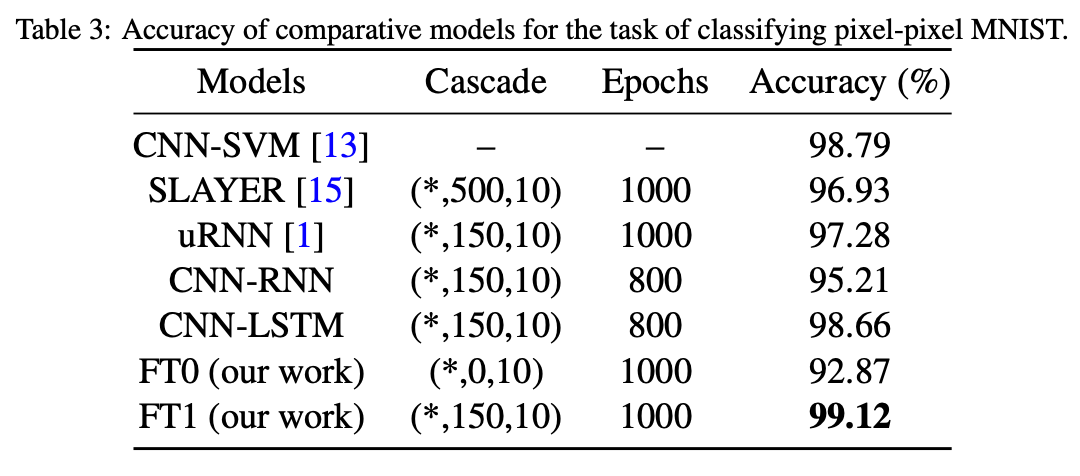

表 3:各模型在 pixel-by-pixel MNIST 任务上的准确率。

实验表明,FTNet 的性能优于之前最优的神经网络。

关于作者

该研究的第一作者张绍群现在南京大学计算机科学与技术系 LAMDA 组读博,导师是周志华,研究兴趣是时序分析和计算神经科学。周志华教授也是该研究的通讯作者。

第一作者张绍群