IJCAI 2018 | 北京大学提出新型分层式端到端模型,整合文本摘要和情感分类

选自arXiv

作者:Shuming Ma、Xu Sun、Junyang Lin、Xuancheng Ren

机器之心编译

参与:Panda

目前在自然语言处理任务中,文本摘要和情感分类通常是分开解决的。北京大学的研究者提出的一种分层式端到端框架则将这两项任务整合到了一起,并且实现了优于各自单个任务的表现。该研究的论文已被 IJCAI 2018 会议接收。

文本摘要和情感分类是自然语言处理领域内的两大重要任务。文本摘要的目的是生成带有原始文本的要点的摘要。相比于从原始文本的已有词汇中选取一个子集来构建摘要的抽取式摘要(extractive summarization),抽象式摘要(abstractive summarization)是构建一个内部语义表征然后使用自然语言生成技术来创建摘要,这种方式可能接近人类的表达方式。我们在本研究中主要关注抽象式文本摘要。情感分类是给文本分配一个情感标签,以确定文本中的态度或意见。这也被称为意见挖掘(opinion mining),即提取导出说话人的意见或态度。文本摘要和情感分类的目标都是挖掘文本的主要思想。文本摘要是以更为具体的方式使用词和句子来描述文本,而情感分类则是以更为抽象的方式使用标签总结文本。

大多数现有的模型要么是为摘要设计的,要么就是为分类设计的。对于抽象式文本摘要而言,最受欢迎的是序列到序列模型 [Sutskever et al., 2014; Rush et al., 2015],其中生成长源文本的短摘要可以被看作是长序列和短序列之间的映射。这种模型由一个编码器和一个解码器构成。编码器将源文本编码成一个隐含表征,解码器则生成摘要。某些近期的抽象式摘要模型是序列到序列模型的变体 [Chopra et al., 2016; See et al., 2017]。对于情感分类,大多数近期的研究都使用了神经网络架构 [Kim, 2014; Tang et al., 2015](比如 LSTM 或 CNN)来生成文本嵌入,然后使用多层感知器(MLP)根据这个嵌入预测标签。

之前有一些研究 [Hole and Takalikar, 2013; Mane et al., 2015] 提出过能同时得到摘要和情感标签的模型。但是,这些模型是分开训练摘要部分和情感分类部分,并且需要丰富的人工设计的特征。另外也还存在一些有关情感摘要的工作 [Titov and McDonald, 2008; Lerman et al., 2009],其目标是从源文本中提取带有特定情感类别的句子。这些研究只是重在摘要,而且不能提升情感分类的表现。

在本研究中,我们探索了在一个端到端的框架中同时提升文本摘要和情感分类水平的第一步。我们提出了一种分层式端到端模型,其由一个摘要层和一个情感分类层构成。摘要层是将源文本压缩成短句子,而情感分类层是进一步将文本「总结」成一个情感类别。这种分层结构会在文本摘要和情感分类之间建立紧密的联系,因此这两个任务可以彼此提升。在通过摘要压缩了文本之后,情感分类器就能更加轻松地预测更短文本的情感标签。此外,文本摘要还能标记出重要和有信息的词,并移除对预测情感有害的冗余和误导性信息。这种情感分类能为文本摘要提供更为重要的监督信号并引导摘要组件获取源文本的情感倾向,这能提升短文本和源文本之间的一致性。

我们在亚马逊在线评论数据集上评估了我们提出的模型。实验结果表明我们的模型在抽象式摘要和情感分类上都能实现比强大的基准系统更优的表现。

本论文有下列贡献:

我们将情感分类当作是一种特定类型的摘要,并且使用一个统一的模型来执行情感分类和文本摘要。

我们提出了一种多视角注意(multi-view attention)来为摘要和情感分类获取不同的文本表征。

实验结果表明我们的模型的表现优于分开训练摘要和情感分类的强大基准。

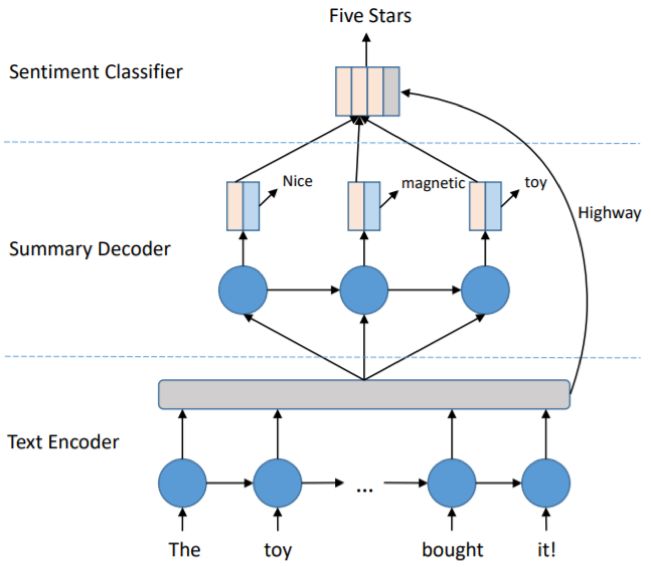

图 1 展示了我们的模型的架构。我们的模型由三个部分组成,即文本编码器、摘要解码器和情感分类器。文本编码器使用一个双向 LSTM 将源文本压缩到上下文记忆中。摘要解码器是一个单向的 LSTM,它通过查询上下文记忆使用注意机制依次生成一个摘要向量和一个情感向量。然后一个词生成器会使用其中的摘要向量来生成摘要。所有时间步骤的情感向量会被收集起来,然后输入情感分类器来预测情感标签。为了获取源文本的上下文信息,我们使用了 highway 机制,以将上下文记忆作为分类器输入的一部分。因此,该分类器可以根据摘要解码器的情感向量和文本编码器的上下文记忆来预测标签。

图 1:我们的模型的概览

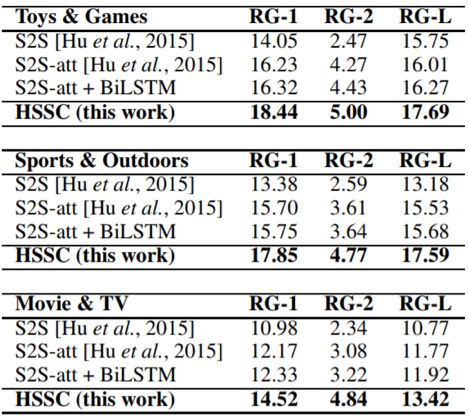

表 1:我们的模型和抽象式摘要的序列到序列基准在 Amazon SNAP 测试集上的比较。这个测试集包含三大领域:玩具&游戏、运动&户外、电影&电视。RG-1、RG-2、RG-L 分别表示 ROUGE-1、ROUGE-2、ROUGE-L。

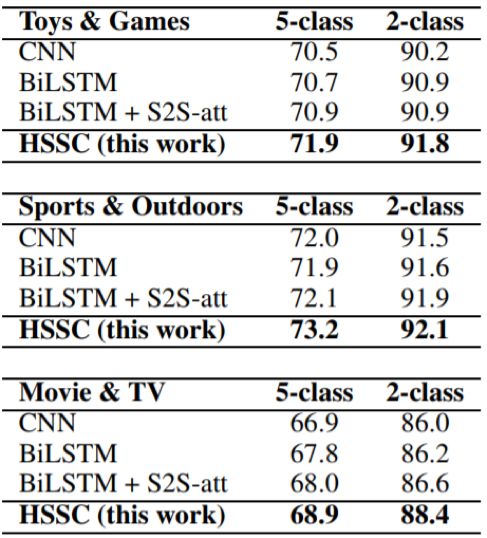

表 2:我们的模型和情感分类的序列到序列基准在 Amazon SNAP 测试集上的比较。这个测试集包含三大领域:玩具&游戏、运动&户外、电影&电视。5-class 和 2-class 分别表示五类情感和二类情感分类的准确度。

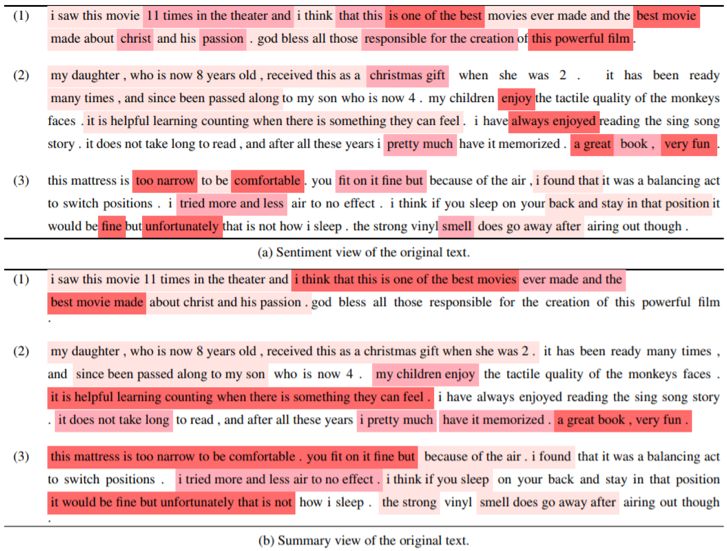

表 4:多视角注意的可视化。上部分是情感视角注意的热图,下部分是摘要视角注意的热图。颜色更深表示注意分数更高。

论文:A Hierarchical End-to-End Model for Jointly Improving Text Summarization and Sentiment Classification

论文地址:https://arxiv.org/abs/1805.01089

摘要:文本摘要和情感分类的目标都是获取文本的主要思想,但层级不同。文本摘要是为了使用少量句子描述文本,而情感分类则可以被看作是一种特定类型的摘要——将文本「总结」成更加抽象的形式,即一种情感类别。基于这一思想,我们提出了一种分层式端到端模型,可用于联合学习文本摘要和情感分类,其中情感分类标签被当作文本摘要输出的更进一步「摘要」。因此,情感分类层被放置在文本摘要层之上,并衍生出了一种分层式结构。在亚马逊在线评论数据集上的实验结果表明我们的模型在抽象式摘要和情感分类上都能实现比强大的基准系统更优的表现。

本文为机器之心编译,转载请联系本公众号获得授权。

✄------------------------------------------------

加入机器之心(全职记者/实习生):hr@jiqizhixin.com

投稿或寻求报道:content@jiqizhixin.com

广告&商务合作:bd@jiqizhixin.com