ACL 2020 | MobileBERT:一种与任务无关的模型压缩方法

要做一个预训练的小模型,用蒸馏?蒸馏完的模型要么浅,要么窄,但是这两种模型都有自己的缺点,浅的表示能力不足,窄的不好训练(毕竟还是要考虑后续 fine-tune 的)。

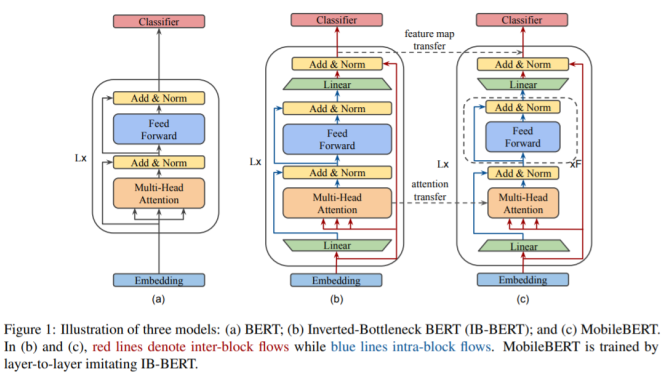

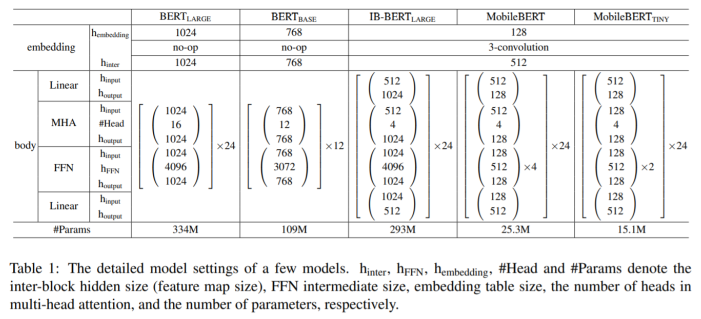

可以看到 Table1 中,MobileBERT 就是作者之前说的那种窄的模型,会很难训练。所以作者采用的方法就是先训练一个 IB-BERT-large,然后把 IB-BERT-large 学到的知识迁移到 MobileBERT 中去。

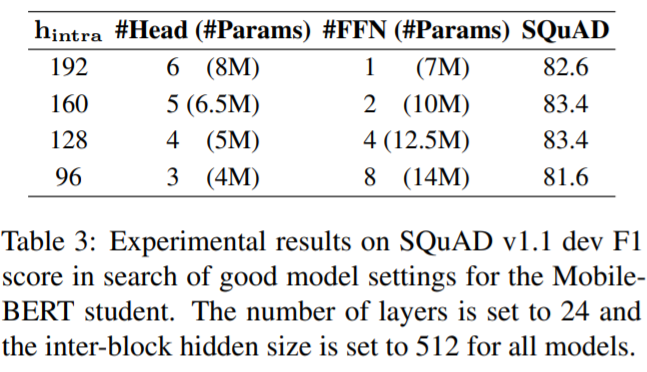

采用了 bottleneck 机制的 IB-BERT-large 也存在问题,bottleneck 机制会打破原有的 MHA(Multi Head Attention)和 FFN(Feed Forward Network)之间的平衡,原始 bert 中的两部分的功能不同,参数比大概为 1:2。采用了 bottleneck 机制会导致 MHA 中的参数更多,所以作者在这里采用了一个堆叠 FFN 的方法,增加 FFN 的参数,Table1 中也能看出。

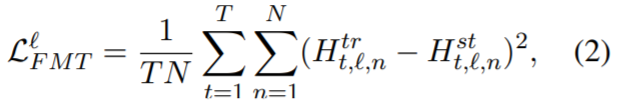

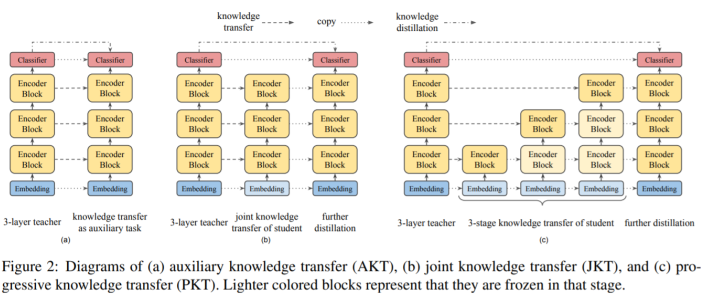

迁移策略

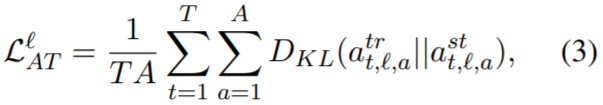

3.2 Attention Transfer (AT)

3.3 Pre-training Distillation (PD)

辅助知识迁移

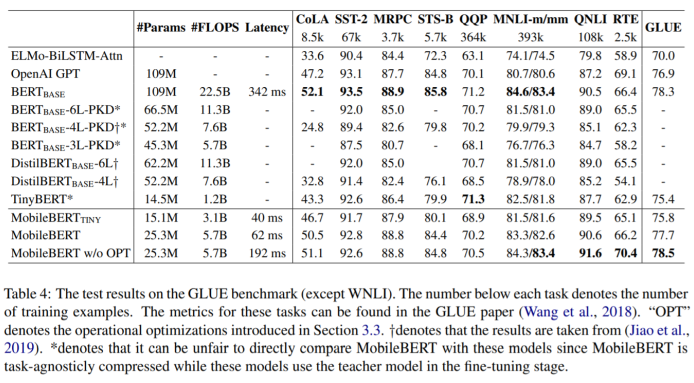

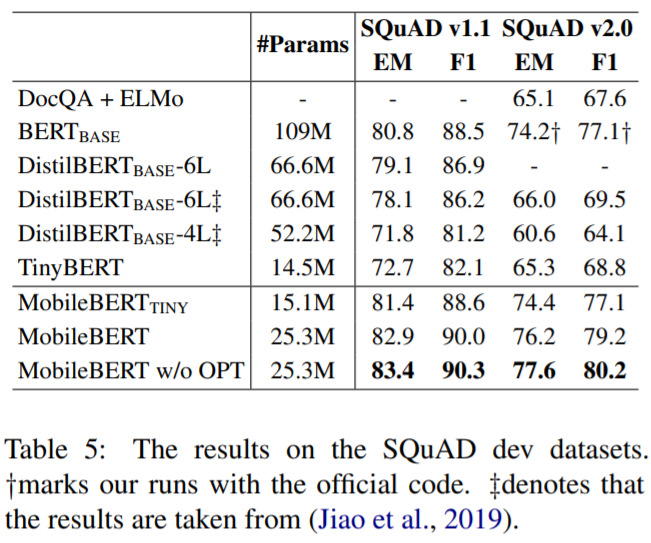

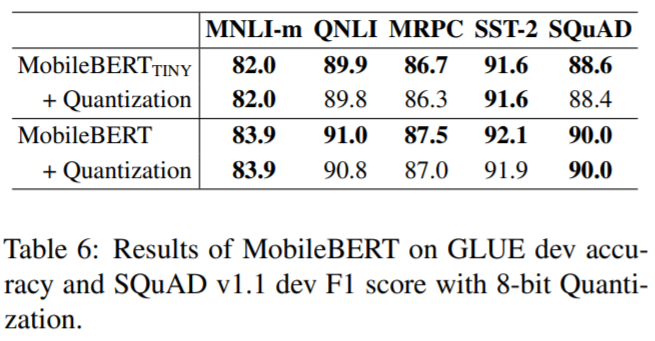

实验结果

表格还是很清晰的,就不多做解释了。

结论

本文介绍了 MobileBERT,它是 BERT 的与任务无关的紧凑型变体。流行的 NLP 基准测试 GLUE 的经验结果表明,MobileBERT 与 BERT-base 相当,但体积更小,速度更快。

更多阅读

#投 稿 通 道#

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

📝 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

📬 投稿邮箱:

• 投稿邮箱:hr@paperweekly.site

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。