【IJCAI2020】可解释人工智能最新进展,74页ppt,上海交大张拳石老师

1月11日-13日,人工智能领域国际顶级学术会议“国际人工智能联合会(IJCAI 2020)”主会将正式举办。受疫情影响,2020年度会议延迟到2021年,并采取了线上形式。

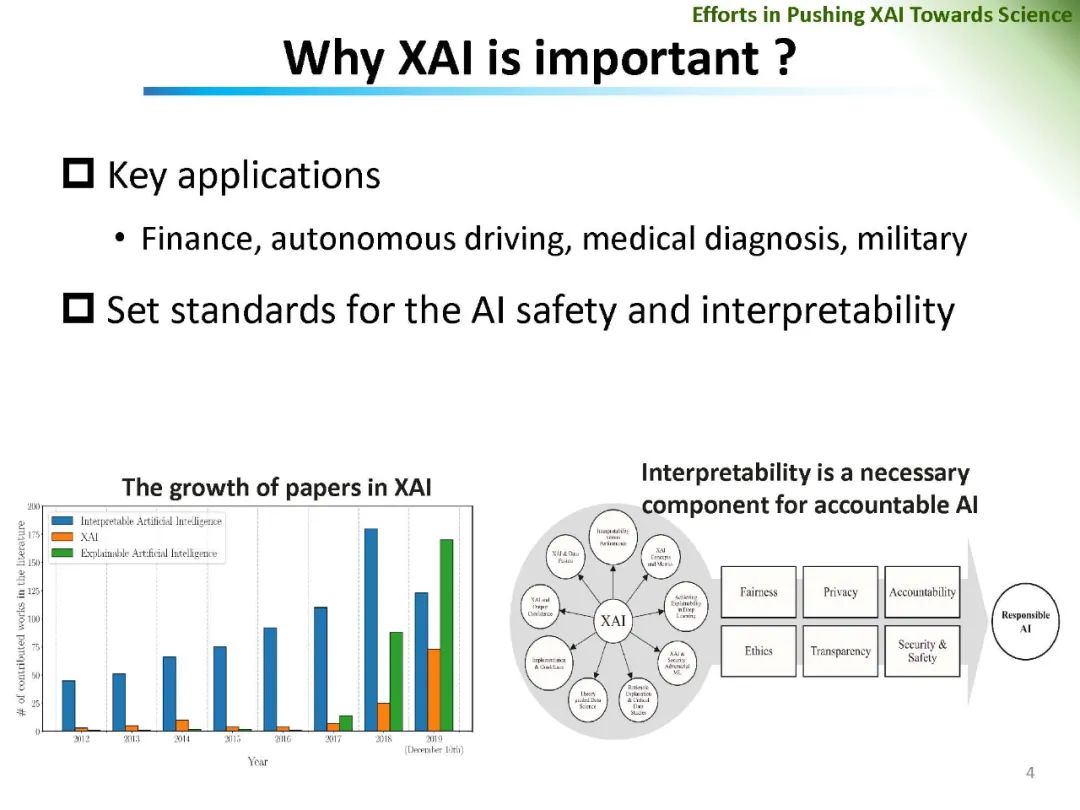

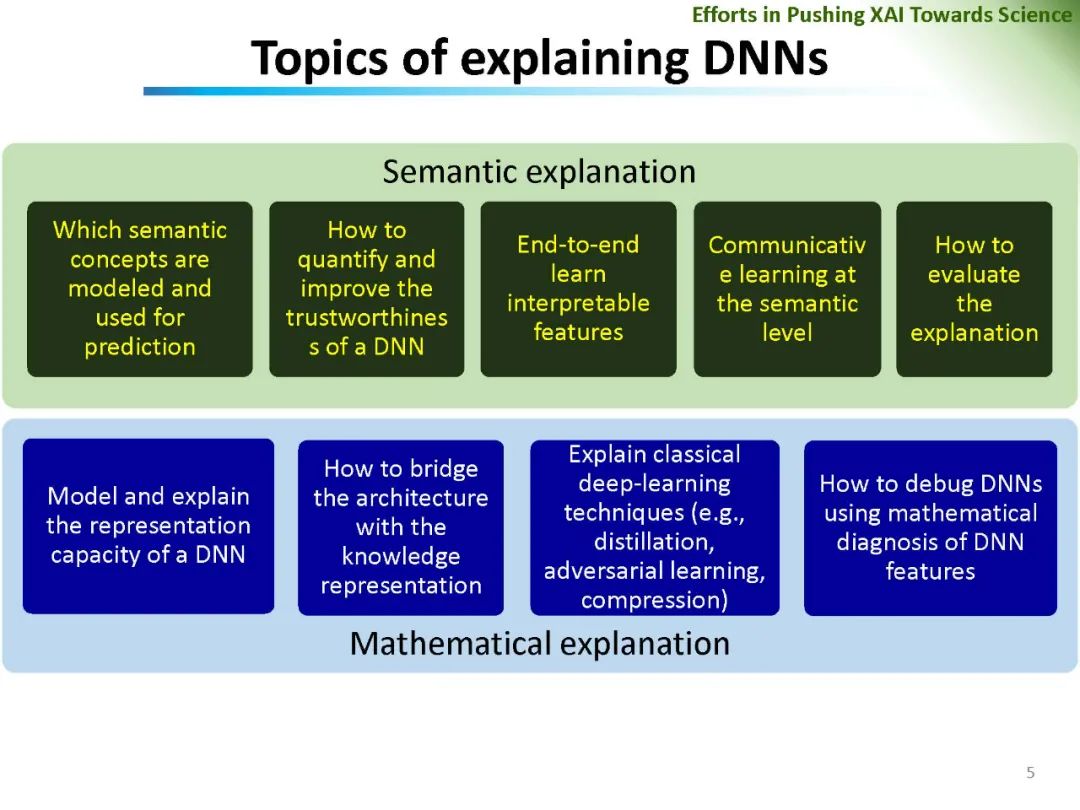

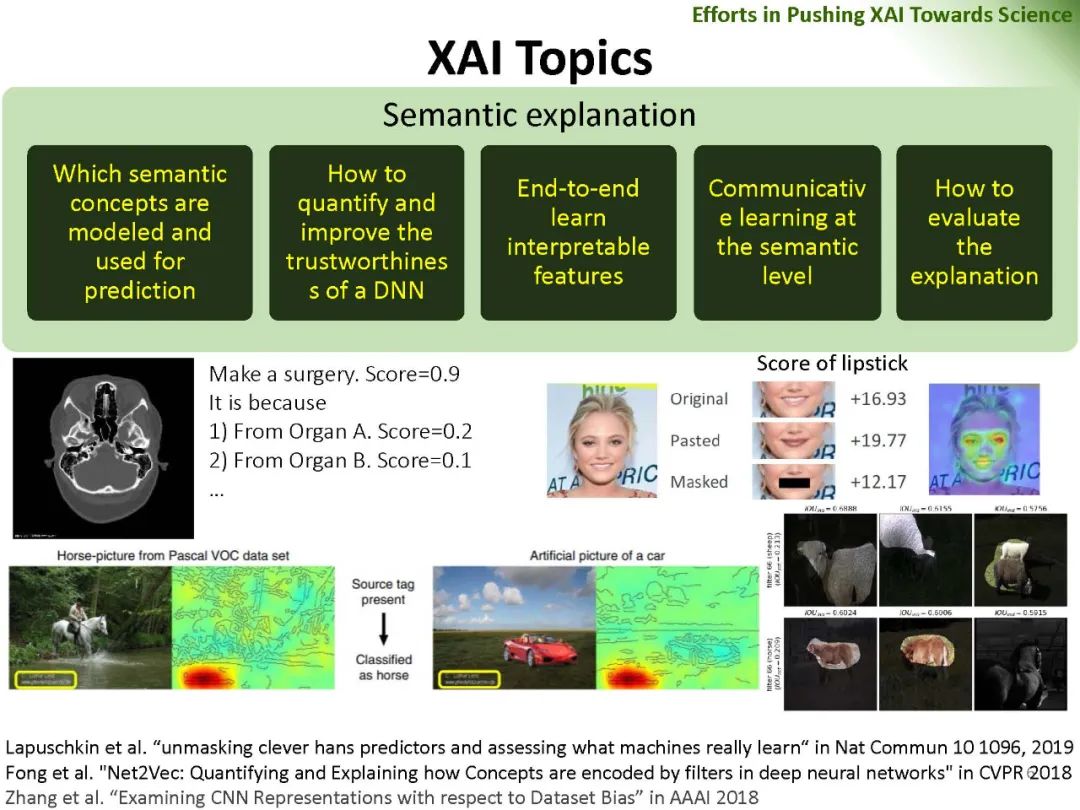

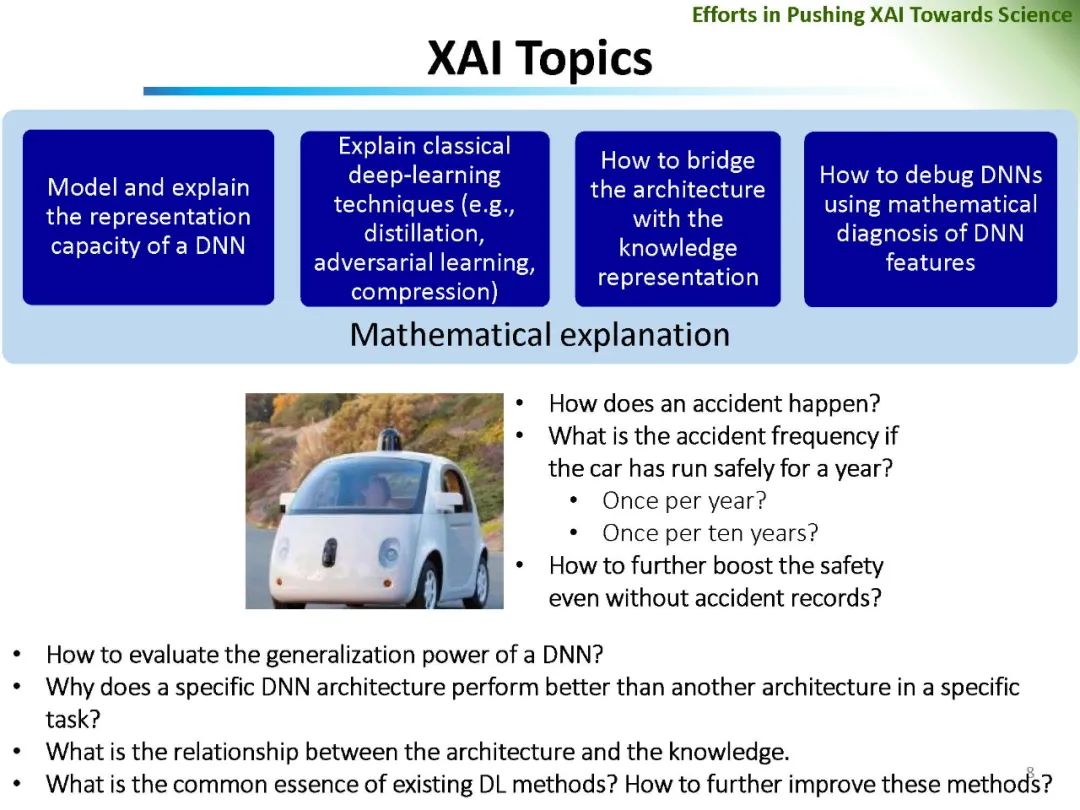

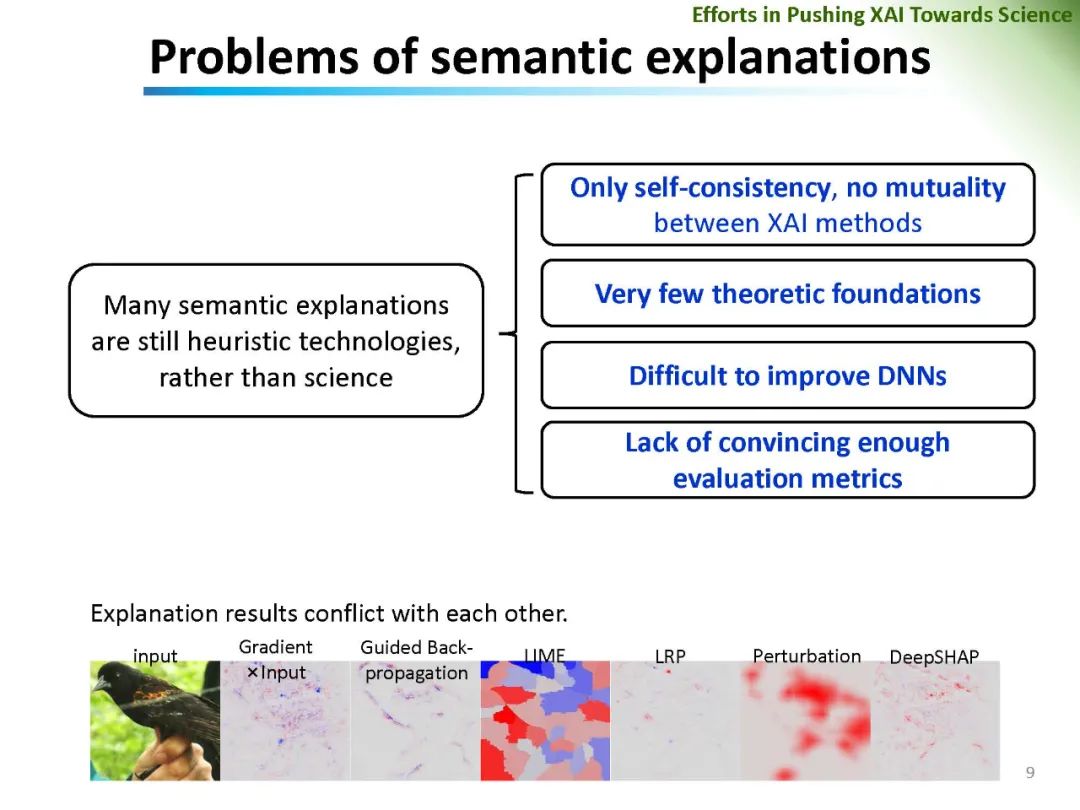

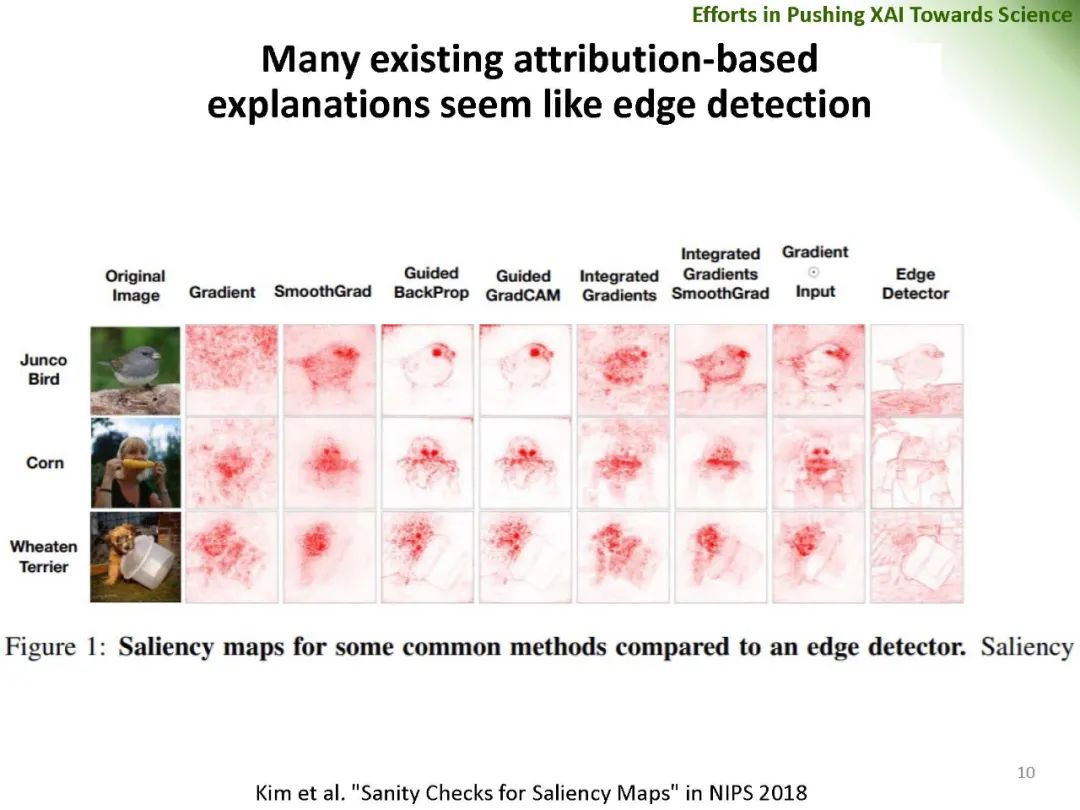

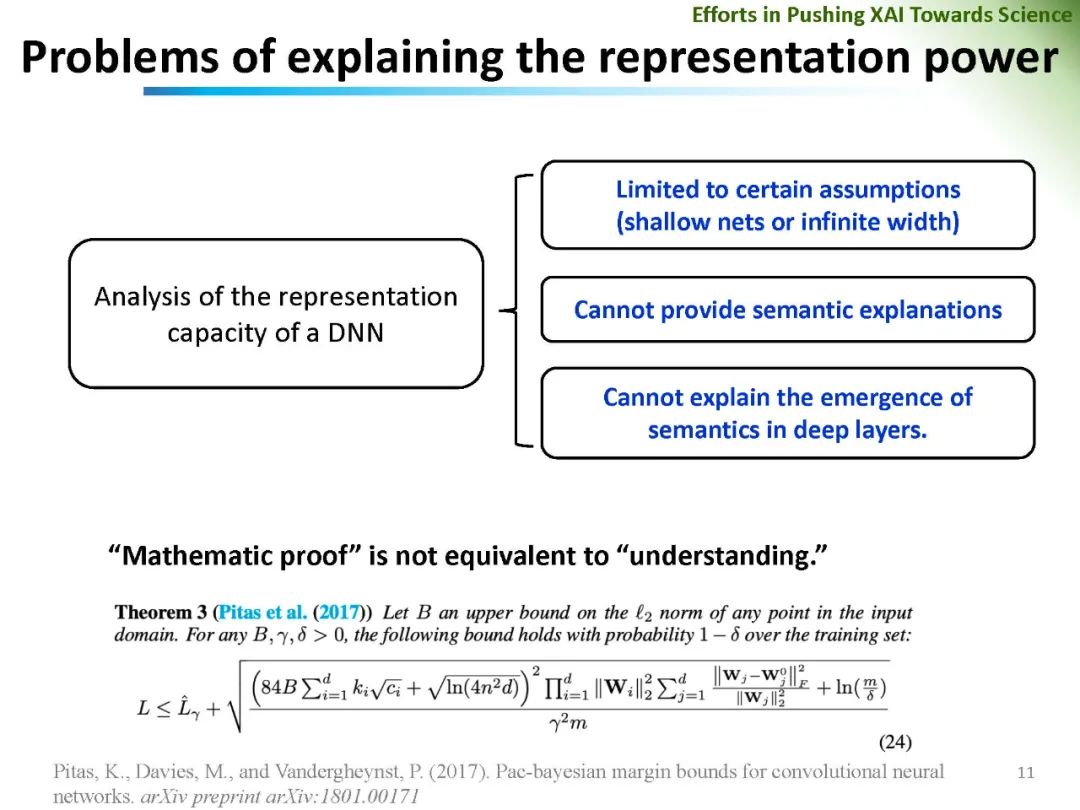

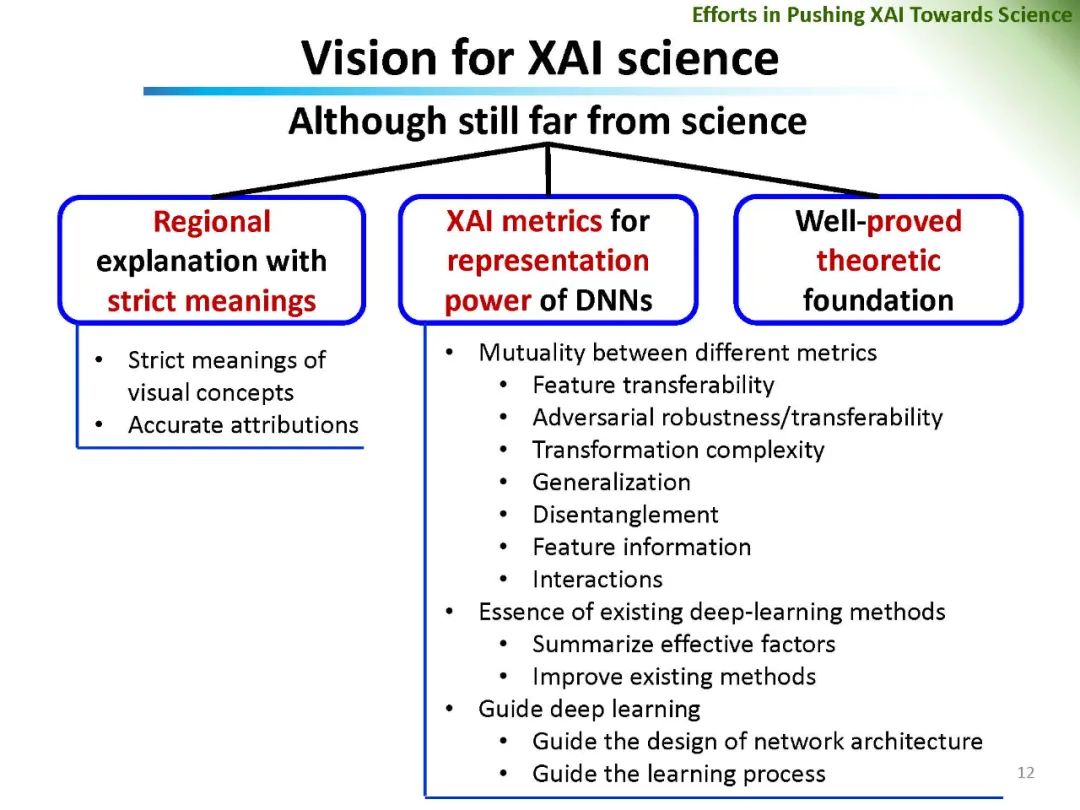

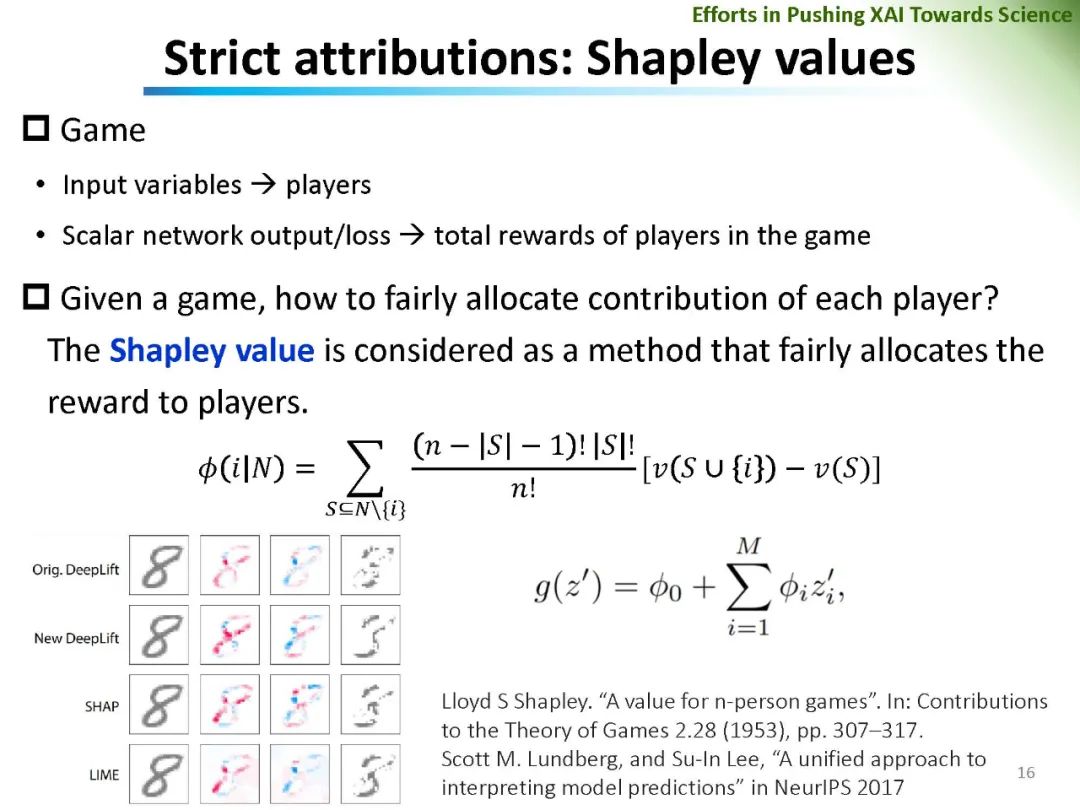

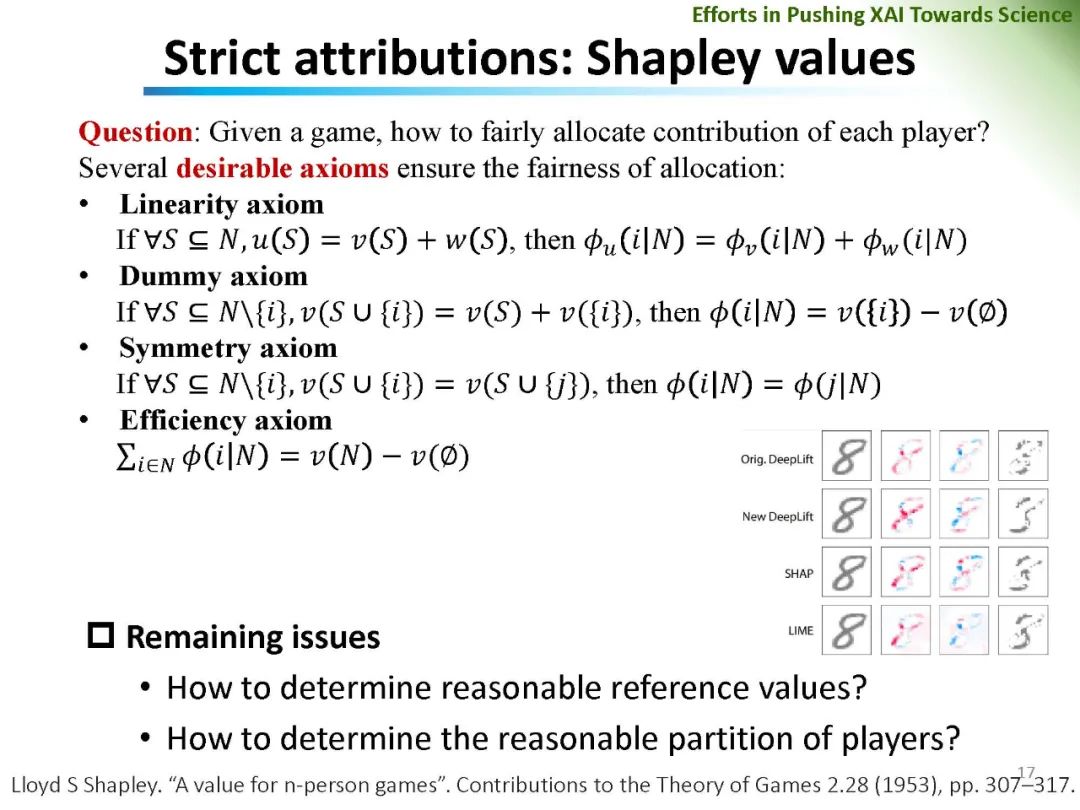

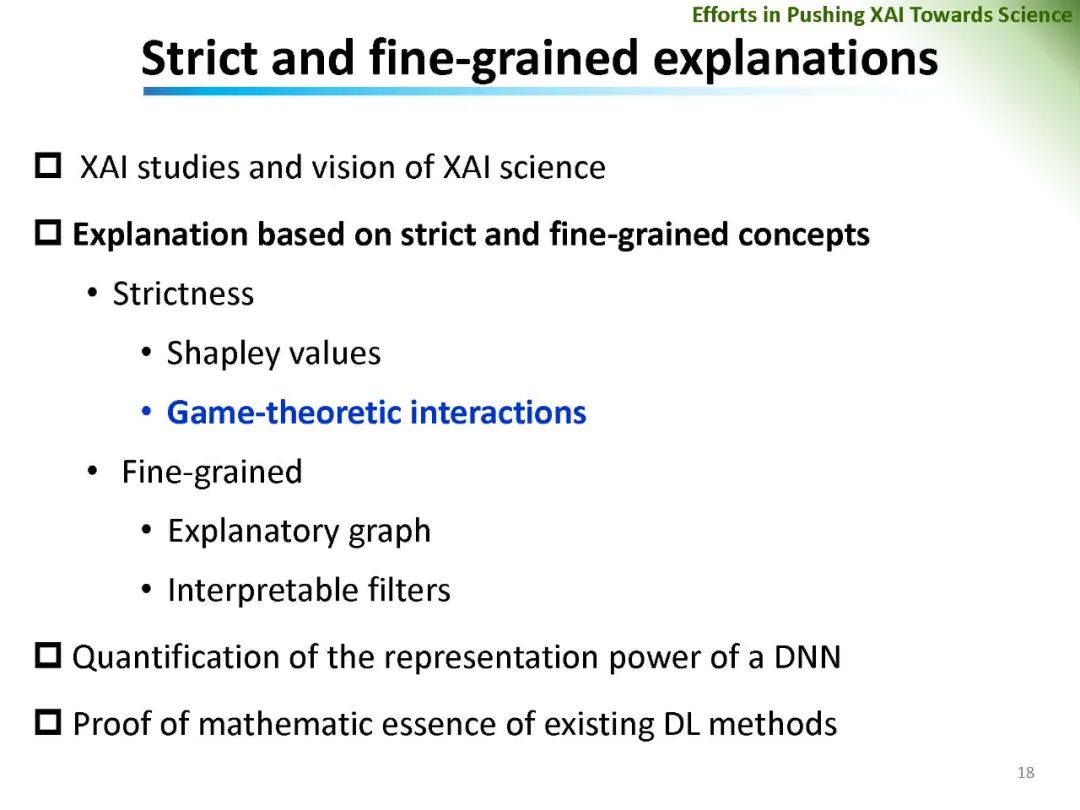

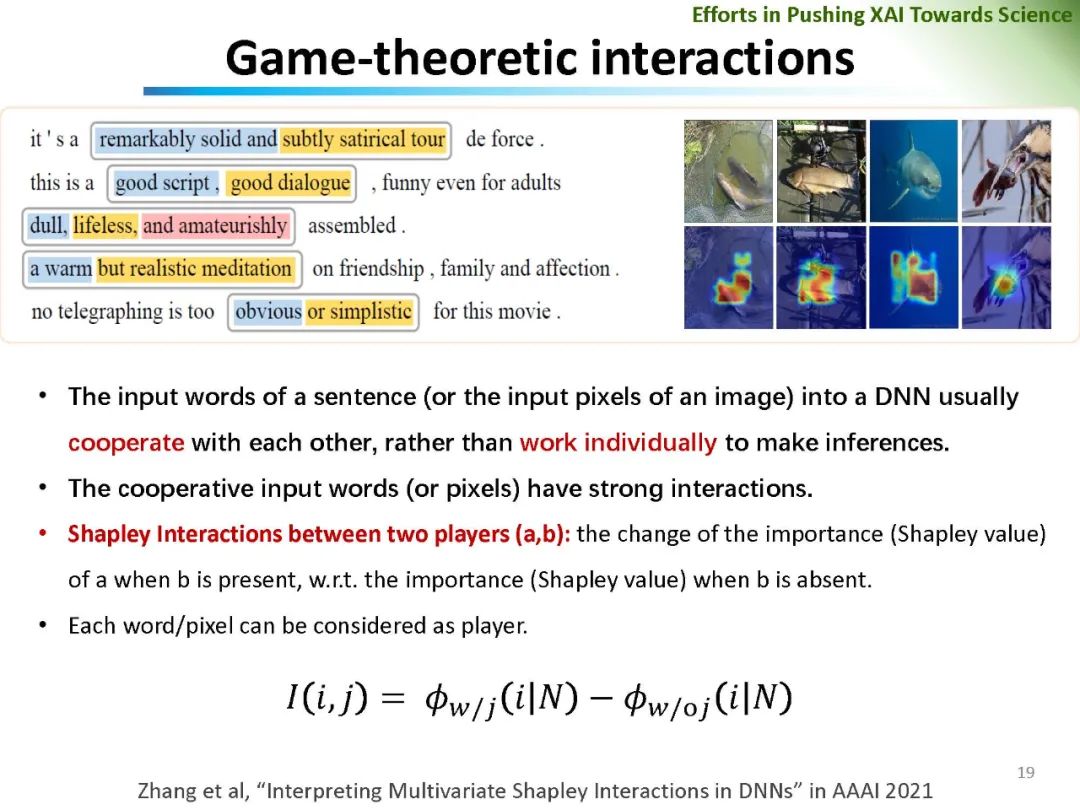

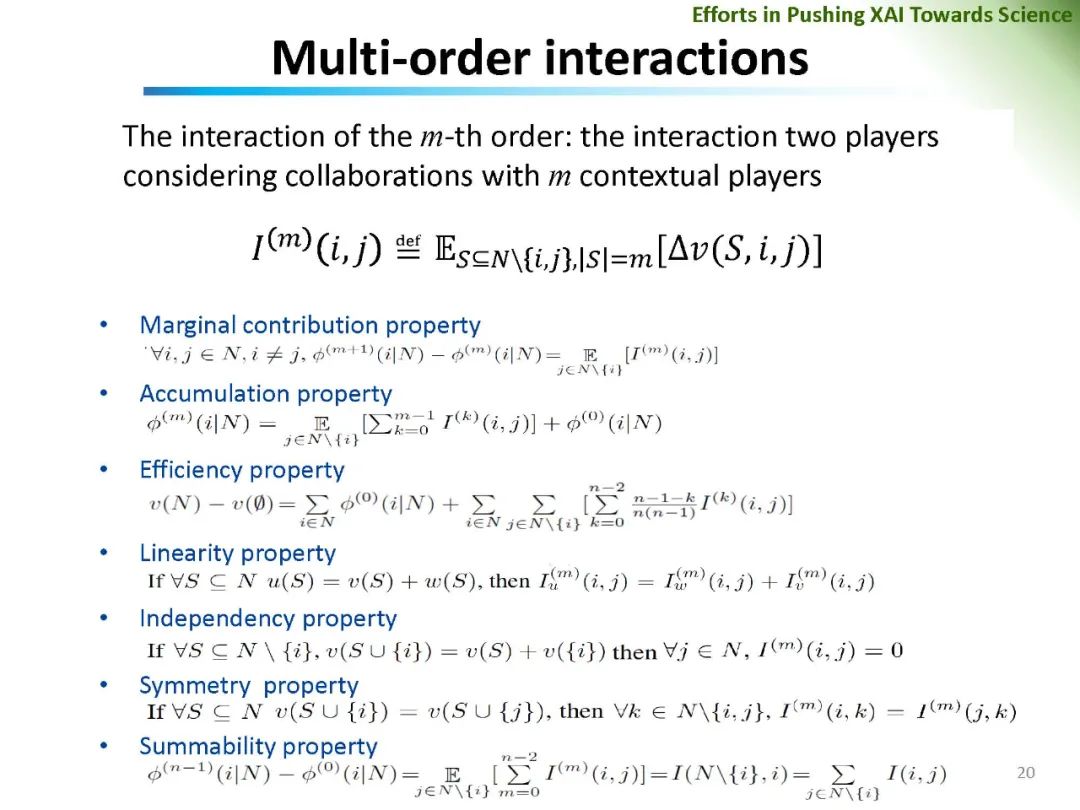

深度神经网络在计算机视觉、计算语言学和人工智能等领域的广泛应用无疑带来了巨大的成功。然而,DNNs成功的基本原理、DNNs的可信性和DNNs对抗攻击的恢复能力仍然很大程度上缺乏。在可解释人工智能的范围内,对网络预测解释可信度的量化和DNN特征可信度的分析成为一个引人注目但又有争议的话题。相关问题包括: (1)网络特征可信度的量化; (2)DNNs解释的客观性、鲁棒性、语义严谨性; (3)可解释神经网络解释性的语义严谨性等。重新思考现有可解释机器学习方法的可信性和公平性,对可解释机器学习的进一步发展具有重要的价值。

本教程旨在将关注人工智能可解释性、安全性和可靠性的研究人员、工程师以及行业从业人员聚集在一起。本教程介绍了一些关于上述问题的新发现,这些发现来自演讲者最近的论文和一些经典研究。对当前可解释人工智能算法的优点和局限性的批判性讨论提供了新的前瞻性研究方向。本教程预计将对医疗诊断、金融和自动驾驶等关键工业应用产生深远影响。

https://ijcai20interpretability.github.io/

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“XAI74” 可以获取《【IJCAI2020】可解释人工智能最新进展,74页ppt,上海交大张拳石老师》专知下载链接索引

登录查看更多

相关内容

一个可以解释的AI(Explainable AI, 简称XAI)或透明的AI(Transparent AI),其行为可以被人类容易理解。它与机器学习中“ 黑匣子 ” 的概念形成鲜明对比,这意味着复杂算法运作的“可解释性”,即使他们的设计者也无法解释人工智能为什么会做出具体决定。 XAI可用于实现社会解释的权利。有些人声称透明度很少是免费提供的,并且在人工智能的“智能”和透明度之间经常存在权衡; 随着AI系统内部复杂性的增加,这些权衡预计会变得更大。解释AI决策的技术挑战有时被称为可解释性问题。另一个考虑因素是信息(信息过载),因此,完全透明可能并不总是可行或甚至不需要。提供的信息量应根据利益相关者与智能系统的交互情况而有所不同。

https://www.darpa.mil/program/explainable-artificial-intelligence

Arxiv

0+阅读 · 2021年5月3日