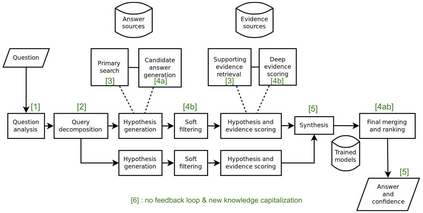

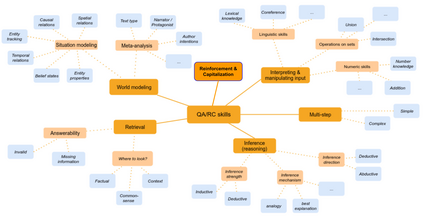

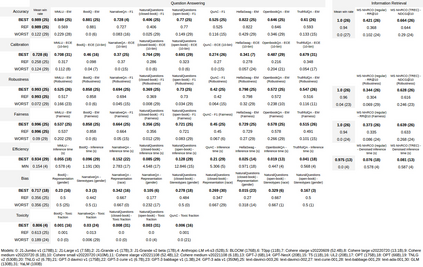

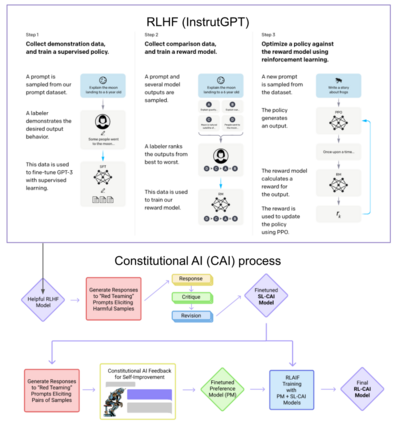

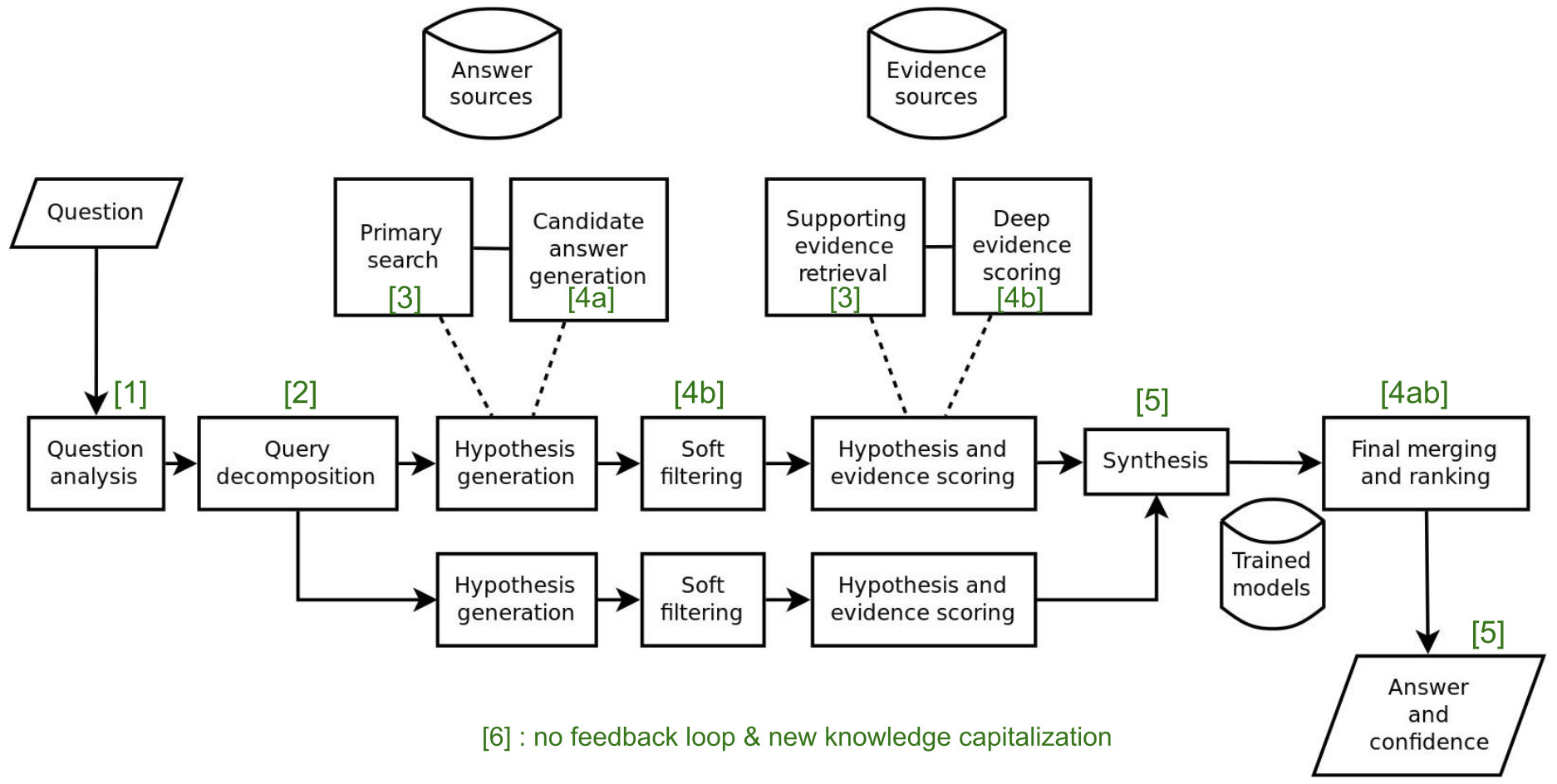

This paper reviews the state-of-the-art of hybrid language models architectures and strategies for "complex" question-answering (QA, CQA, CPS). Large Language Models (LLM) are good at leveraging public data on standard problems but once you want to tackle more specific complex questions or problems you may need specific architecture, knowledge, skills, methods, sensitive data protection, explainability, human approval and versatile feedback... We identify key elements augmenting LLM to solve complex questions or problems. We extend findings from the robust community edited research papers BIG, BLOOM and HELM which open source, benchmark and analyze limits and challenges of LLM in terms of tasks complexity and strict evaluation on accuracy (e.g. fairness, robustness, toxicity, ...). Recent projects like ChatGPT and GALACTICA have allowed non-specialists to grasp the great potential as well as the equally strong limitations of language models in complex QA. Hybridizing these models with different components could allow to overcome these different limits and go much further. We discuss some challenges associated with complex QA, including domain adaptation, decomposition and efficient multi-step QA, long form and non-factoid QA, safety and multi-sensitivity data protection, multimodal search, hallucinations, explainability and truthfulness, temproal reasoning. Therefore, we analyze current solutions and promising research trends, using elements such as: hybrid LLM architectures, active human reinforcement learning supervised with AI, prompting adaptation, neuro-symbolic and structured knowledge grounding, program synthesis, iterated decomposition and others.

翻译:本文回顾了混合语言模型结构的最新工艺以及“复合”问答(QA、CQA、CPS)战略。大语言模型(LLM)在利用标准问题的公共数据方面十分有效,但一旦你想解决更具体的复杂问题或问题,你可能需要具体的架构、知识、技能、方法、敏感数据保护、可解释性、人文认可和多功能反馈...我们确定关键要素,扩大LLM,以解决复杂的问题或问题。我们扩展了由社区编辑的扎实混合研究文件BIG、BLOOM和HELM的研究结果,这些研究文件在任务复杂性和准确性(例如公平、稳健、毒性......)方面开放源、基准和分析LLMM的局限性和挑战。 热点和GALTICA等近期项目使非专业人员能够抓住复杂的结构、知识、知识、透明性读取性和高效率的多功能性数据流学、透明性数据流学 QA,我们讨论了与复杂的QA相关的一些挑战,包括域适应性、分解性、透明性研究、透明性、透明性研究、透明性研究、透明性、透明性、透明性、多层次数据流数据流分析性、透明性、透明性、透明性分析性等结构、透明性数据流、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、解释性、解释性、解释性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性、透明性等等等等等等等等等等等数据流、解释性、解释性、解释性、解释性、解释性、解释性、解释性、解释性、解释性、解释性、解释性、解释性、解释性、透明性、透明性、透明性、透明性、解释性、透明性、解释性、解释性、透明性、透明性、透明性、透明性、透明性</s>