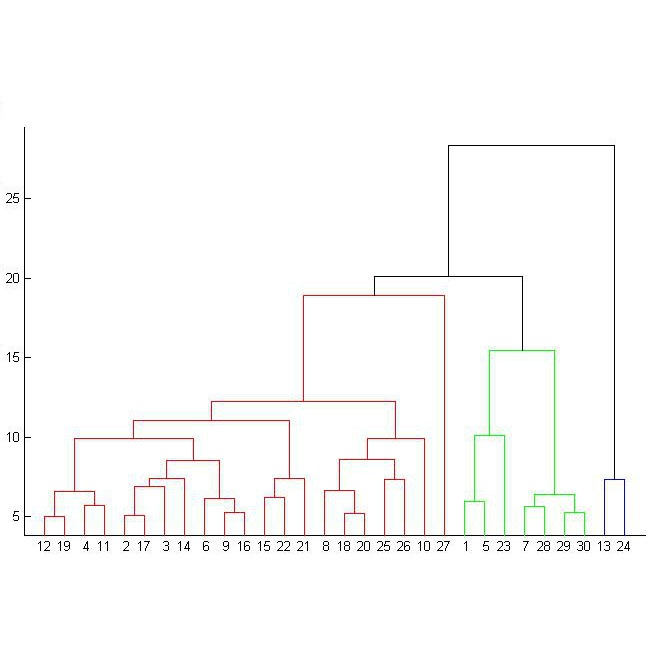

Speaker embeddings (x-vectors) extracted from very short segments of speech have recently been shown to give competitive performance in speaker diarization. We generalize this recipe by extracting from each speech segment, in parallel with the x-vector, also a diagonal precision matrix, thus providing a path for the propagation of information about the quality of the speech segment into a PLDA scoring backend. These precisions quantify the uncertainty about what the values of the embeddings might have been if they had been extracted from high quality speech segments. The proposed probabilistic embeddings (x-vectors with precisions) are interfaced with the PLDA model by treating the x-vectors as hidden variables and marginalizing them out. We apply the proposed probabilistic embeddings as input to an agglomerative hierarchical clustering (AHC) algorithm to do diarization in the DIHARD'19 evaluation set. We compute the full PLDA likelihood 'by the book' for each clustering hypothesis that is considered by AHC. We do joint discriminative training of the PLDA parameters and of the probabilistic x-vector extractor. We demonstrate accuracy gains relative to a baseline AHC algorithm, applied to traditional xvectors (without uncertainty), and which uses averaging of binary log-likelihood-ratios, rather than by-the-book scoring.

翻译:从极短部分演讲中提取的演讲器嵌入器(x-victors)最近显示,在演讲器的分层中,我们通过从每个演讲段中提取与x-victor平行的斜体精度矩阵,并同时提取一个对角精度矩阵,将这一配方推广到PLDA的评分后端。这些精确度量化了嵌入器值的不确定性,如果是从高质量演讲段中提取的话,这些嵌入器的值可能是什么。提议的概率嵌入器(具有精确度的x-victors)与PLDA模型相互配合,将X-victors作为隐藏变量对待,将其边缘化。我们采用提议的概率嵌入方法,将语音部分质量信息传播到PLHARD'19的评分盘中。我们为AHCS所考虑的每个组合假设都计算了全PLDA可能性的“根据书”值。我们联合对PLDA参数进行了歧视性培训,而将稳定性嵌进度的逻辑用于X-Basiralalimalal-alalalal-hal-hal-bal-hal-hationalbal-xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxbalbalbalbalbalbalbalbalbalbalbalbalbalbalbal-我们使用。