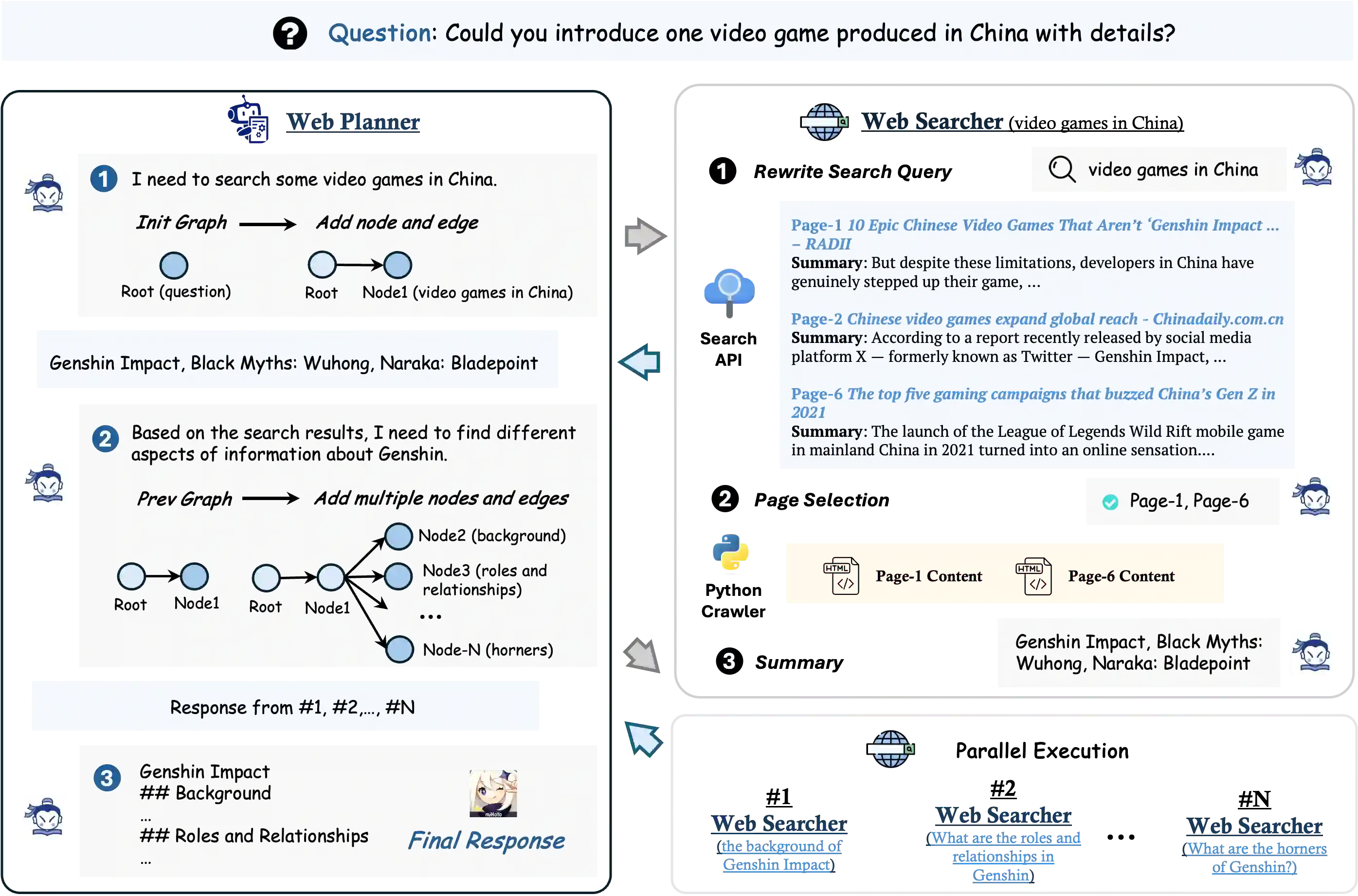

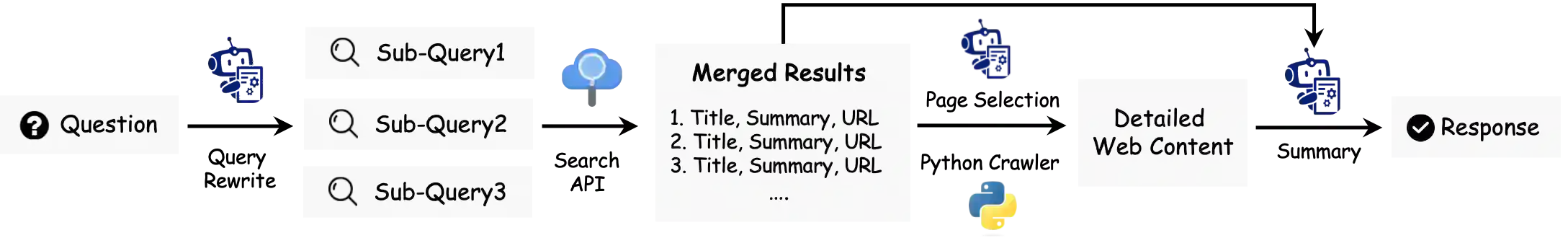

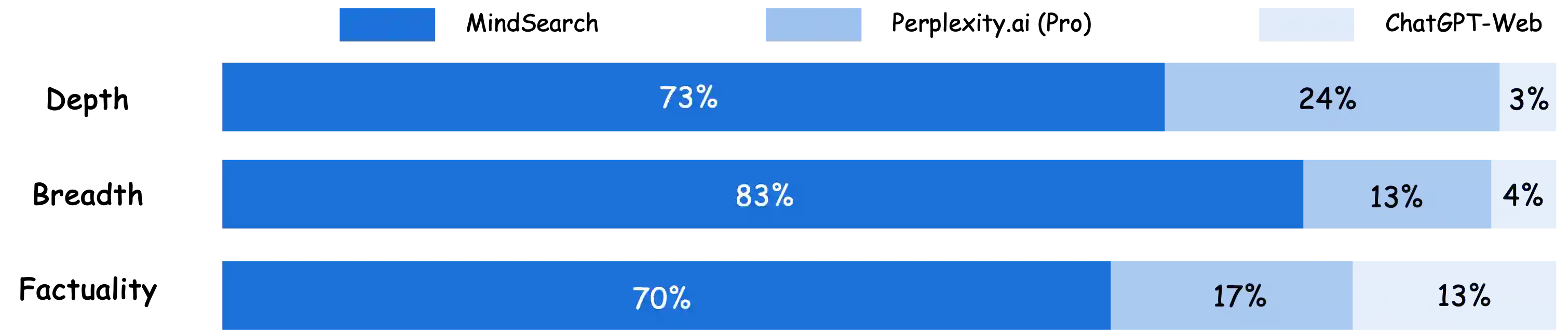

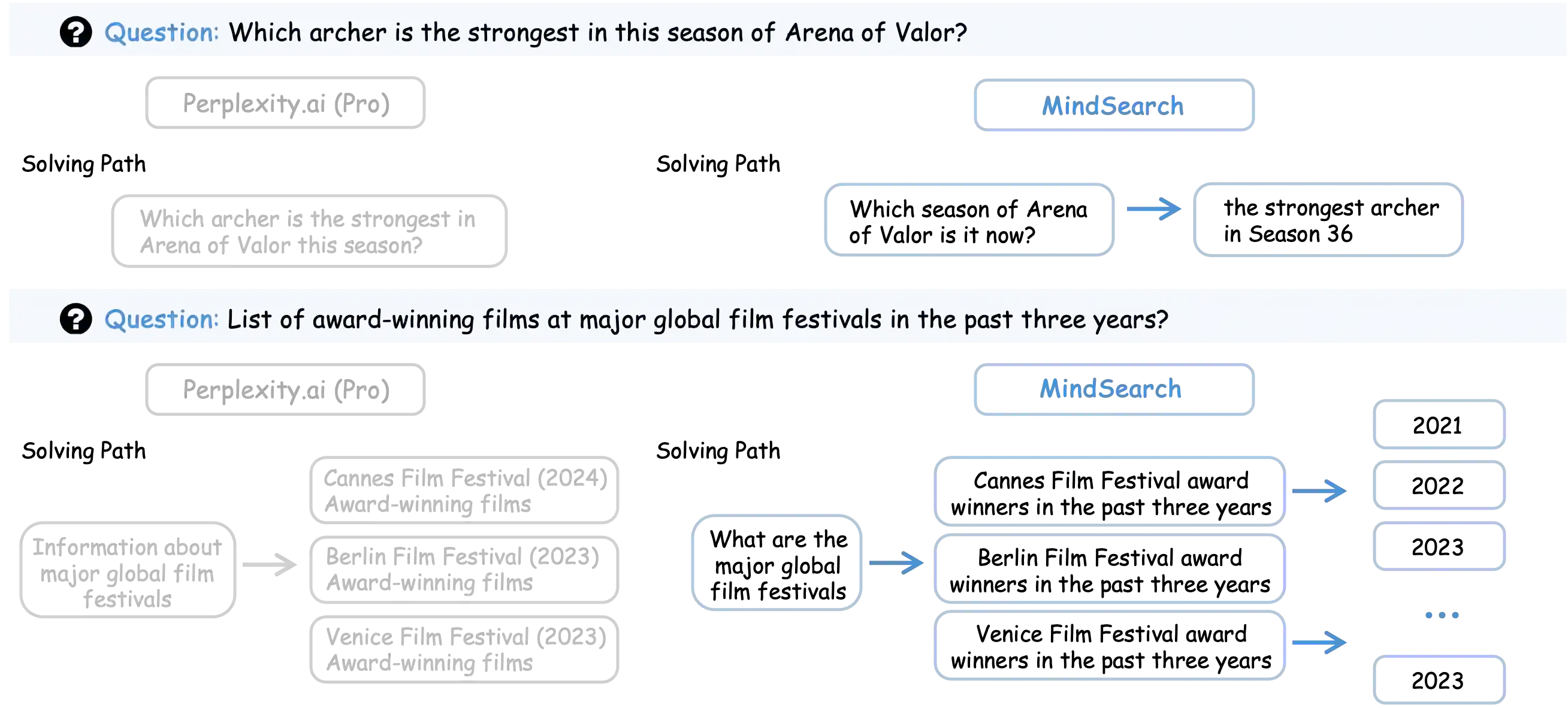

Information seeking and integration is a complex cognitive task that consumes enormous time and effort. Inspired by the remarkable progress of Large Language Models, recent works attempt to solve this task by combining LLMs and search engines. However, these methods still obtain unsatisfying performance due to three challenges: (1) complex requests often cannot be accurately and completely retrieved by the search engine once (2) corresponding information to be integrated is spread over multiple web pages along with massive noise, and (3) a large number of web pages with long contents may quickly exceed the maximum context length of LLMs. Inspired by the cognitive process when humans solve these problems, we introduce MindSearch to mimic the human minds in web information seeking and integration, which can be instantiated by a simple yet effective LLM-based multi-agent framework. The WebPlanner models the human mind of multi-step information seeking as a dynamic graph construction process: it decomposes the user query into atomic sub-questions as nodes in the graph and progressively extends the graph based on the search result from WebSearcher. Tasked with each sub-question, WebSearcher performs hierarchical information retrieval with search engines and collects valuable information for WebPlanner. The multi-agent design of MindSearch enables the whole framework to seek and integrate information parallelly from larger-scale (e.g., more than 300) web pages in 3 minutes, which is worth 3 hours of human effort. MindSearch demonstrates significant improvement in the response quality in terms of depth and breadth, on both close-set and open-set QA problems. Besides, responses from MindSearch based on InternLM2.5-7B are preferable by humans to ChatGPT-Web and Perplexity.ai applications, which implies that MindSearch can already deliver a competitive solution to the proprietary AI search engine.

翻译:信息检索与整合是一项复杂的认知任务,需要耗费大量时间和精力。受大语言模型显著进展的启发,近期研究尝试通过结合大语言模型与搜索引擎来解决这一任务。然而,由于三个挑战,这些方法仍未能取得令人满意的性能:(1)复杂请求通常无法被搜索引擎一次性准确且完整地检索;(2)待整合的相关信息分散在多个网页中,且伴随大量噪声;(3)大量内容冗长的网页可能迅速超出大语言模型的最大上下文长度。受人类解决此类问题认知过程的启发,我们提出MindSearch来模拟人类在网络信息检索与整合中的思维模式,该框架可通过一个简单而有效的大语言模型多智能体架构实现。WebPlanner将人类多步骤信息检索的思维建模为动态图构建过程:它将用户查询分解为原子子问题作为图中的节点,并根据WebSearcher的搜索结果逐步扩展该图。针对每个子问题,WebSearcher通过搜索引擎执行分层信息检索,并为WebPlanner收集有价值的信息。MindSearch的多智能体设计使得整个框架能够在3分钟内从更大规模(例如超过300个)的网页中并行检索与整合信息,这相当于人类3小时的工作量。MindSearch在封闭集和开放集问答问题上的响应质量在深度和广度方面均表现出显著提升。此外,基于InternLM2.5-7B的MindSearch生成的响应在人类评估中优于ChatGPT-Web和Perplexity.ai应用,这表明MindSearch已能为专有AI搜索引擎提供具有竞争力的解决方案。