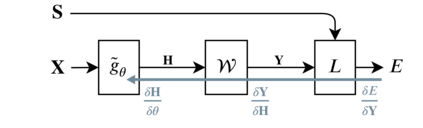

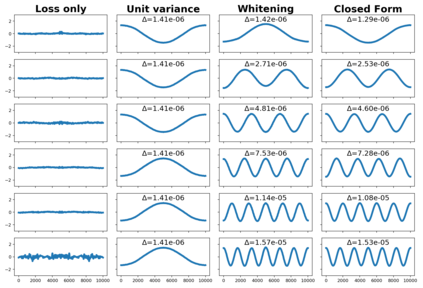

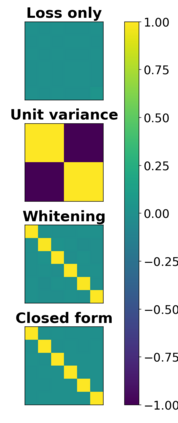

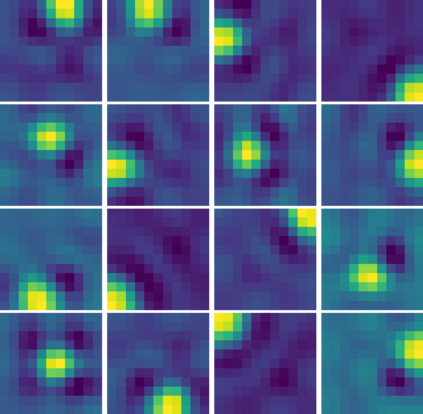

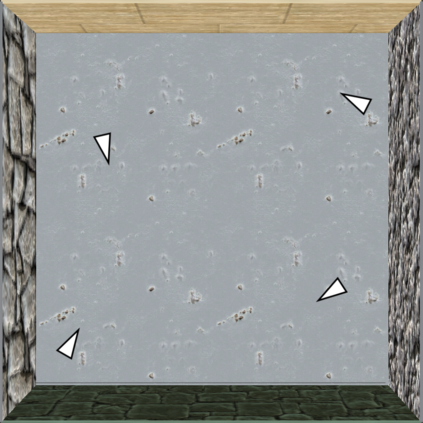

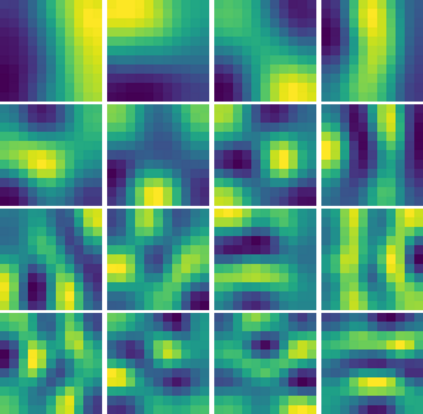

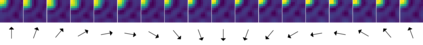

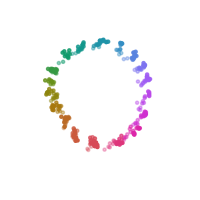

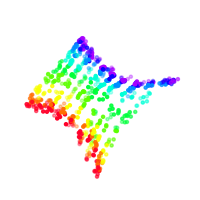

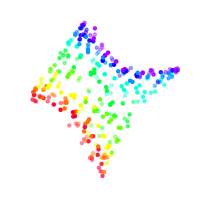

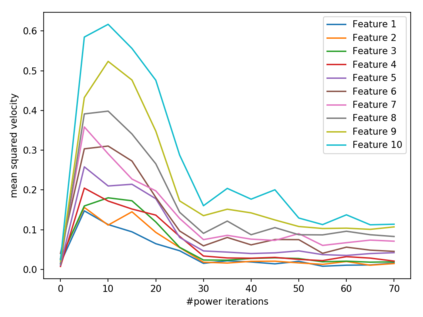

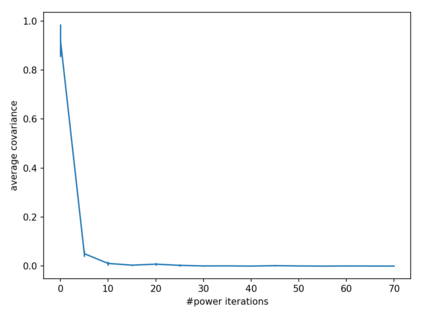

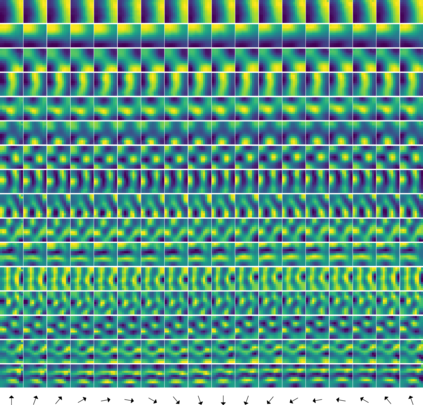

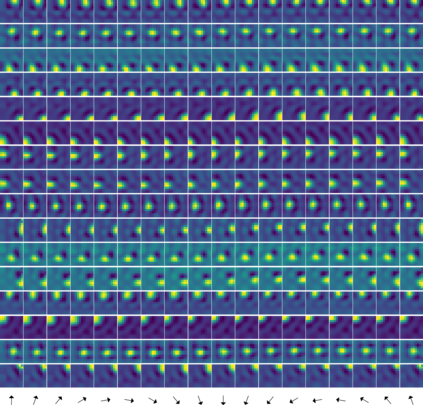

We propose Power Slow Feature Analysis, a gradient-based method to extract temporally slow features from a high-dimensional input stream that varies on a faster time-scale, as a variant of Slow Feature Analysis (SFA) that allows end-to-end training of arbitrary differentiable architectures and thereby significantly extends the class of models that can effectively be used for slow feature extraction. We provide experimental evidence that PowerSFA is able to extract meaningful and informative low-dimensional features in the case of (a) synthetic low-dimensional data, (b) ego-visual data, and also for (c) a general dataset for which symmetric non-temporal similarities between points can be defined.

翻译:我们提议采用“慢速地貌分析”这一梯度方法,从高速时间尺度不同的高维输入流中提取时间缓慢的特征,作为“慢地貌分析”的变体,允许对任意差异建筑进行端到端培训,从而大大扩展可有效用于慢速地貌提取的模型类别。 我们提供实验证据,证明PowerSFA能够从(a) 合成低维数据、(b) 自我视觉数据以及(c) 可界定各点之间对称非时相似性的一般数据集中提取有意义和内容丰富的低维特征。