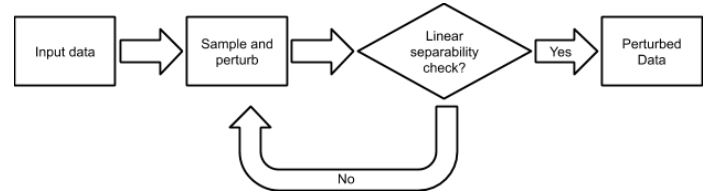

Artificial intelligence (AI) is becoming increasingly more popular and can be found in workplaces and homes around the world. However, how do we ensure trust in these systems? Regulation changes such as the GDPR mean that users have a right to understand how their data has been processed as well as saved. Therefore if, for example, you are denied a loan you have the right to ask why. This can be hard if the method for working this out uses "black box" machine learning techniques such as neural networks. TrustyAI is a new initiative which looks into explainable artificial intelligence (XAI) solutions to address trustworthiness in ML as well as decision services landscapes. In this paper we will look at how TrustyAI can support trust in decision services and predictive models. We investigate techniques such as LIME, SHAP and counterfactuals, benchmarking both LIME and counterfactual techniques against existing implementations. We also look into an extended version of SHAP, which supports background data selection to be evaluated based on quantitative data and allows for error bounds.

翻译:人工智能(AI)越来越受欢迎,可以在世界各地的工作场所和家庭中找到。然而,我们如何确保信任这些系统?监管的变化,例如GDPR意味着用户有权了解其数据是如何被处理和保存的。因此,例如,如果拒绝贷款,你有权问原因。如果这项工作的方法使用“黑盒子”机器学习技术,例如神经网络等,这可能会很困难。 TrustyyyAI是一个新的倡议,它研究可解释的人工智能(XAI)解决方案,以解决ML的可信度以及决策服务景观。我们将在本文中审视信任国际如何支持对决策服务和预测模型的信任。我们调查LIME、SHAP和反现实技术等技术,将LIME和反现实技术与现有的实施相比。我们还研究一个扩展版本的SHAP,它支持根据量化数据来评估背景数据选择,并允许有误差。