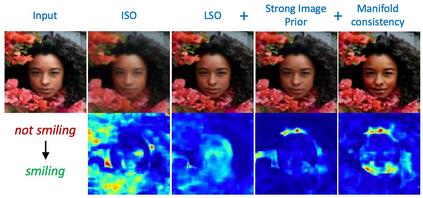

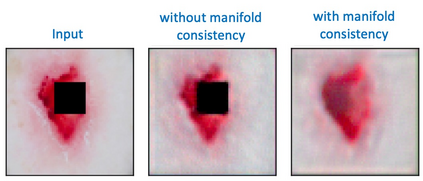

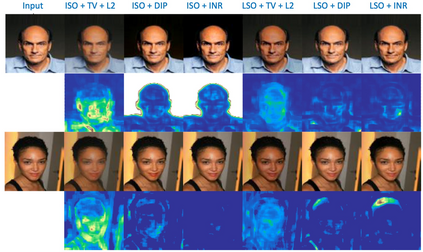

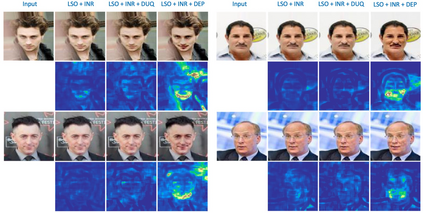

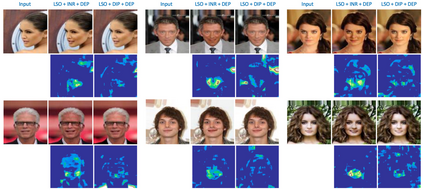

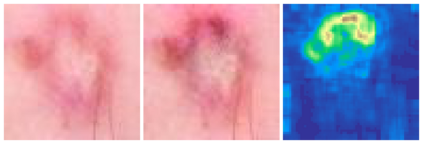

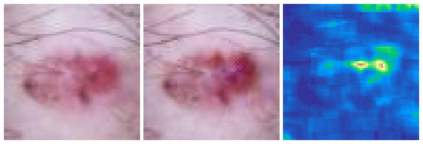

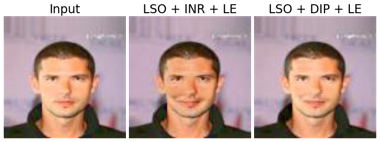

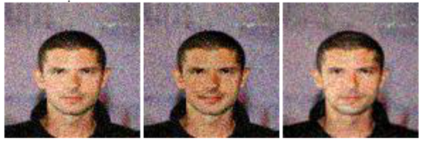

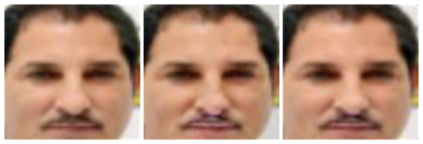

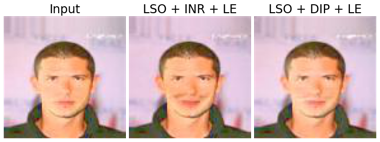

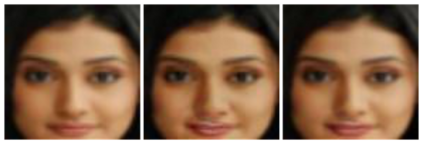

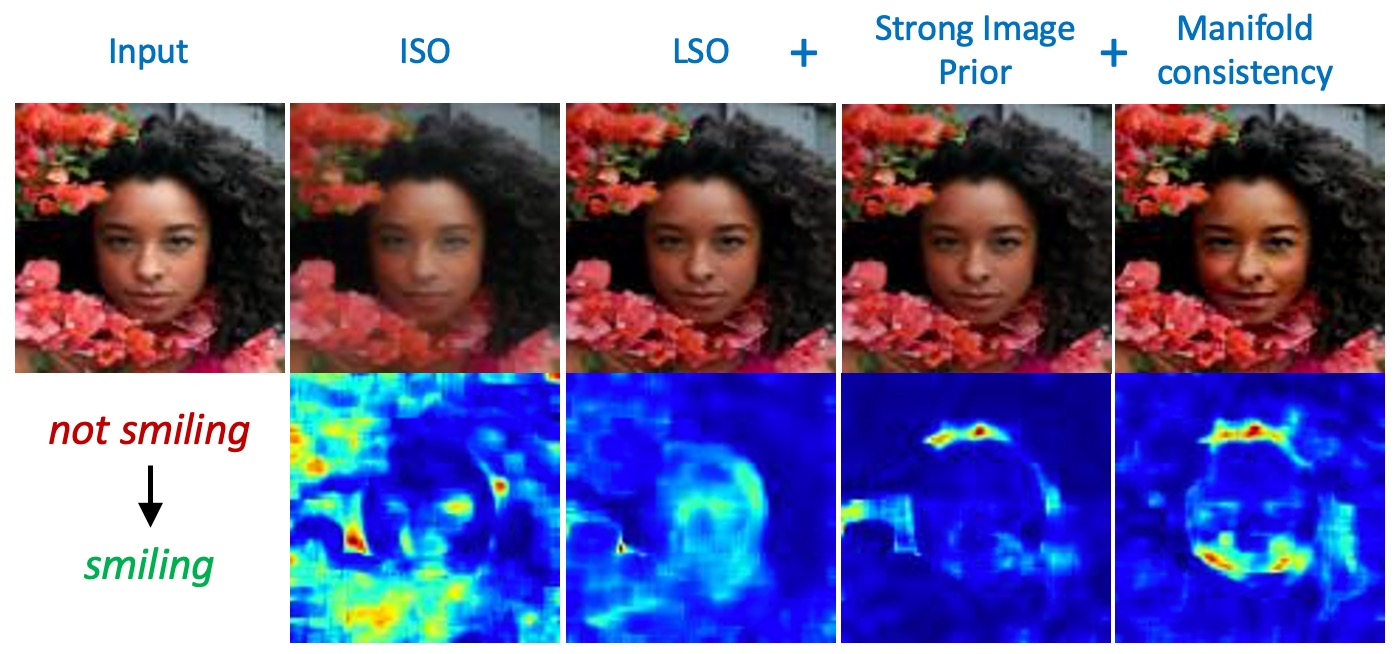

Explanation techniques that synthesize small, interpretable changes to a given image while producing desired changes in the model prediction have become popular for introspecting black-box models. Commonly referred to as counterfactuals, the synthesized explanations are required to contain discernible changes (for easy interpretability) while also being realistic (consistency to the data manifold). In this paper, we focus on the case where we have access only to the trained deep classifier and not the actual training data. While the problem of inverting deep models to synthesize images from the training distribution has been explored, our goal is to develop a deep inversion approach to generate counterfactual explanations for a given query image. Despite their effectiveness in conditional image synthesis, we show that existing deep inversion methods are insufficient for producing meaningful counterfactuals. We propose DISC (Deep Inversion for Synthesizing Counterfactuals) that improves upon deep inversion by utilizing (a) stronger image priors, (b) incorporating a novel manifold consistency objective and (c) adopting a progressive optimization strategy. We find that, in addition to producing visually meaningful explanations, the counterfactuals from DISC are effective at learning classifier decision boundaries and are robust to unknown test-time corruptions.

翻译:将小的、可解释的改变合成给特定图像,同时对模型预测进行预期的修改,这些解释技术在对黑盒模型进行内窥探时变得很受欢迎。通常被称为反事实,综合解释需要包含明显的变化(便于解释),同时也是现实的(与数据多重的一致性)。在本文中,我们侧重于我们只能接触受过训练的深层分类者而不是实际培训数据的案例。虽然探索了将深层模型倒转以合成培训分布图像的问题,但我们的目标是制定深层反倒方法,为特定查询图像生成反事实解释。尽管在有条件的图像合成中具有效力,但我们表明现有的深层反向解释方法不足以产生有意义的反事实。我们建议DISC(深刻地改变对反事实的合成)利用(a) 更强的图像前期,(b) 纳入新的多元一致性目标,以及(c) 逐步优化战略。我们发现,除了产生有视觉意义的解释外,从DISC的反事实性解释是有效的,从不为人所知的腐败测试的极限是有效的等级。