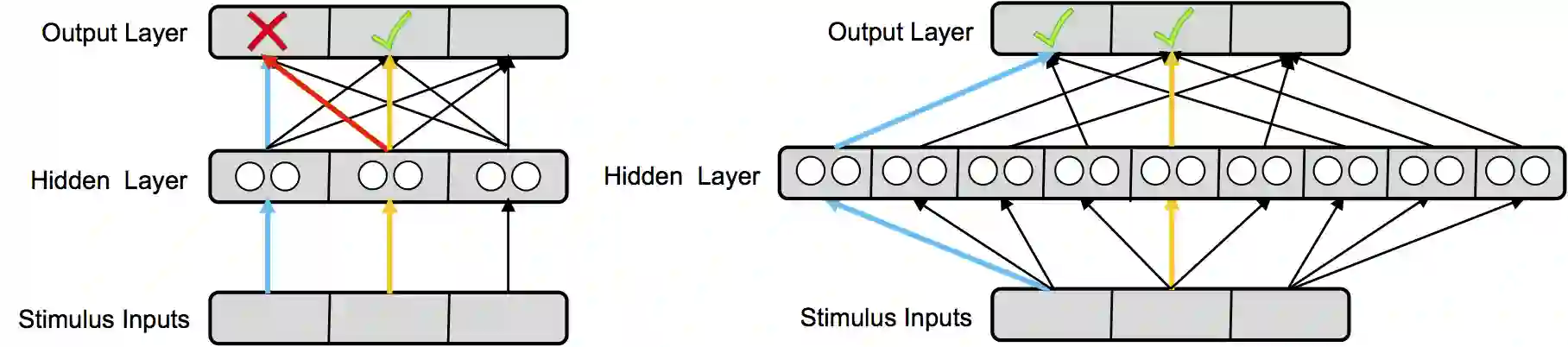

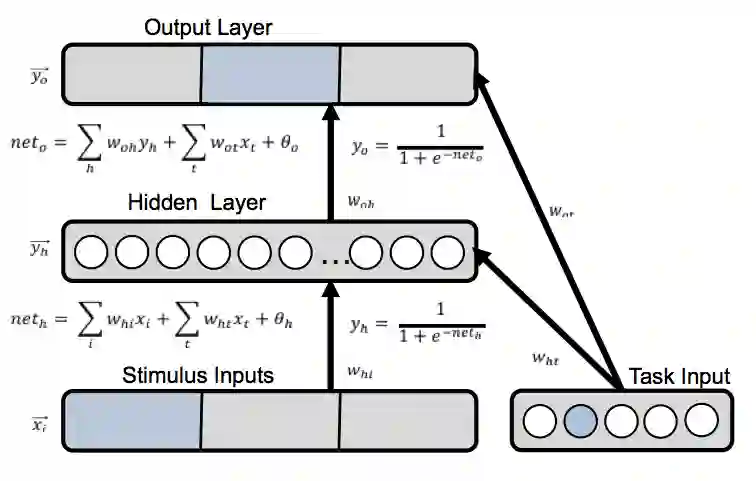

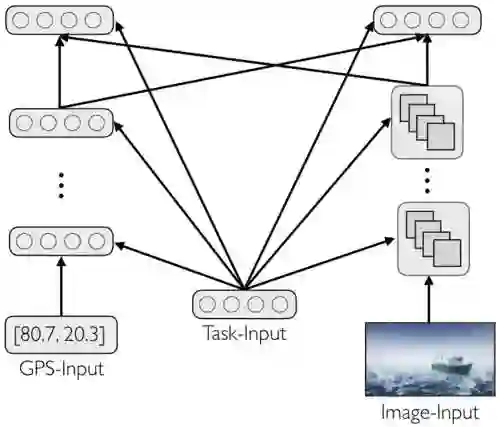

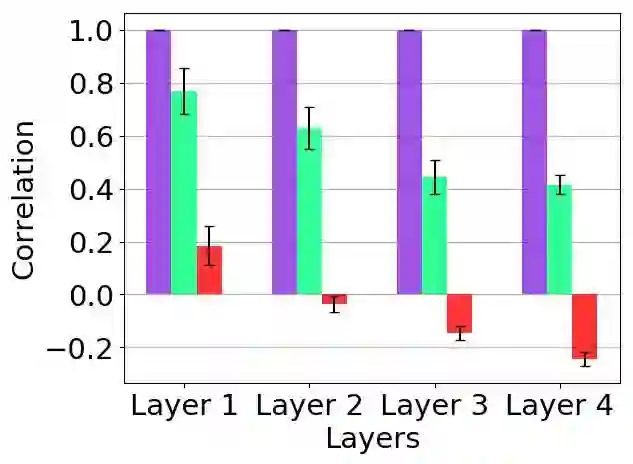

The terms multi-task learning and multitasking are easily confused. Multi-task learning refers to a paradigm in machine learning in which a network is trained on various related tasks to facilitate the acquisition of tasks. In contrast, multitasking is used to indicate, especially in the cognitive science literature, the ability to execute multiple tasks simultaneously. While multi-task learning exploits the discovery of common structure between tasks in the form of shared representations, multitasking is promoted by separating representations between tasks to avoid processing interference. Here, we build on previous work involving shallow networks and simple task settings suggesting that there is a trade-off between multi-task learning and multitasking, mediated by the use of shared versus separated representations. We show that the same tension arises in deep networks and discuss a meta-learning algorithm for an agent to manage this trade-off in an unfamiliar environment. We display through different experiments that the agent is able to successfully optimize its training strategy as a function of the environment.

翻译:多任务学习和多任务学习这两个术语很容易混淆。 多任务学习是指机器学习的范例,即对网络进行各种相关任务的培训,以便利获得任务。相反,多任务学习被用来表明同时执行多种任务的能力,特别是在认知科学文献中。多任务学习利用了以共同表述形式发现任务之间的共同结构,而多任务学习则通过在任务之间区分代表来推动,以避免处理干扰。在这里,我们以以往涉及浅线网络和简单任务设置的工作为基础,表明多任务学习和多任务任务学习之间存在平衡,通过使用共享和分离的表达方式加以调解。我们表明,在深层次的网络中出现同样的紧张关系,并讨论代理人在不熟悉的环境中管理这种交易的元学习算法。我们通过不同的实验显示,代理人能够成功地优化其培训战略,将其作为环境的一种功能。