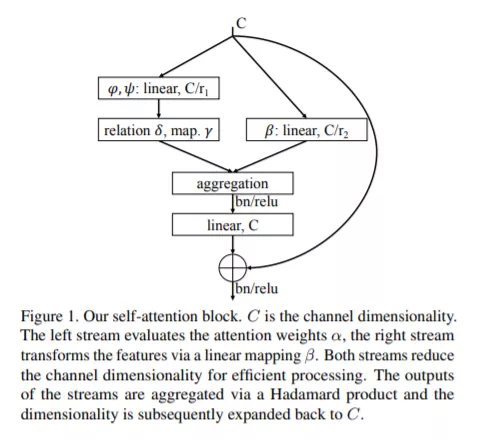

最近的研究表明,自注意力可以作为图像识别模型的基本构件。我们探讨了自注意力的变化,并评估了它们在图像识别中的有效性。我们认为自注意力有两种形式。一种是成对的自注意力,它概括了标准的点积注意,本质上是一个集合算子。另一种是拼凑式的自注意力,严格来说,它比卷积更强大。我们的成对自注意力网络匹配或优于卷积网络,补丁式网络的性能大大优于卷积基线。我们还进行了实验,探讨了学习表征的鲁棒性,并得出结论,自注意力网络在鲁棒性和泛化方面可能具有显著的优势。

成为VIP会员查看完整内容

相关内容

专知会员服务

16+阅读 · 2020年3月27日

Arxiv

5+阅读 · 2018年9月6日