题目: A simple baseline for bayesian uncertainty in deep learning

摘要:

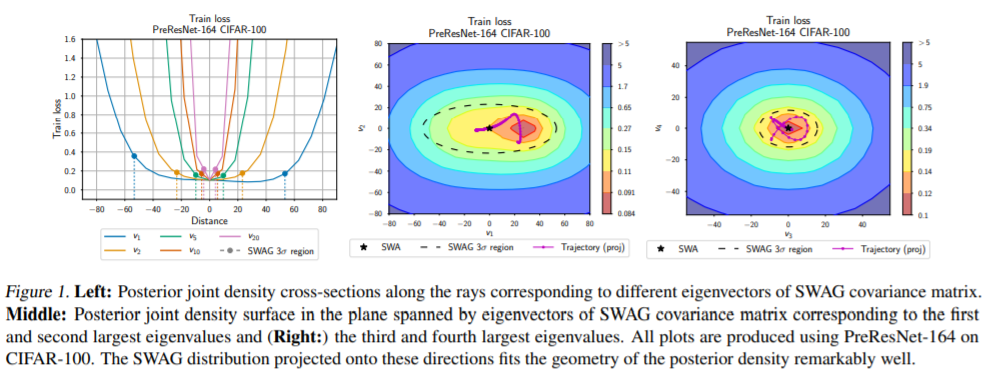

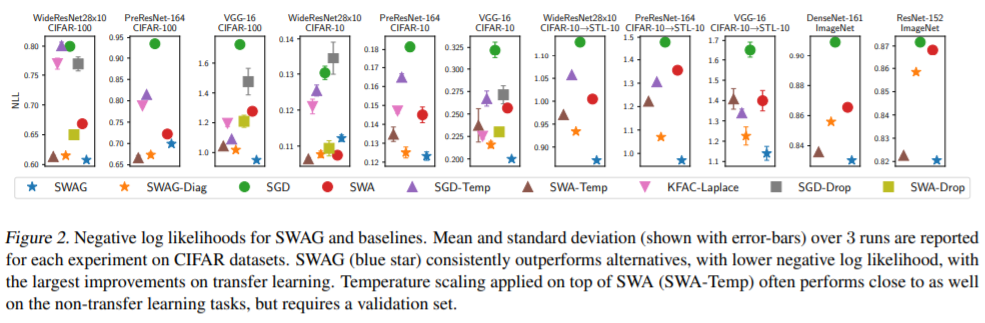

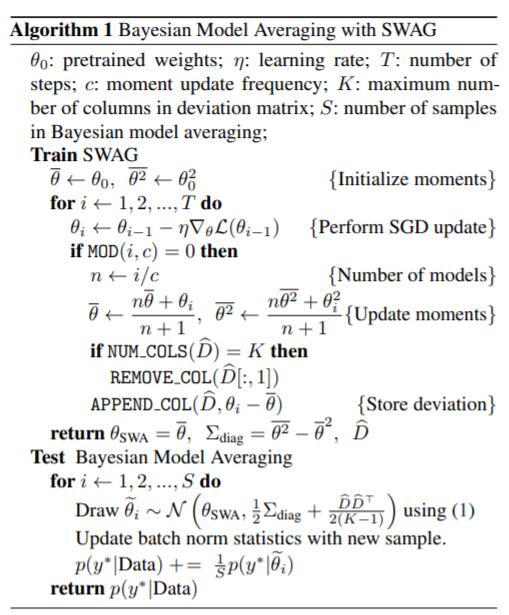

本文提出了一种简单、可扩展、通用的面向深度学习的不确定性表示和标定方法SWA-Gaussian (SWAG)。随机加权平均(SWA)是一种计算随机梯度下降(SGD)的第一次迭代的改进学习速率调度方法,最近被证明可以提高深度学习的泛化能力。在SWAG中,我们以SWA解作为第一个矩来拟合高斯分布,并从SGD迭代中得到一个低秩加对角协方差,形成了一个近似的后验分布;然后我们从这个高斯分布中取样,进行贝叶斯模型平均。根据SGD迭代的平稳分布结果,我们发现SWAG近似真实后验的形状。此外,我们证明了SWAG在各种计算机视觉任务上表现良好,包括样本外检测、校准和迁移学习,与许多流行的替代方案相比,包括MC dropout、KFAC拉普拉斯和温度标度。

作者:

Wesley Maddox是纽约大学数据科学专业的博士生,研究方向是统计机器学习、贝叶斯深度学习、高斯过程和生成模型。正在研究在机器学习模型(如神经网络)中加入和利用不确定性的方法。

Pavel Izmailov是纽约大学计算机科学的博士生,研究方向主要包括深度学习中的损失面分析、优化和正则化,对深度半监督学习、贝叶斯深度学习、生成模型、高斯过程等课题也很感兴趣。

成为VIP会员查看完整内容

相关内容

专知会员服务

54+阅读 · 2020年3月5日

专知会员服务

134+阅读 · 2020年3月2日

专知会员服务

28+阅读 · 2020年2月18日

专知会员服务

65+阅读 · 2019年12月14日

专知会员服务

29+阅读 · 2019年11月4日