论文标题: Improving Conversational Recommender Systems via Knowledge Graph based Semantic Fusion

论文来源: ACM SIGKDD 2020

论文链接:https://www.zhuanzhi.ai/paper/2d6c4333dfba038f1b318a37f5bc035d

会话推荐系统(conversation recommender system, CRS)旨在通过交互式的会话给用户推荐高质量的商品。通常CRS由寻求商品的user和推荐商品的system组成,通过交互式的会话,user实时表达自己的偏好,system理解user的意图并推荐商品。目前会话推荐系统有两个问题需要解决。首先,对话数据本身缺少足够的上下文信息,无法准确地理解用户的偏好(传统的推荐任务会有历史交互序列或者用户属性,但是该场景下只有对话的记录)。其次,自然语言的表示和商品级的用户偏好之间存在语义鸿沟(在user的话语“Can you recommend me a scary movie like Jaws”中,用户偏好反映在单词”scary“和电影实体”Jaws“上,但这两类信息天然存在语义的差异)。

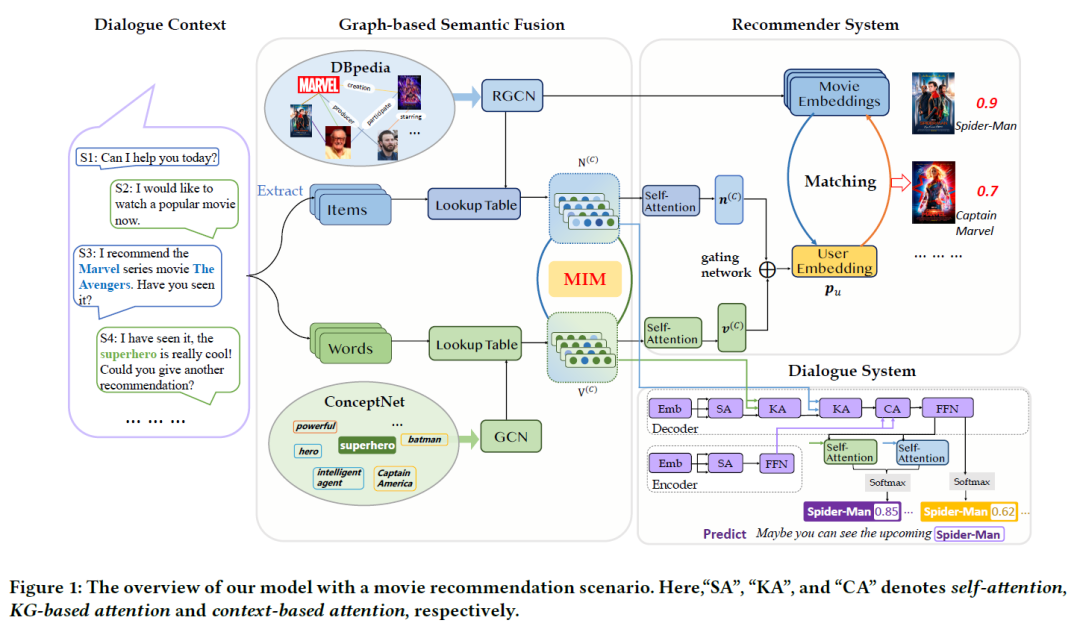

为了解决上述问题,本文提出了模型KG-based Semantic Fusion approach(KGSF),通过互信息最大化的多知识图谱语义融合技术,不仅打通了对话中不同类型信息的语义鸿沟,同时针对性得设计了下游的模型,以充分发挥两个知识图谱的作用,在会话推荐系统的两个任务上均取得了state-of-the-art的效果。

成为VIP会员查看完整内容

相关内容

知识图谱(Knowledge Graph),在图书情报界称为知识域可视化或知识领域映射地图,是显示知识发展进程与结构关系的一系列各种不同的图形,用可视化技术描述知识资源及其载体,挖掘、分析、构建、绘制和显示知识及它们之间的相互联系。

知识图谱是通过将应用数学、图形学、信息可视化技术、信息科学等学科的理论与方法与计量学引文分析、共现分析等方法结合,并利用可视化的图谱形象地展示学科的核心结构、发展历史、前沿领域以及整体知识架构达到多学科融合目的的现代理论。它能为学科研究提供切实的、有价值的参考。

Arxiv

11+阅读 · 2020年7月8日

Arxiv

4+阅读 · 2018年5月29日