题目

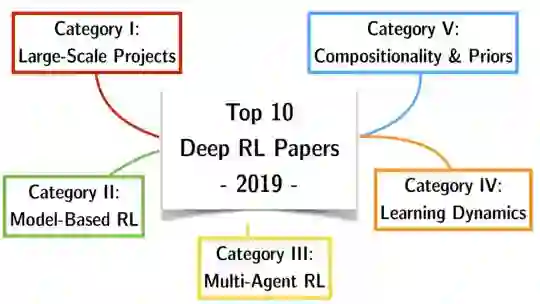

2019年必读的10篇TOP强化学习论文,My Top 10 Deep RL Papers of 2019

关键字

强化学习,深度学习,论文总结

简介

-

大型项目

- DeepMind’s AlphaStar (Vinyals et al, 2019)

- OpenAI’s Solving’ of the Rubik’s Cube (OpenAI, 2019)

-

基于模型的Rl

- MuZero (Schrittwieser et al., 2019)

- Dreamer (aka. PlaNet 2.0; Hafner et al., 2019)

-

多代理RL

- Social Influence as Intrinsic Motivation (Jaques et al., 2019)

- Autocurricula & Emergent Tool-Use (OpenAI, 2019)

-

学习动力

- Non-Staggered Meta-Learner’s Dynamics (Rabinowitz, 2019)

- Ray Interference (Schaul et al., 2019)

-

组成和先验

- Information Asymmetry in KL-Regularized RL (Galashov et al., 2019)

- NPMP: Neural Probabilistic Motor Primitives (Merel et al., 2019)

-

总结

- 总而言之,2019年凸显了Deep RL在以前无法想象的尺寸中的巨大潜力。突出显示的大型项目距离采样效率还差得远。但是,当前寻求有效归纳偏差,先验和基于模型的方法正在解决这些问题。

作者

Robert Tjarko Lange

成为VIP会员查看完整内容

相关内容

强化学习(RL)是机器学习的一个领域,与软件代理应如何在环境中采取行动以最大化累积奖励的概念有关。除了监督学习和非监督学习外,强化学习是三种基本的机器学习范式之一。

强化学习与监督学习的不同之处在于,不需要呈现带标签的输入/输出对,也不需要显式纠正次优动作。相反,重点是在探索(未知领域)和利用(当前知识)之间找到平衡。

该环境通常以马尔可夫决策过程(MDP)的形式陈述,因为针对这种情况的许多强化学习算法都使用动态编程技术。经典动态规划方法和强化学习算法之间的主要区别在于,后者不假设MDP的确切数学模型,并且针对无法采用精确方法的大型MDP。

专知会员服务

46+阅读 · 2019年12月25日

专知会员服务

48+阅读 · 2019年12月24日