论文题目

视频游戏中深度强化学习的研究综述,A Survey of Deep Reinforcement Learning in Video

论文摘要

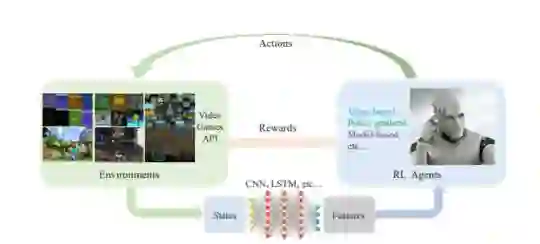

摘要深度强化学习(DRL)自提出以来取得了很大的成就。通常,DRL代理在每个步骤都接收高维输入,并根据基于深度神经网络的策略进行操作。这种学习机制通过端到端的方法更新策略以最大化回报。本文综述了DRL方法的研究进展,包括基于价值的方法、基于策略梯度的方法和基于模型的方法,比较了它们的主要技术和性能,并指出DRL在智能游戏中的重要作用。我们还回顾了DRL在各种电子游戏中的成就,包括经典的街机游戏、第一人称视角游戏和多智能体实时战略游戏,从2D到3D,从单智能体到多智能体,大量带有DRL的电子游戏AIs都取得了超人的性能,在这个领域还有一些挑战。因此,我们还讨论了将DRL方法应用于该领域的一些关键点,包括探索性开发、样本效率、泛化和迁移、多智能体学习、不完全信息和延迟备用研究,以及一些研究方向。

论文作者

Kun Shao, Zhentao Tang, Yuanheng Zhu,IEEE成员。Nannan Li, Dongbin Zhao,IEEE资深会员。

成为VIP会员查看完整内容

相关内容

赵冬斌,中国科学院自动化所,IEEE资深会员。

http://sourcedb.ia.cas.cn/cn/iaexpert/200908/t20090804_2310521.html

专知会员服务

56+阅读 · 2019年11月28日