论文题目: Neural Reading Comprehension And Beyond

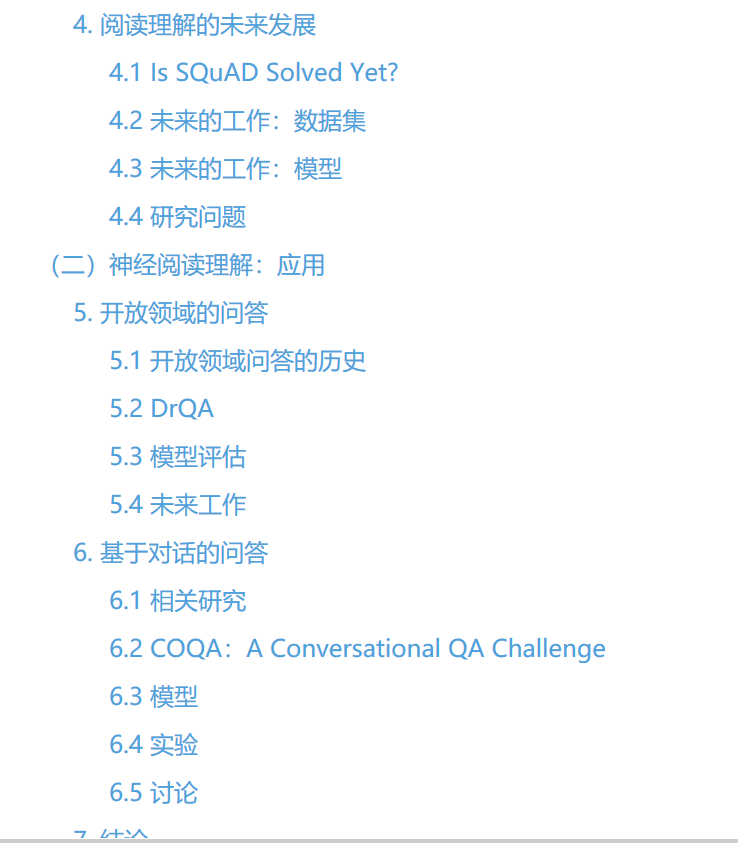

论文摘要: 教机器理解人类语言文件是人工智能中最难以捉摸和长期存在的挑战之一。本文研究的是阅读理解问题:如何建立计算机系统来阅读一篇文章并回答理解问题。一方面,我们认为阅读理解是评估计算机系统对人类语言理解程度的重要任务。另一方面,如果我们能建立一个高性能的阅读理解系统,它们将是问答和对话等应用的关键技术系统。在这篇论文中,我们关注的是神经阅读理解:一类建立在深层神经网络之上的阅读理解模型。与传统的稀疏的、手工设计的基于特征的模型相比,这些端到端的神经模型在学习丰富的语言现象和提高现代阅读理解基准上的性能方面有了很大的提高。在第一部分中,我们将讨论神经的本质阅读理解和目前我们努力建立有效的神经阅读理解模型,更重要的是,了解神经阅读理解模型实际上学到了什么,需要解决语言理解的深度是什么当前任务。我们还总结了这一领域的最新进展,并讨论了未来的发展方向和有待解决的问题。在本论文的第二部分,我们将探讨如何在最近神经阅读理解的成功基础上建立实际的应用。特别是我们开创了两个新的研究方向:1)如何将信息检索技术与神经阅读理解相结合,解决大规模的开放领域问题回答;2)如何从现有的单轮、基于广域的阅读理解模型构建会话式问题回答系统。我们在DRQA和coqa项目中实现了这些想法,并证明了这些方法的有效性。我们相信他们对未来的语言技术有很大的希望。

下载链接: https://stacks.stanford.edu/file/druid:gd576xb1833/thesis-augmented.pdf

成为VIP会员查看完整内容

相关内容

专知会员服务

32+阅读 · 2020年3月1日

专知会员服务

41+阅读 · 2019年11月24日

专知会员服务

47+阅读 · 2019年11月24日

专知会员服务

34+阅读 · 2019年10月18日

Arxiv

4+阅读 · 2017年11月15日