题目: Graph Pooling with Node Proximity for Hierarchical Representation Learning

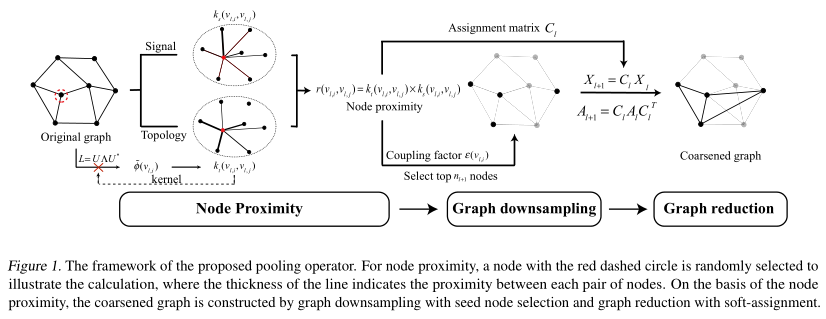

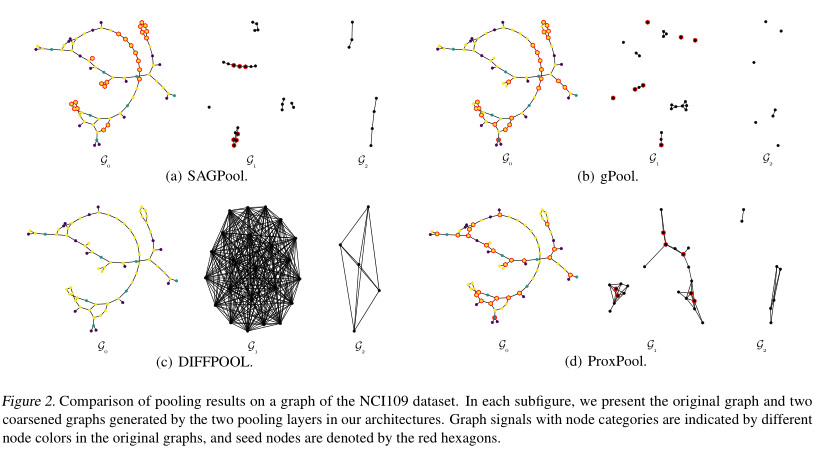

摘要: 在最近的研究中,图神经网络在图数据表示学习方面受到了广泛的关注。作为对图卷积算子的补充,图池化是提取图数据层次表示的关键。然而,最近的图池化方法仍然不能有效地利用图数据的几何特性。在本文中,我们提出了一种新的图组合策略,利用节点的邻近性来提高图数据的多跳拓扑结构的层次表示学习。节点接近度是通过协调拓扑信息的核表示和节点特征得到的。拓扑信息的隐式结构感知核表示允许高效的图池化,而不需要显式的图的特征组合。利用高斯径向基函数结合仿射变换和核技巧自适应地评估节点信号的相似性。实验结果表明,所提出的图池化策略能够在公开图分类基准数据集上取得最先进的性能。

成为VIP会员查看完整内容