题目: AutoML: A Survey of the State-of-the-Art

摘要:

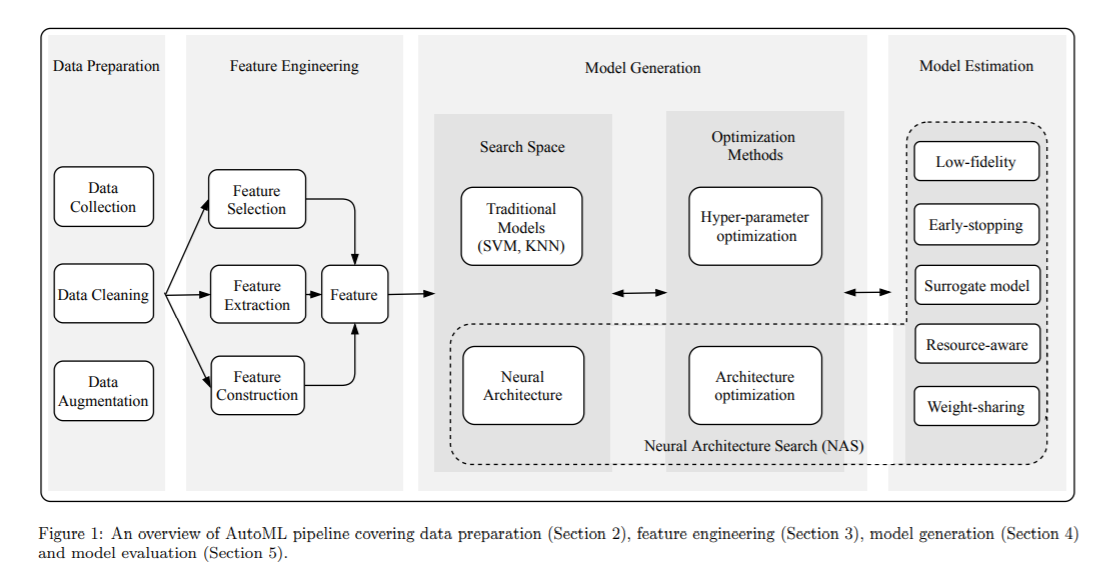

深度学习(DL)技术已渗透到我们生活的方方面面,并为我们带来了极大的便利。但是,针对特定任务构建高质量的DL系统高度依赖于人类的专业知识,这阻碍了DL在更多领域的应用。自动机器学习(AutoML)成为在无需人工协助的情况下构建DL系统的有前途的解决方案,并且越来越多的研究人员专注于AutoML。在本文中,对AutoML中的最新技术(SOTA)进行了全面而最新的回顾。首先,根据管道介绍AutoML方法,涵盖数据准备,特征工程,超参数优化和神经体系结构搜索(NAS)。我们更加关注NAS,因为它是AutoML的非常热门的子主题。然后总结了具有代表性的NAS算法在CIFAR-10和ImageNet数据集上的性能,并进一步讨论了NAS方法的一些值得研究的方向:一阶段/两阶段NAS,单次NAS以及联合超参数和体系结构优化。最后,讨论了现有AutoML方法的一些未解决的问题,以供将来研究。

成为VIP会员查看完整内容

相关内容

专知会员服务

33+阅读 · 2019年12月12日

Arxiv

3+阅读 · 2019年9月3日

Arxiv

7+阅读 · 2018年10月31日

Arxiv

4+阅读 · 2017年8月17日