主题: Learning Colour Representations of Search Queries

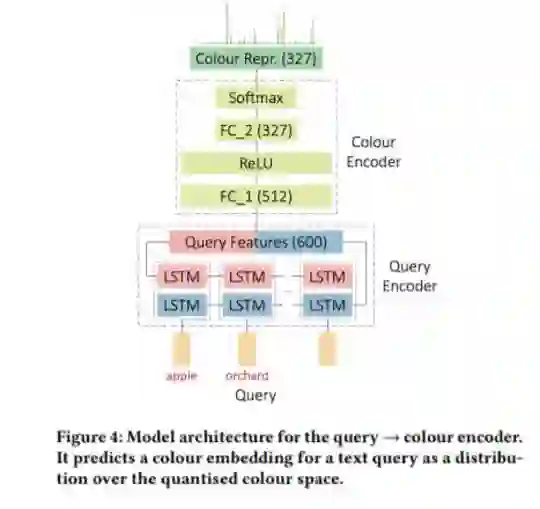

摘要: 图像搜索引擎依赖于适当设计的排名功能,这些功能可以捕获内容语义的各个方面以及历史上的流行。在这项工作中,我们考虑了色彩在相关性匹配过程中的作用。观察到很大一部分用户查询具有与之相关的固有颜色,这促使我们开展工作。虽然某些查询包含明确的颜色提及(例如“黑色汽车”和“黄色雏菊”),但其他查询却包含隐式的颜色概念(例如“天空”和“草”)。此外,颜色的基础查询不是到单一颜色的映射,而是颜色空间中的分布。例如,对“树”的搜索往往会在绿色和棕色之间形成双峰分布。我们利用历史点击数据为搜索查询生成颜色表示,并提出一种递归神经网络架构,将看不见的查询编码到颜色空间中。我们还展示了如何从印象日志中的交叉模式相关性排序器中学习该嵌入,在印象日志中单击了结果图像的子集。我们证明了查询图像颜色距离功能的使用可改善排名性能,该性能通过用户对点击图像和跳过图像的偏好来衡量。

成为VIP会员查看完整内容