题目: Background Knowledge Injection forInterpretable Sequence Classification

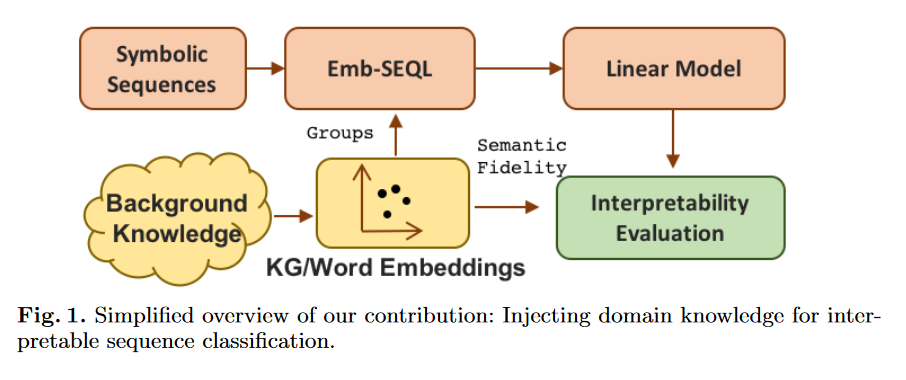

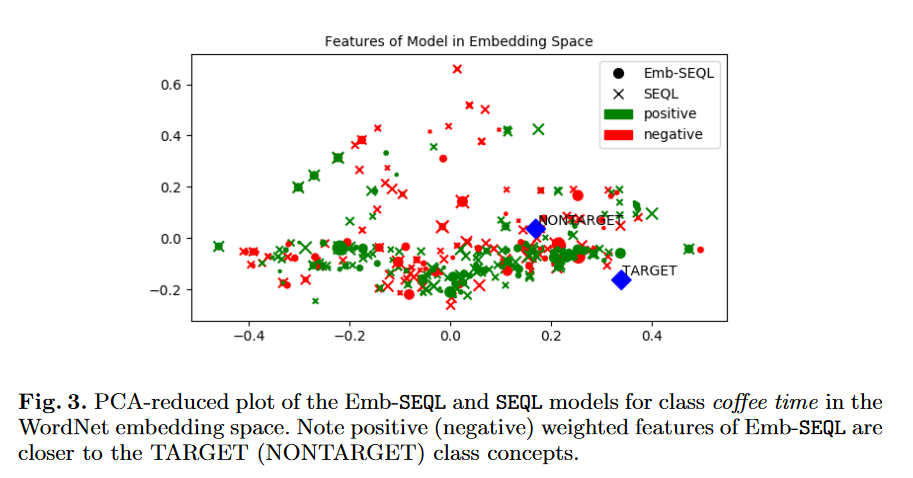

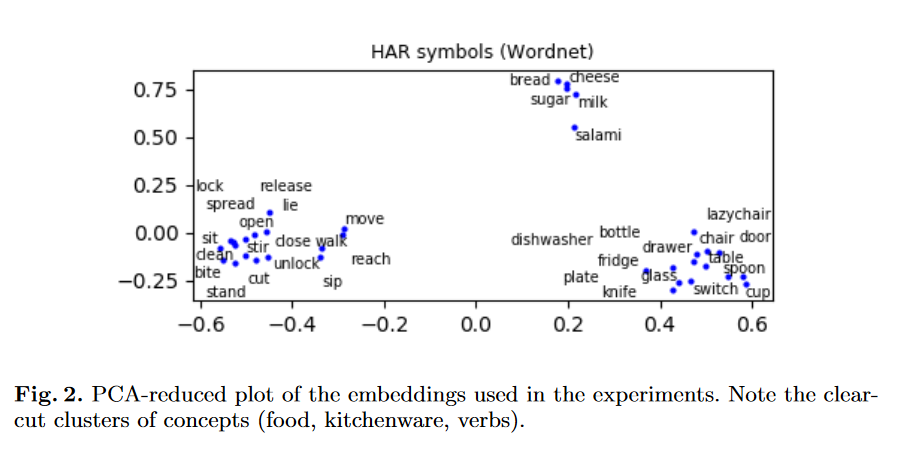

摘要: 序列分类是一项有监督的学习任务,它建立模型来预测未知符号序列的类标签。尽管准确性是最重要的,但在某些情况下,可解释性是必须的。不幸的是,我们回溯了人类独立的可解释性度量,这样的权衡通常很难实现。我们介绍了一种新的序列学习算法,它结合了(i)线性分类器,已知线性分类器在预测能力和可解释性之间取得了很好的平衡,以及(ii)背景知识嵌入。我们将经典的子序列特征空间扩展为由嵌入字或图的背景知识生成的符号组,并利用这个新的特征空间学习线性分类器。提出了一种新的基于符号嵌入的符号特征集可解释性评价方法。从可穿戴设备和氨基酸序列分类中识别人类活动的实验表明,我们的分类方法保留了预测能力,同时提供了更多的可解释模型。

作者简介: Severin Gsponer,都柏林大学学院数据分析洞察中心博士生。

Luca Costabello,都柏林大学学院埃森哲实验室,研究科学家。等

成为VIP会员查看完整内容

相关内容

专知会员服务

17+阅读 · 2020年3月23日

专知会员服务

26+阅读 · 2019年12月5日

专知会员服务

85+阅读 · 2019年11月24日

Arxiv

4+阅读 · 2018年5月24日