【泡泡一分钟】时空定位与建图(ICCV2017-411)

每天一分钟,带你读遍机器人顶级会议文章

标题:Space-Time Localization and Mapping

作者:Minhaeng Lee, Charless C. Fowlkes

来源:ICCV 2017 ( IEEE International Conference on Computer Vision)

编译:金顾敏

审核:颜青松 陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

本文解决了从带时间戳的数据流中构建世界时空模型的问题。不同于传统的专注于恢复单个刚体3维模型的同时定位与建图方法和运动恢复结构方法,本文解决了动态元素随时间彼此独立出现,移动和消失的场景建图问题。本文引入了一个简单的4维结构生成概率模型,该模型通过局部高斯混合来指定刚性表面块的位置,空间和时间范围。本文使用EM算法将此模型拟合到带时间戳的输入数据流,以估计模型结构参数(建图)以及输入数据与模型的对齐(定位)。通过明确地表示场景中的表面的时间范围和可观性,相对于假设静态3D场景的基线,我们的方法产生了优越的定位和重建。最后对合成的RGB-D数据流,以及具有挑战性的真实世界的数据集进行实验,在有人工作空间跟踪动态场景几个星期。

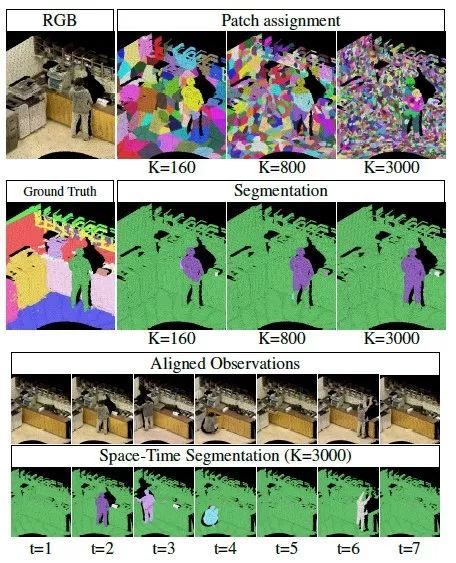

图1.在Copier room数据集上的分割结果显示具有相似的时间范围表面块的分组。分割精度取决于表面块的数量(上图)。使用最佳簇大小对所有时空观测进行分割,发现静态和动态场景组件(下图)。

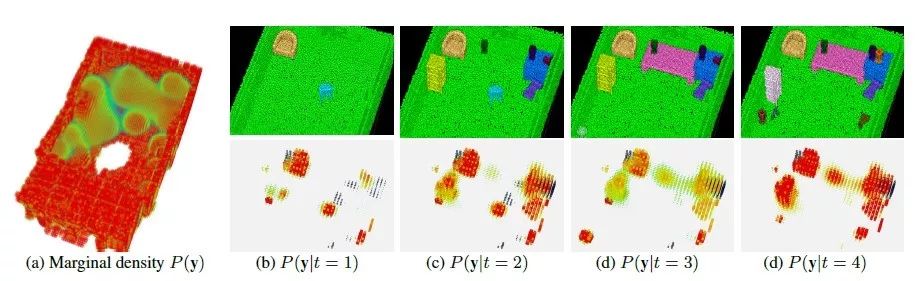

图2。拟合模型预测的三维概率密度的可视化,(a)随时间的边缘密度,(b) - (e)为清晰起见排除静态分量的不同的观察时间为条件下的概率密度。

Abstract

This paper addresses the problem of building a spatiotemporal model of the world from a stream of time-stamped data. Unlike traditional models for simultaneous localization and mapping (SLAM) and structure-from-motion (SfM) which focus on recovering a single rigid 3D model, we tackle the problem of mapping scenes in which dynamic components appear, move and disappear independently of each other over time. We introduce a simple generative probabilistic model of 4D structure which specifies location, spatial and temporal extent of rigid surface patches by local Gaussian mixtures. We fit this model to a time-stamped stream of input data using expectation-maximization to estimate the model structure parameters (mapping) and the alignment of the input data to the model (localization). By explicitly representing the temporal extent and observability of surfaces in a scene, our method yields superior localization and reconstruction relative to baselines that assume a static 3D scene. We carry out experiments on both synthetic RGB-D data streams as well as challenging real-world datasets, tracking scene dynamics in a human workspace over the course of several weeks.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com