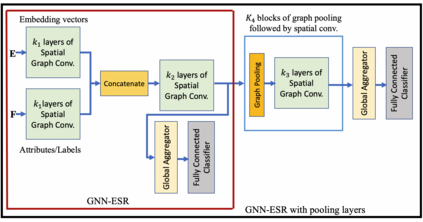

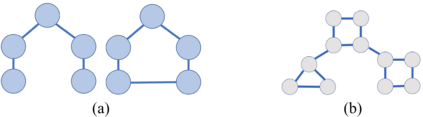

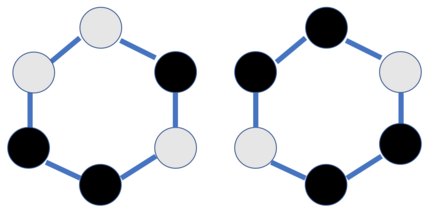

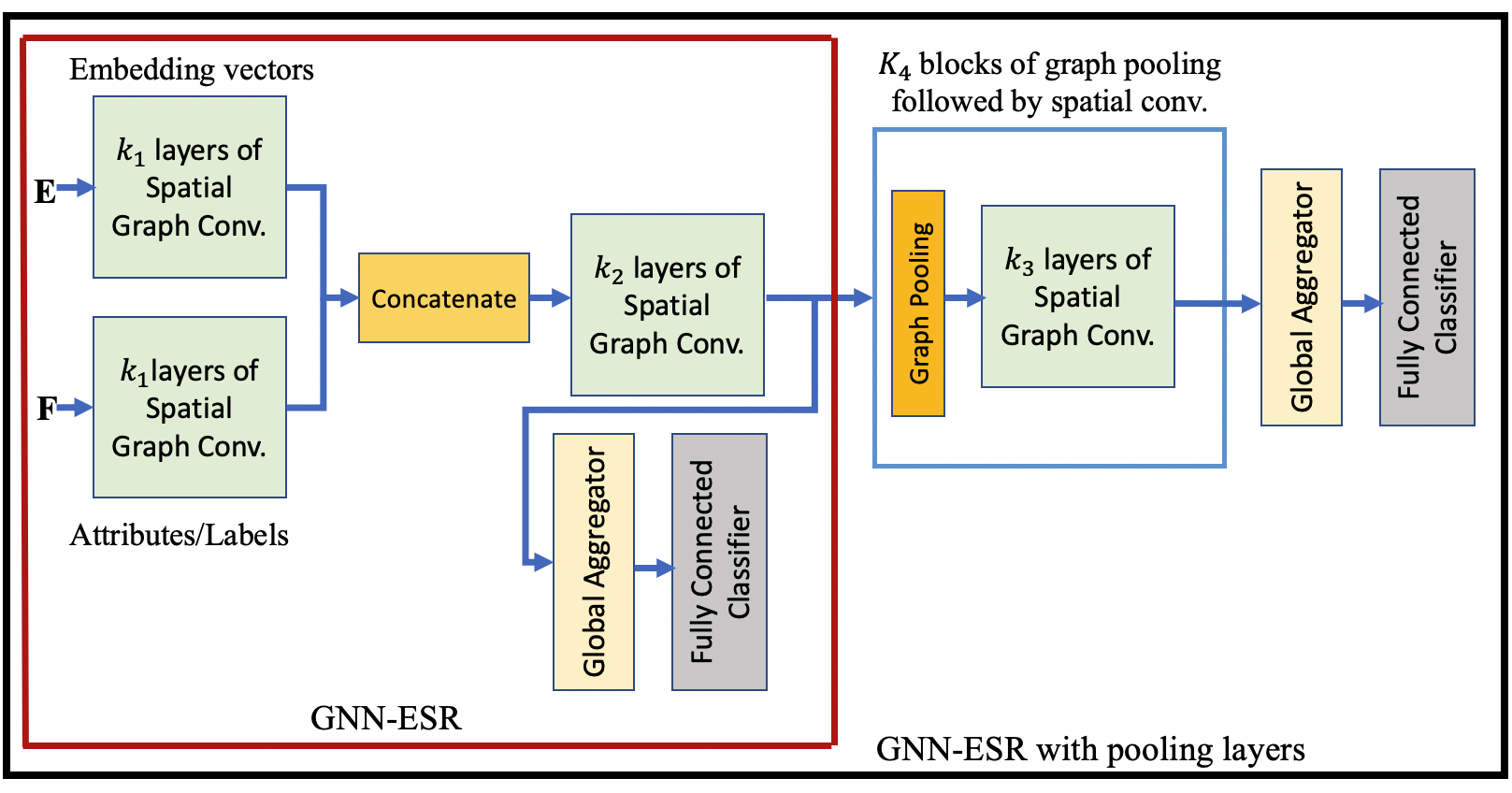

The spatial convolution layer which is widely used in the Graph Neural Networks (GNNs) aggregates the feature vector of each node with the feature vectors of its neighboring nodes. The GNN is not aware of the locations of the nodes in the global structure of the graph and when the local structures corresponding to different nodes are similar to each other, the convolution layer maps all those nodes to similar or same feature vectors in the continuous feature space. Therefore, the GNN cannot distinguish two graphs if their difference is not in their local structures. In addition, when the nodes are not labeled/attributed the convolution layers can fail to distinguish even different local structures. In this paper, we propose an effective solution to address this problem of the GNNs. The proposed approach leverages a spatial representation of the graph which makes the neural network aware of the differences between the nodes and also their locations in the graph. The spatial representation which is equivalent to a point-cloud representation of the graph is obtained by a graph embedding method. Using the proposed approach, the local feature extractor of the GNN distinguishes similar local structures in different locations of the graph and the GNN infers the topological structure of the graph from the spatial distribution of the locally extracted feature vectors. Moreover, the spatial representation is utilized to simplify the graph down-sampling problem. A new graph pooling method is proposed and it is shown that the proposed pooling method achieves competitive or better results in comparison with the state-of-the-art methods.

翻译:在图形神经网络(GNN)中广泛使用的空间共变层将每个节点的特性矢量与相邻节点的特性矢量聚合在一起。 GNN并不了解图形全球结构中节点的位置,当与不同节点相对应的当地结构彼此相似时, 相交层将所有这些节点与连续特征矢量的相似或相同特性矢量绘制成图。 因此, GNN无法区分两个图, 如果其差异不在于其当地结构。 此外, 当节点没有标出/提供相交层的特性矢量无法区分甚至不同的地方结构时, GNNN不知道这些节点在全球图结构中的位置, 并且当与不同的节点相对应的地方结构时, GNN没有意识到这些节点的位置; 拟议的方法使神经网络意识到节点及其在连续特征矢量空间矢量中的位置之间的差异。 通过图表嵌入式方法获得了相当于该图的点- 。 使用拟议方法, GNNNF 的本地特性提取器将G 图像中显示的地面分布方法与不同的地方结构加以区分。