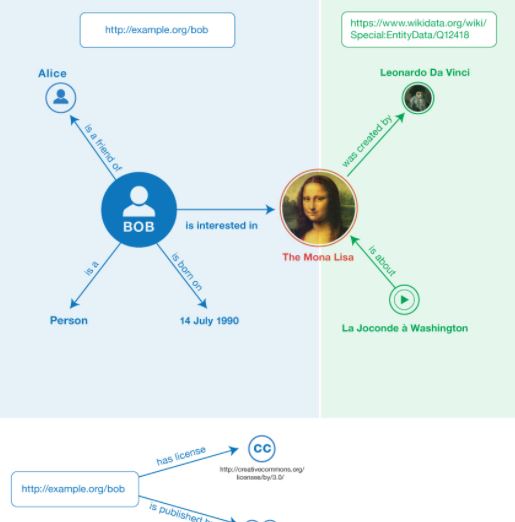

Knowledge from diverse application domains is organized as knowledge graphs (KGs) that are stored in RDF engines accessible in the web via SPARQL endpoints. Expressing a well-formed SPARQL query requires information about the graph structure and the exact URIs of its components, which is impractical for the average user. Question answering (QA) systems assist by translating natural language questions to SPARQL. Existing QA systems are typically based on application-specific human-curated rules, or require prior information, expensive pre-processing and model adaptation for each targeted KG. Therefore, they are hard to generalize to a broad set of applications and KGs. In this paper, we propose KGQAn, a universal QA system that does not need to be tailored to each target KG. Instead of curated rules, KGQAn introduces a novel formalization of question understanding as a text generation problem to convert a question into an intermediate abstract representation via a neural sequence-to-sequence model. We also develop a just-in-time linker that maps at query time the abstract representation to a SPARQL query for a specific KG, using only the publicly accessible APIs and the existing indices of the RDF store, without requiring any pre-processing. Our experiments with several real KGs demonstrate that KGQAn is easily deployed and outperforms by a large margin the state-of-the-art in terms of quality of answers and processing time, especially for arbitrary KGs, unseen during the training.

翻译:通过 SPARQL 端点在网上存储于 RDF 引擎的知识图(KGs), 将来自不同应用领域的知识编成知识图(KGs), 通过 SPARQL 端点存储在网络上。 表达完善的 SPARQL 查询要求提供关于其组件的图形结构和精确的 URI 的信息,这对于普通用户来说是不切实际的。 问答(QA) 系统通过向 SPARQL 翻译自然语言问题来协助。 现有的 QA 系统通常基于特定应用程序的人端规则,或者需要事先信息、 昂贵的预处理和模型调整。 因此,它们很难被概括为一套广泛的高质量应用程序和 KGG。 在本文件中,我们建议 KGQQA, 一个通用的QA系统, 不需要针对每个目标 KG。 KGQQA 的通用的系统, 而不是经过校正的规则, 引入了一种新型的问题理解, 作为一种文本生成问题, 将问题转换成一个中间的抽象代表, 通过神经顺序到序列解答。 因此, 我们的KPARLQ 只能用一个可获取的实时的远程解算 。</s>