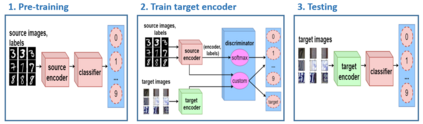

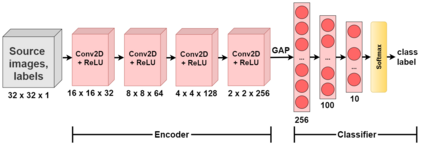

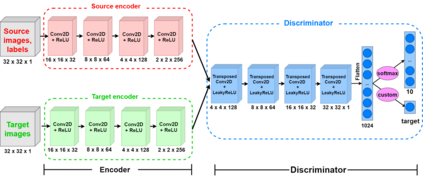

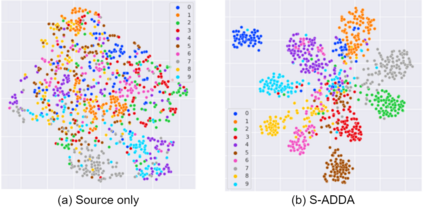

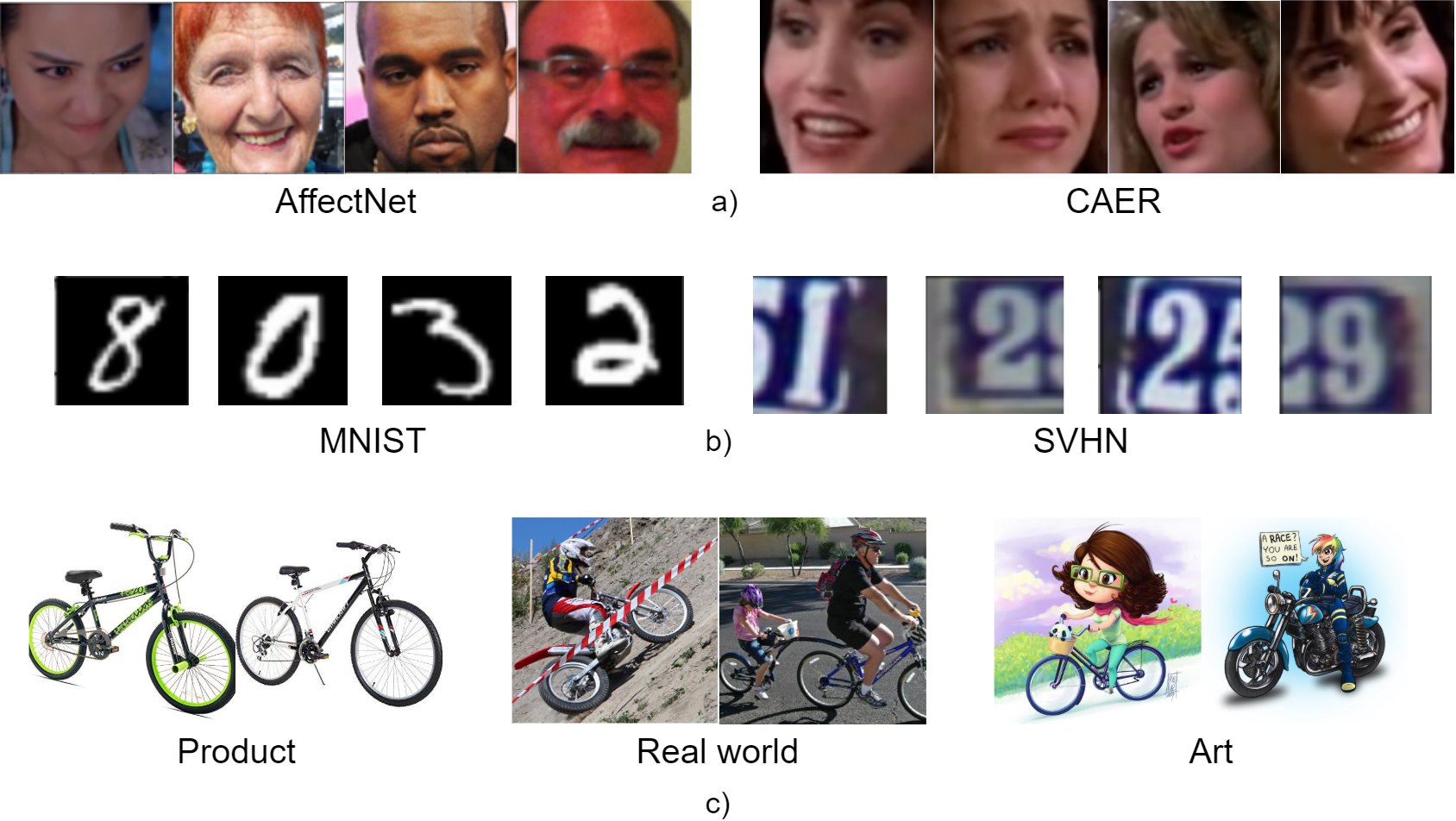

Domain adaptation is a potential method to train a powerful deep neural network, which can handle the absence of labeled data. More precisely, domain adaptation solving the limitation called dataset bias or domain shift when the training dataset and testing dataset are extremely different. Adversarial adaptation method becoming popular among other domain adaptation methods. Relies on the idea of GAN, adversarial domain adaptation tries to minimize the distribution between training and testing datasets base on the adversarial object. However, some conventional adversarial domain adaptation methods cannot handle large domain shifts between two datasets or the generalization ability of these methods are inefficient. In this paper, we propose an improved adversarial domain adaptation method called Semi-Supervised Adversarial Discriminative Domain Adaptation (SADDA), which can overcome the limitation of other domain adaptation. We also show that SADDA has better performance than other adversarial adaptation methods and illustrate the promise of our method on digit classification and emotion recognition problems.

翻译:域适应是培训强大的深神经网络的潜在方法,可以处理没有标签数据的问题。更准确地说,当培训数据集和测试数据集极为不同时,域适应解决所谓的数据集偏差或域变的限制。反向适应方法在其它领域适应方法中越来越受欢迎。关于GAN的设想,对抗性域适应试图最大限度地减少对对立对象的培训和测试数据集基础之间的分布。然而,一些传统的对抗性域适应方法无法处理两个数据集之间的大域变或这些方法的概括化能力效率低下。在本文件中,我们建议采用一种改进的对抗性域适应方法,即半超超超Adversarial Discriminative Domain适应(SADADA),这可以克服其他领域适应的局限性。我们还表明,SADA比其他对抗性适应方法的性能更好,并说明了我们在数字分类和情感识别问题方面的方法的前景。