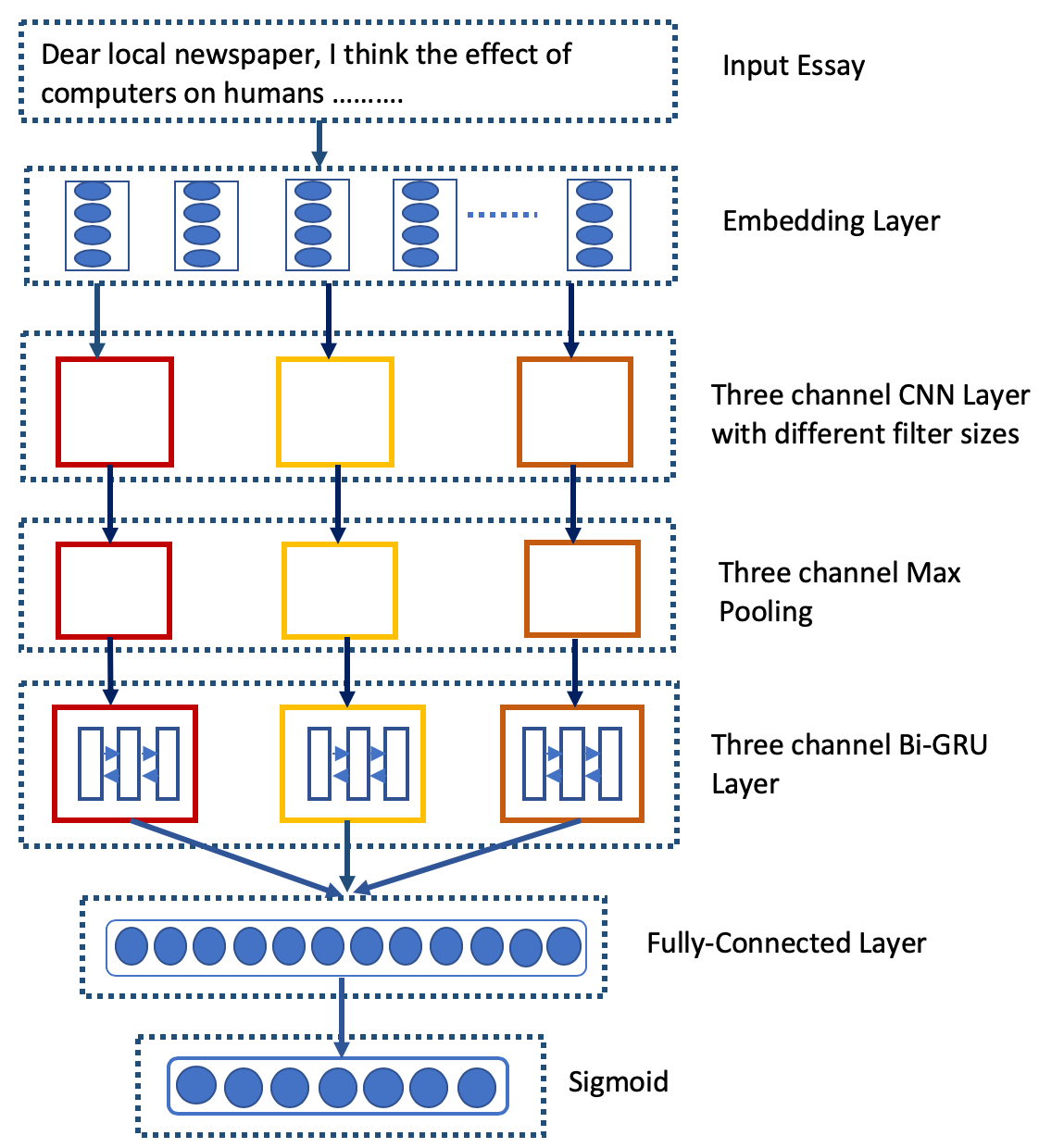

Automatic evaluation of essay (AES) and also called automatic essay scoring has become a severe problem due to the rise of online learning and evaluation platforms such as Coursera, Udemy, Khan academy, and so on. Researchers have recently proposed many techniques for automatic evaluation. However, many of these techniques use hand-crafted features and thus are limited from the feature representation point of view. Deep learning has emerged as a new paradigm in machine learning which can exploit the vast data and identify the features useful for essay evaluation. To this end, we propose a novel architecture based on recurrent networks (RNN) and convolution neural network (CNN). In the proposed architecture, the multichannel convolutional layer learns and captures the contextual features of the word n-gram from the word embedding vectors and the essential semantic concepts to form the feature vector at essay level using max-pooling operation. A variant of RNN called Bi-gated recurrent unit (BGRU) is used to access both previous and subsequent contextual representations. The experiment was carried out on eight data sets available on Kaggle for the task of AES. The experimental results show that our proposed system achieves significantly higher grading accuracy than other deep learning-based AES systems and also other state-of-the-art AES systems.

翻译:由于Lunera、Udemy、Khan学院等在线学习和评价平台的兴起,对论文(AES)和所谓的自动作文评分的自动评价已成为一个严重问题。研究人员最近提出了许多自动评价技术。然而,许多这些技术使用手工制作的特征,因此从特征代表观点来看是有限的。深层次的学习已成为机器学习的新范例,可以利用庞大的数据,并查明作文评价的有用特征。为此,我们提议以经常性网络(RNN)和神经网络(CNN)等在线学习和评价平台为基础,建立一个新的结构。在拟议的结构中,多通道连带层学习并捕捉到从嵌入矢量的词中的n-gram字和基本语义概念的背景特征,以便利用最大组合操作在作文层次上形成特性矢量。RNNN的变式称为双层经常单元(BGRU),用于获取以前和以后的背景表现。在Kaglegle上提供的八套数据,用于AES基础任务。实验的结果是:AES系统的实验性结果显示,我们提议的系统在其他深层系统的精确度也大大高于其他系统。