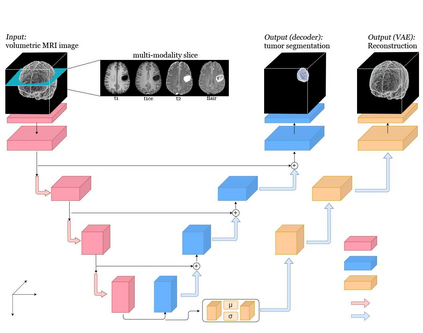

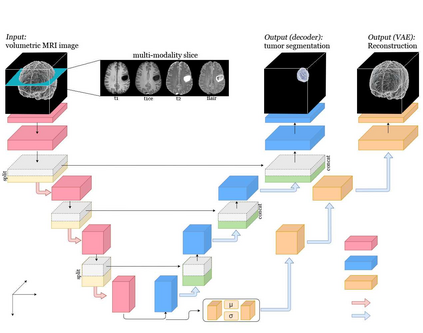

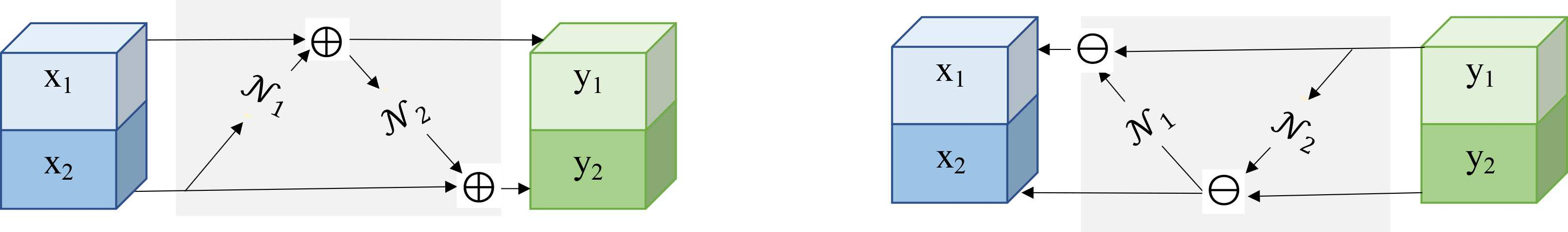

Deep Convolutional Neural Networks (CNNs) i.e. Residual Networks (ResNets) have been used successfully for many computer vision tasks, but are difficult to scale to 3D volumetric medical data. Memory is increasingly often the bottleneck when training 3D Convolutional Neural Networks (CNNs). Recently, invertible neural networks have been applied to significantly reduce activation memory footprint when training neural networks with backpropagation thanks to the invertible functions that allow retrieving its input from its output without storing intermediate activations in memory to perform the backpropagation. Among many successful network architectures, 3D Unet has been established as a standard architecture for volumetric medical segmentation. Thus, we choose 3D Unet as a baseline for a non-invertible network and we then extend it with the invertible residual network. In this paper, we proposed two versions of the invertible Residual Network, namely Partially Invertible Residual Network (Partially-InvRes) and Fully Invertible Residual Network (Fully-InvRes). In Partially-InvRes, the invertible residual layer is defined by a technique called additive coupling whereas in Fully-InvRes, both invertible upsampling and downsampling operations are learned based on squeezing (known as pixel shuffle). Furthermore, to avoid the overfitting problem because of less training data, a variational auto-encoder (VAE) branch is added to reconstruct the input volumetric data itself. Our results indicate that by using partially/fully invertible networks as the central workhorse in volumetric segmentation, we not only reduce memory overhead but also achieve compatible segmentation performance compared against the non-invertible 3D Unet. We have demonstrated the proposed networks on various volumetric datasets such as iSeg 2019 and BraTS 2020.

翻译:深革命神经网络 (CNNs) 。 残余网络(ResNets) 已被成功用于许多计算机视觉任务, 但很难推广到 3D 体积医疗数据。 培训 3D 进化神经网络( CNNs) 时, 内存往往日益成为瓶颈。 最近, 运用了不可逆的神经网络, 以大量减少内存的内存足迹。 在培训神经网络时, 利用反向反向反向反向反向反应功能, 使得其输出的内存不存储中间启动来进行反向调整。 在许多成功的网络结构中, 3D 直径网络被建立为体积医学分割的标准结构。 因此, 我们选择 3D Unet作为非不可逆的网络的基线, 然后我们将其扩展为不可逆的残余网络 。 在本文中, 我们提出了两种不可逆的残余网络的版本, 即部分不可逆的内存留置网络( 部分内存的内存) 和完全内存的内存的内存网络( ), 内存的内存的内存的内存的内存的内存的内存的内存数据流( ) ) 的内存的内存的内的内变变的内存的内存数据流的内变的内变的内变的内变的内变的内变的内变的内的内的内的内变的内的内的内的内的内的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变的变