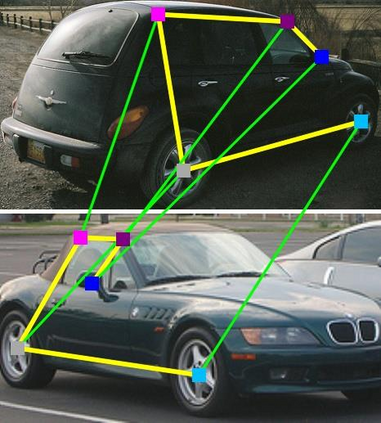

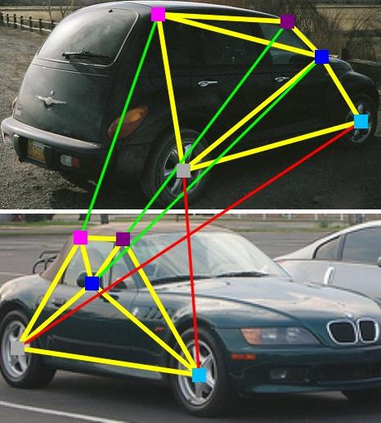

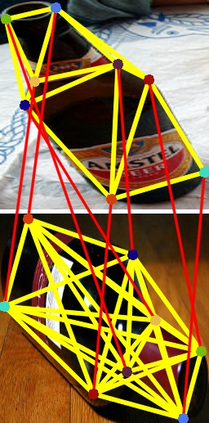

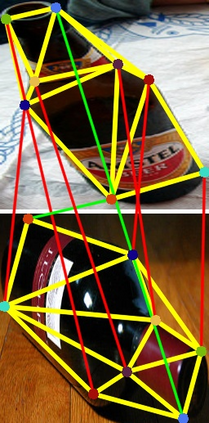

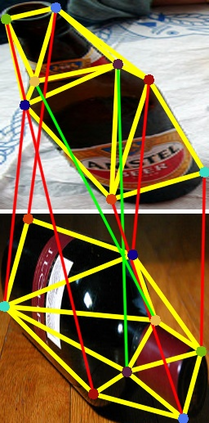

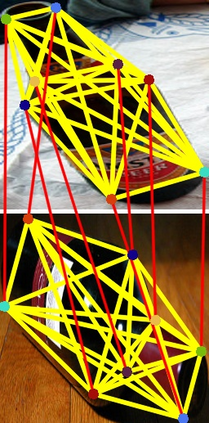

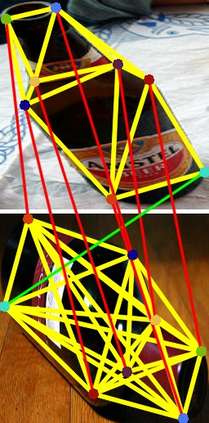

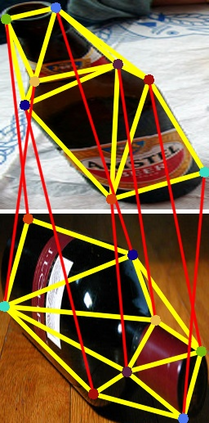

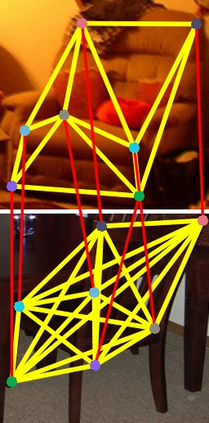

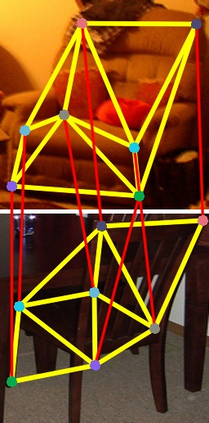

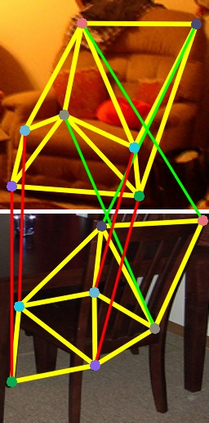

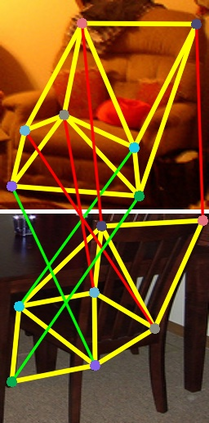

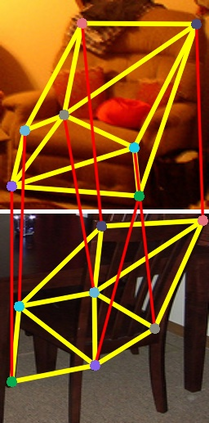

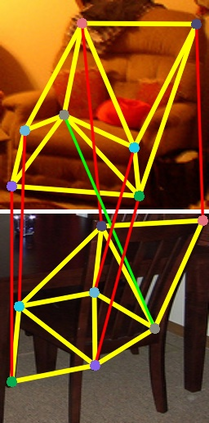

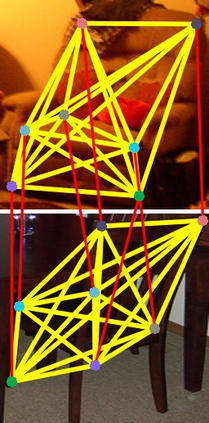

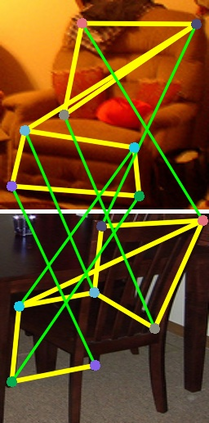

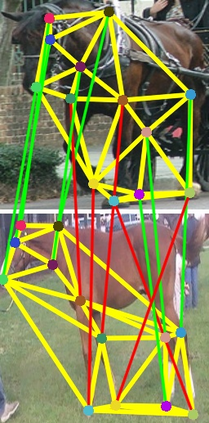

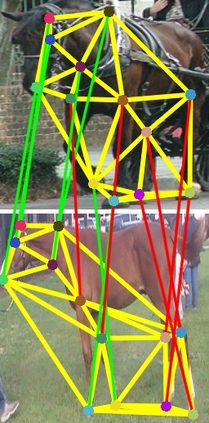

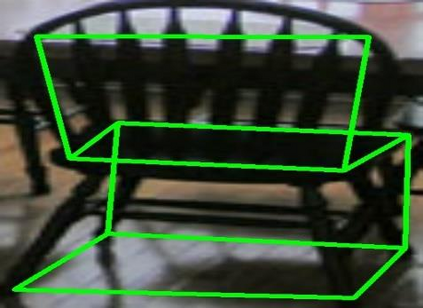

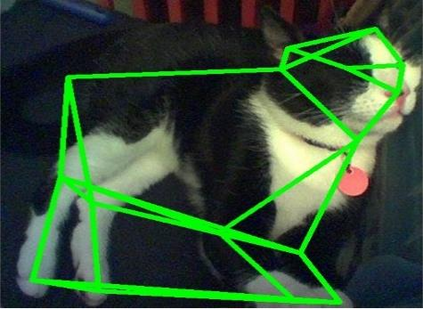

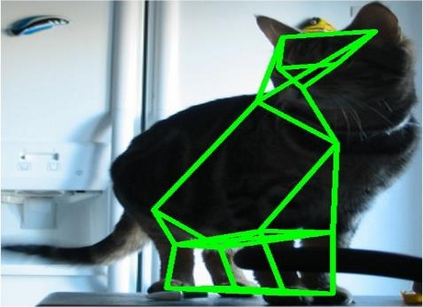

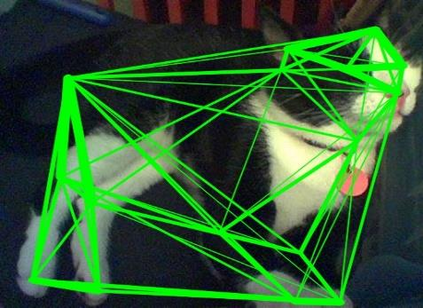

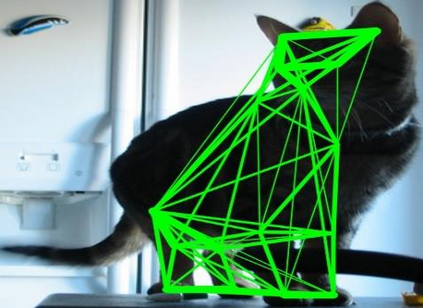

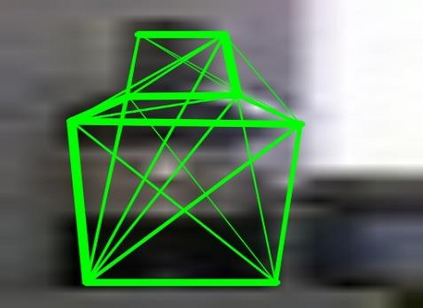

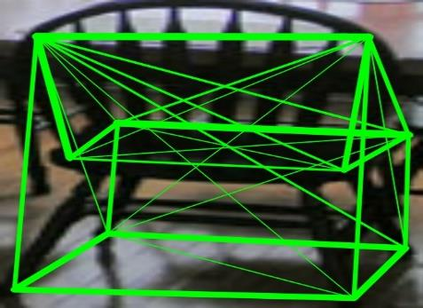

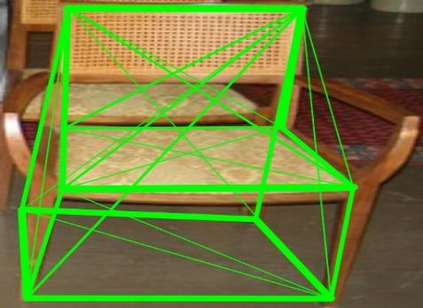

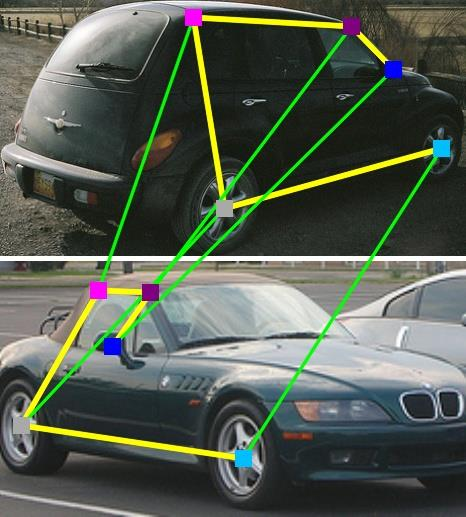

In recent years, powered by the learned discriminative representation via graph neural network (GNN) models, deep graph matching methods have made great progresses in the task of matching semantic features. However, these methods usually rely on heuristically generated graph patterns, which may introduce unreliable relationships to hurt the matching performance. In this paper, we propose a joint \emph{graph learning and matching} network, named GLAM, to explore reliable graph structures for boosting graph matching. GLAM adopts a pure attention-based framework for both graph learning and graph matching. Specifically, it employs two types of attention mechanisms, self-attention and cross-attention for the task. The self-attention discovers the relationships between features and to further update feature representations over the learnt structures; and the cross-attention computes cross-graph correlations between the two feature sets to be matched for feature reconstruction. Moreover, the final matching solution is directly derived from the output of the cross-attention layer, without employing a specific matching decision module. The proposed method is evaluated on three popular visual matching benchmarks (Pascal VOC, Willow Object and SPair-71k), and it outperforms previous state-of-the-art graph matching methods by significant margins on all benchmarks. Furthermore, the graph patterns learnt by our model are validated to be able to remarkably enhance previous deep graph matching methods by replacing their handcrafted graph structures with the learnt ones.

翻译:近些年来,在通过图形神经网络(GNN)模型(GNN)模型(通过图形神经网络(GNN)模型(GNN)的已知歧视代表法的推动下,深图匹配方法在匹配语义特征的任务中取得了巨大进步。然而,这些方法通常依赖于由超自然生成的图形模式,这些模式可能会引入不可靠的关系来伤害匹配性业绩。在本文中,我们建议建立一个名为GLAM的联合 emph{graph 学习和匹配网络(GLAM) 网络, 以探索用于提振图形匹配的可靠图形结构。 GLAM对图形学习和图形匹配都采用了纯粹的基于关注的框架。具体而言,它采用了两种类型的关注机制,即自我注意和交叉注意来完成任务。自觉意识发现功能之间的关系,并进一步更新所学结构的特征描述;在本文中,我们建议的两个数据集之间的交叉对比关系,称为GLAM。 此外,最后匹配解决方案直接来自跨观察层的输出,而不用特定的匹配决定模块。拟议方法是用三种流行的视觉匹配基准(Pascal VOC、Willowow Olial-stal-coal coal-coal-coal-coild-coir match-coild-coild-coild-coild-coild-coild-coild-s to to to tost tost tost tost couttal-st couttal-s to tost coutututtal-s to tostst codrup codrup cod-tod-tod-tod-tod-st commaild-s tod-st cod-s-s-s-tod-std-std-stital-sildal-std-st coild-st cod-st-st-st commad-sal-std-tod-todal-tod-std-d-st-s-s-s-s-s-s-s-st-st-stal-d-s-tod-tod-tod-tod-tod-tod-tod-stal-s-s-st-