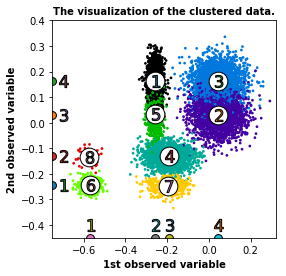

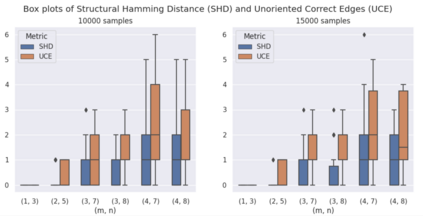

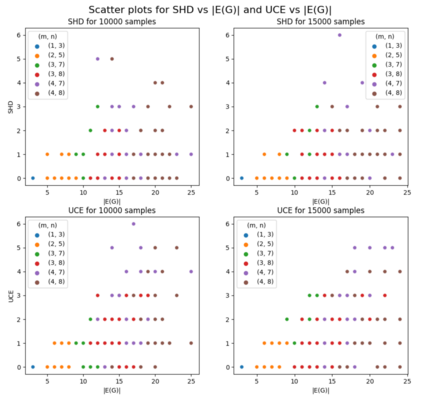

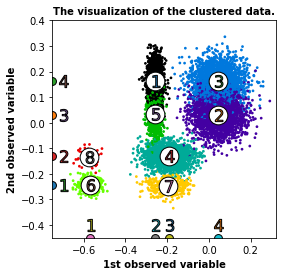

We study the problem of reconstructing a causal graphical model from data in the presence of latent variables. The main problem of interest is recovering the causal structure over the latent variables while allowing for general, potentially nonlinear dependence between the variables. In many practical problems, the dependence between raw observations (e.g. pixels in an image) is much less relevant than the dependence between certain high-level, latent features (e.g. concepts or objects), and this is the setting of interest. We provide conditions under which both the latent representations and the underlying latent causal model are identifiable by a reduction to a mixture oracle. The proof is constructive, and leads to several algorithms for explicitly reconstructing the full graphical model. We discuss efficient algorithms and provide experiments illustrating the algorithms in practice.

翻译:我们研究从存在潜在变数的数据中重建因果图形模型的问题。主要的关注问题是恢复潜在变数的因果结构,同时允许变量之间的一般、潜在的非线性依赖。在许多实际问题中,原始观测(如图像中的像素)之间的依赖性远不如某些高层次潜在特征(如概念或对象)之间的依赖性,而这正是利息的设定。我们提供了各种条件,使潜在表现和潜在潜在因果模型能够通过减少混凝土来识别。证据是建设性的,并导致若干算法,以明确重建完整的图形模型。我们讨论了高效的算法,并提供实验,说明实际中的算法。