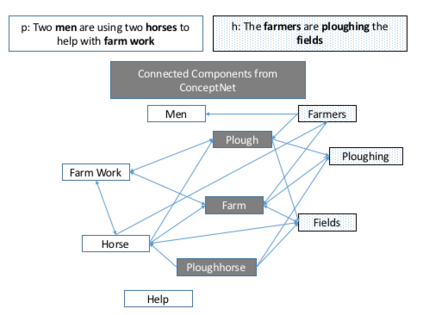

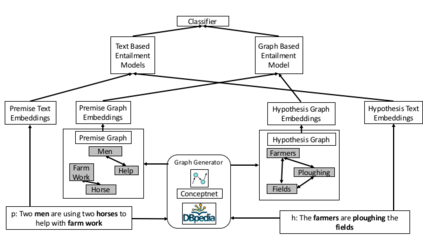

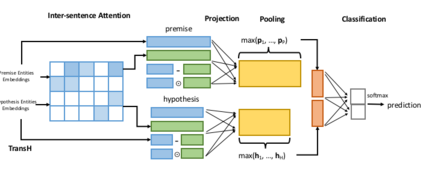

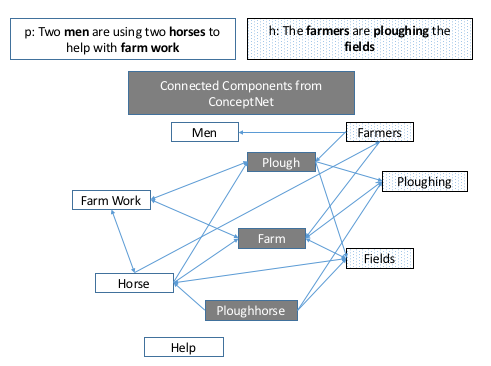

Natural Language Inference (NLI) is fundamental to many Natural Language Processing (NLP) applications including semantic search and question answering. The NLI problem has gained significant attention thanks to the release of large scale, challenging datasets. Present approaches to the problem largely focus on learning-based methods that use only textual information in order to classify whether a given premise entails, contradicts, or is neutral with respect to a given hypothesis. Surprisingly, the use of methods based on structured knowledge -- a central topic in artificial intelligence -- has not received much attention vis-a-vis the NLI problem. While there are many open knowledge bases that contain various types of reasoning information, their use for NLI has not been well explored. To address this, we present a combination of techniques that harness knowledge graphs to improve performance on the NLI problem in the science questions domain. We present the results of applying our techniques on text, graph, and text-to-graph based models, and discuss implications for the use of external knowledge in solving the NLI problem. Our model achieves the new state-of-the-art performance on the NLI problem over the SciTail science questions dataset.

翻译:自然语言推断(NLI)是许多自然语言处理应用的基础,包括语义搜索和回答问题。由于大规模、具有挑战性的数据集的发布,NLI问题已引起极大关注。目前解决问题的方法主要侧重于学习方法,这些方法仅使用文本信息,以便分类某一前提是否涉及、矛盾或与某一假设无关。令人惊讶的是,基于结构化知识的方法的使用 -- -- 人工智能中的一个核心议题 -- -- 相对于NLI问题没有受到多少关注。虽然有许多开放的知识基础包含各种推理信息,但没有很好地探讨这些基础用于NLI。为了解决这一问题,我们介绍了利用知识图的组合技术,用以改进NLI科学领域问题方面的绩效。我们介绍了在文本、图表和文本到文字模型上应用我们的技术的结果,并讨论了使用外部知识解决NLI问题的影响。我们的模型在SciTail问题上实现了NLI问题的新状态。