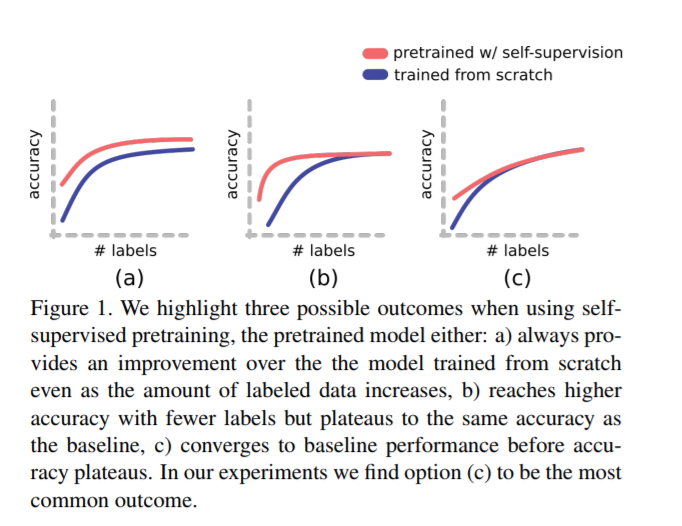

最近面向视觉任务的自监督预训练取得了惊人的进展。我们调研了哪些因素可能在预训练方法的效用中发挥作用。为此,我们评估了一系列综合数据集和下游任务中的各种自监督算法。我们准备了一套合成数据,可以提供无穷无尽的带注释的图像,以及完全控制数据集的难度。我们的实验提供了关于自我监督的效用如何随着可用标签数量的增长而变化,以及效用如何随着下游任务和训练数据的属性而变化的见解。代码和数据在https://github.com/princeton-vl/selfstudy中可用。

成为VIP会员查看完整内容

相关内容

CVPR is the premier annual computer vision event comprising the main conference and several co-located workshops and short courses. With its high quality and low cost, it provides an exceptional value for students, academics and industry researchers.

CVPR 2020 will take place at The Washington State Convention Center in Seattle, WA, from June 16 to June 20, 2020.

http://cvpr2020.thecvf.com/

专知会员服务

43+阅读 · 2020年1月28日

Arxiv

11+阅读 · 2019年10月30日