论文题目: How to Fine-Tune BERT for Text Classification?

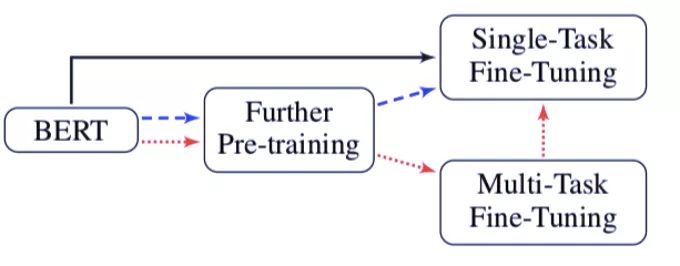

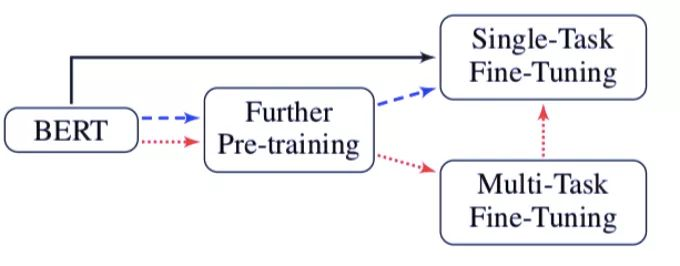

论文摘要: 预训练语言模型已经在学习通用语言表示上证明了存在的价值。作为一个 SOTA 预训练语言模型,BERT(基于 Transformer 的双向编码表示)在许多语言理解任务上取得了惊人的结果。在本文中,研究者进行了一项费时费力的实验,用于探索在 BERT 上进行各种微调方法,以使其用于文本分类任务上。最终,研究者提出了一个通用的 BERT 微调方法。论文提出的方法在 8 个常见的文本分类数据集上取得了新的 SOTA 结果。

作者简介:

邱锡鹏,复旦大学计算机科学技术学院副教授,博士生导师。于复旦大学获得理学学士和博士学位。主要从事自然语言处理、深度学习等方向的研究,在ACL、EMNLP、AAAI、IJCAI等计算机学会A/B类期刊、会议上发表50余篇学术论文,引用 1900余次。开源中文自然语言处理工具FudanNLP作者,FastNLP项目负责人。2015年入选首届中国科协人才托举工程,2017年ACL杰出论文奖,2018年获中国中文信息学会“钱伟长中文信息处理科学技术奖—汉王青年创新奖”。

黄萱菁,1989~1998年就读于复旦大学计算机系,先后获学士、博士学位。1998年留校任教,2006年晋升为教授,博士生导师。2008~2009年在美国麻省大学智能信息检索中心从事访问学者研究。现为中国青年科技工作者协会会员,中国中文信息学会理事。等

成为VIP会员查看完整内容

相关内容

专知会员服务

52+阅读 · 2019年12月28日