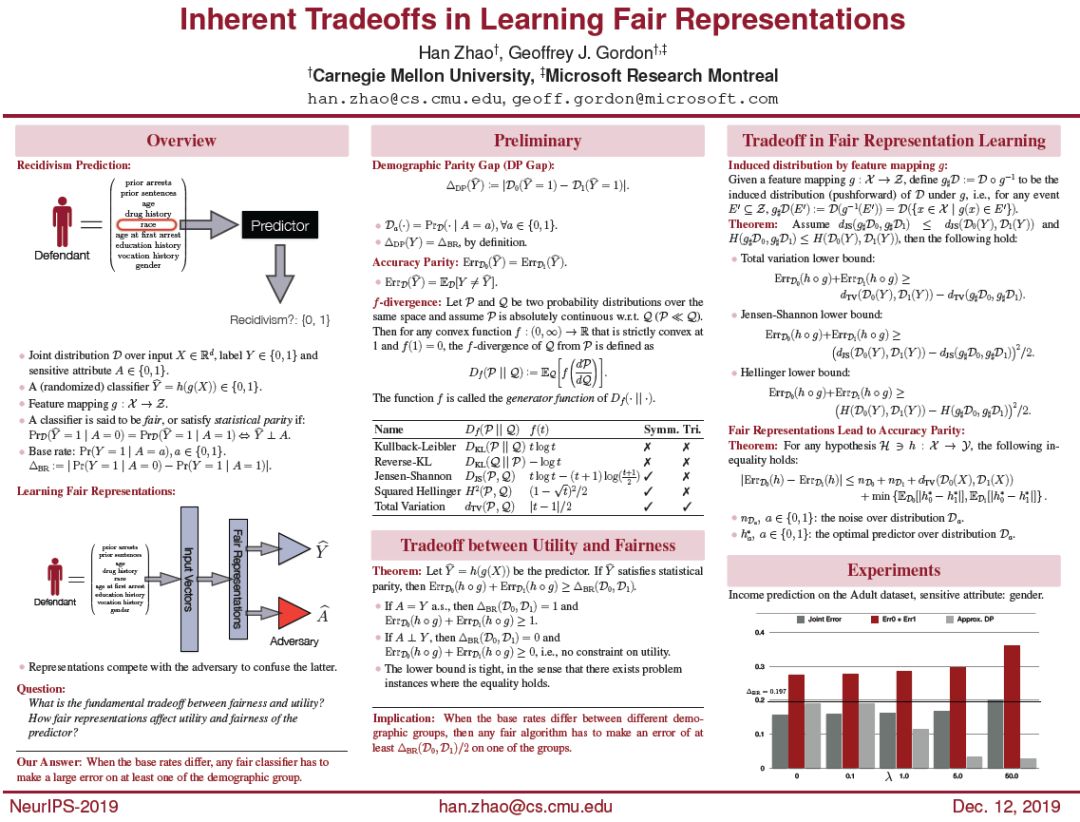

机器学习应用在高风险领域(如刑事判决、医学测试、在线广告等)的流行,至关重要的是要确保这些决策支持系统不会传播历史数据中可能存在的现有偏见或歧视。一般来说,在算法公平文献中有两个关于公平的中心概念。第一个是个体公平,它要求公平的算法以相似的方式对待相似的个体。然而,在实践中,通常很难找到或设计一个社会可接受的距离度量来捕获个体之间关于特定任务的相似性。相反,在这篇博客文章中,我们关注的是公平的第二个概念,群体公平,更具体地说是统计上的平等,这本质上要求预测器的结果在不同的子群体中是平等的。

成为VIP会员查看完整内容