时间序列数据存在于现实世界系统和服务的每个角落,范围从天空中的卫星到人体上的可穿戴设备。通过提取和推断这些时间序列中的有价值信息来学习表示,对于理解特定现象的复杂动态和做出明智的决策至关重要。有了学习到的表示,我们可以更有效地进行众多下游分析。在几种方法中,深度学习在无需手动特征工程的情况下提取时间序列数据中隐藏的模式和特征方面展示了卓越的性能。这篇综述首先基于三个基本元素提出了一个新颖的分类法,这三个元素用于设计最先进的通用时间序列表示学习方法。根据提出的分类法,我们全面回顾了现有研究,并讨论了这些方法如何提高学习表示质量的直觉和洞察。最后,作为未来研究的指南,我们总结了常用的实验设置和数据集,并讨论了几个有前景的研究方向。最新的对应资源可在 https://github.com/itouchz/awesome-deep-time-series-representations 获取。

1.1 背景

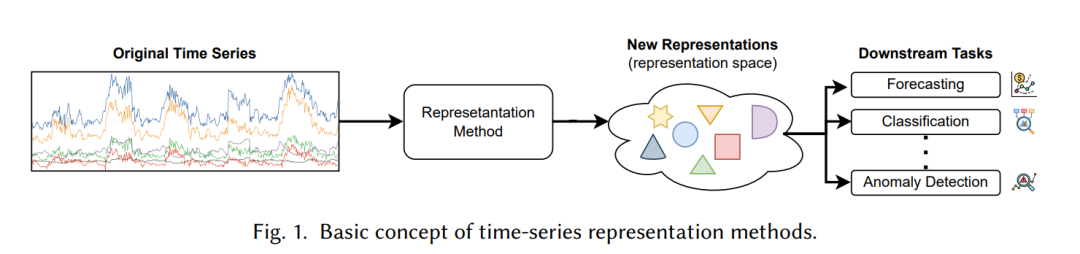

时间序列是按时间顺序记录的数据点序列,反映了特定变量或现象随时间的复杂动态。时间序列数据可以在不同时间点代表各种应用领域的有意义信息,使得做出明智的决策和预测成为可能,例如物联网中的传感器读数[1, 2]、网络物理系统中的测量[3, 4]、股票市场的波动[5, 6]以及可穿戴设备上的人类活动[7, 8]。然而,要从这些复杂的观测中提取和理解有意义的信息,我们需要一种表示这些时间序列的机制,这导致了时间序列表示研究的出现。基于新的表示,我们可以有效地进行各种下游时间序列分析[9],例如预测[10]、分类[11]、回归[12]和异常检测[13]。图1描绘了时间序列数据表示方法的基本概念。早期的尝试[14]使用分段线性方法(例如,分段聚合近似)、基于符号的方法(例如,符号聚合近似)、基于特征的方法(例如,形状片段)或基于变换的方法(例如,离散小波变换)来表示时间序列。这些传统的时间序列表示方法因依赖领域知识和预定义先验的通用性差而被认为是耗时且效率较低的。由于表示的质量显著影响下游任务的性能,许多研究提出自动学习有意义的时间序列表示[15-17]。这些研究的主要目标是获得高质量的时间序列学习表示,捕获数据中的有价值信息并揭示相应系统或现象的潜在动态。在几种方法中,神经网络或深度学习(DL)在从广泛数据中提取隐藏的模式和特征方面展现了前所未有的性能,包括时间序列,且不需要手动特征工程。

鉴于时间序列的序贯性质,循环神经网络(RNN)及其变体,如长短时记忆和门控循环单元,被认为是捕获时间序列中时间依赖性的热门选择[18, 19]。然而,基于循环的网络复杂且计算成本高。另一方面的工作采用一维卷积神经网络(CNN)来提高计算效率,利用卷积操作的并行处理[20]。尽管基于RNN和CNN的模型在捕获时间依赖性方面表现良好,但它们无法显式地模拟多变量时间序列中不同变量之间的关系。许多研究提出使用基于注意力的网络或图神经网络,通过注意力机制或图结构来共同学习每个变量中的时间依赖性以及多变量时间序列中不同变量之间的相关性[21, 22]。尽管在架构设计方面取得了显著进展,但在现实世界场景中,时间序列可能会不规则地收集或由于传感器故障导致缺失值,使得常用的神经网络由于插补过程中的不利副作用而变得低效。因此,最近的研究将神经常微分方程集成到现有网络中,使模型能够产生连续的隐藏状态,从而对不规则时间序列具有鲁棒性[23, 24]。

此外,基于深度学习(DL)的方法的可靠性和有效性通常取决于充足的、标注良好的数据的可用性,这通常被称为监督学习。然而,时间序列数据本质上是连续值的,含有高水平的噪声,且其视觉模式不那么直观易辨。与图像或文本中人类可识别的模式不同,时间序列数据在现实世界设置中的语义意义在应用领域间可能不一致。因此,获得一个标注良好的时间序列不可避免地效率低下,即使对于领域专家来说也更具挑战性,因为它们从不同频率的多种传感器或可穿戴设备收集的时间演化观测动态复杂。例如,我们可以从智能工厂收集大量传感器信号,而其中只有少数可以由领域专家标注。为了避免繁琐的标注过程和减少对标记实例的依赖,对无监督和自监着学习方法的兴趣日益增长,这些方法使用从各种前置任务中自生成的标签,而不依赖于人类标注[25-28]。虽然无监督和自监着表示学习都旨在从复杂的原始时间序列中提取潜在表示,而不依赖于人类标注的标签,但它们的基本机制不同。无监督学习方法[28]通常采用自动编码器和序列到序列模型,通过基于重构的学习目标来学习有意义的表示。然而,准确地重构复杂的时间序列数据仍然具有挑战性,尤其是对于高频信号。相反,自监着学习方法[26]利用前置任务,通过利用未标注数据中提取的内在信息,自主生成标签。最近,提出了带有对比损失的前置任务(也称为对比学习),通过自生成的监督信号进行区分性的预训练,以提高学习效率。对比学习的目标是在特征空间中使相似样本更接近,同时将不相似样本推远。这些前置任务是模型从未标注数据中学习解决的自生成挑战,因此能够为多个下游任务产生有意义的表示[29]。

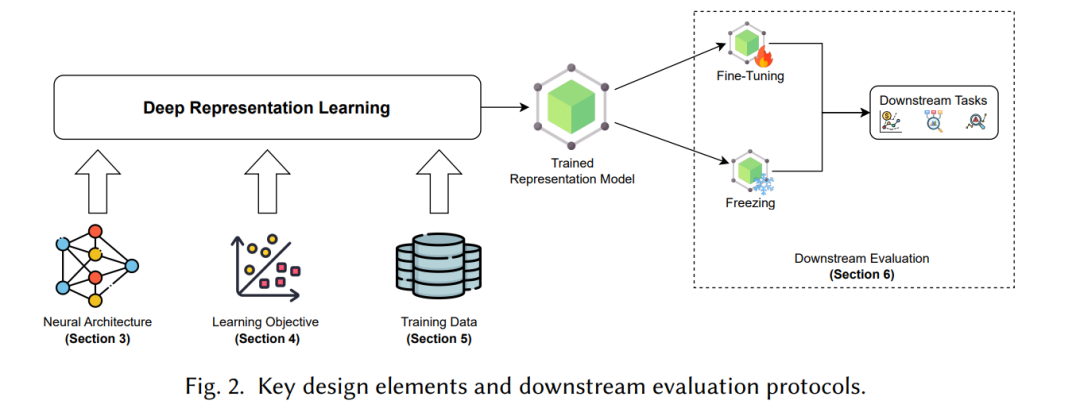

为了进一步提高表示质量并减轻在特定设置中训练样本有限的影响,例如在收集足够大数据量受限的情况下(例如,与人相关的服务),一些研究还采用了数据相关技术,例如增强[30]和转换[31],在现有学习方法之上。相应地,我们可以有效地增加训练数据的规模并提高其质量。这些技术在生成前置任务时也被认为是必不可少的。与其他数据类型不同,处理时间序列数据需要考虑其独特的属性,例如时间依赖性和多尺度关系[32]。本文旨在识别设计最先进的时间序列表示学习方法中的关键元素,以及这些元素如何影响学习到的表示的质量。据我们所知,这是第一篇关于通用时间序列表示学习的综述。我们提出了一种新颖的分类法,用于从新颖性角度学习时间序列的通用表示——即论文的主要贡献集中在上述哪些设计元素上——以总结选定的研究。表2总结并比较了基于所提分类法的审阅文章。从神经架构的角度来看,我们总结了用于表示学习的神经架构在模块层面和网络层面上的变化。从学习角度来看,我们分类了用于使学习到的表示能够泛化到各种下游任务的目标。最后,我们还对特别关注提高训练数据质量的论文进行了数据中心的方法分类。

总的来说,我们的主要贡献如下。

- 我们基于一种新颖且最新的分类法,对通用时间序列表示学习进行了广泛的文献综述,将审阅的方法归类为三个主要类别:神经架构、学习为重点和数据中心方法。

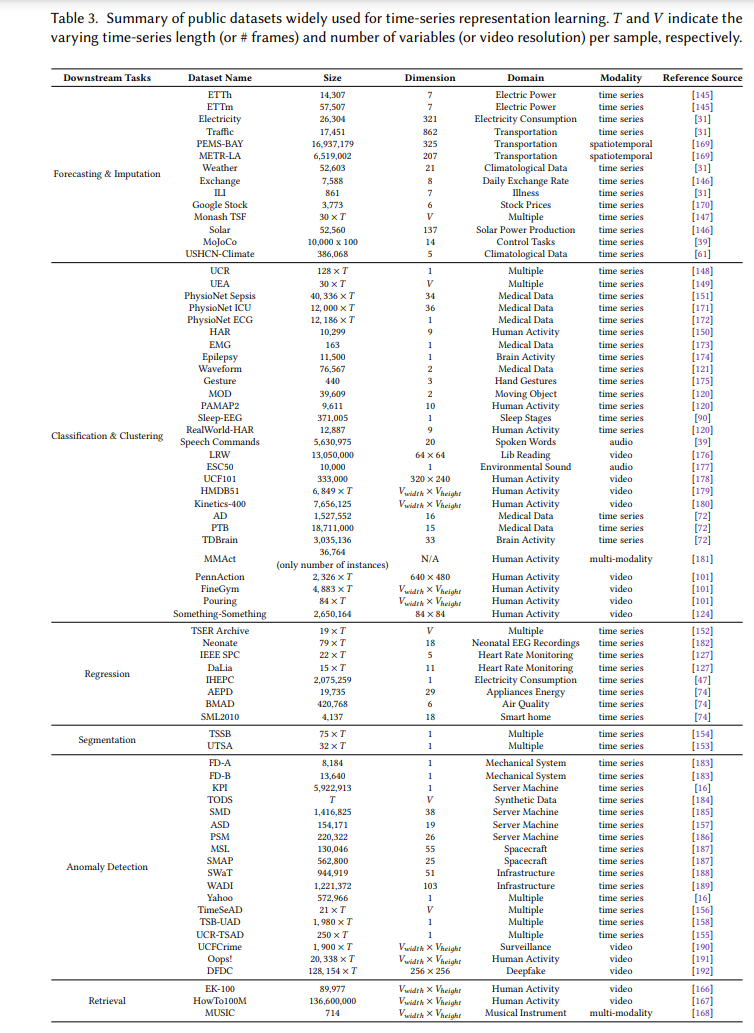

- 我们提供了一个关于实验设置和评估时间序列表示学习方法的基准数据集的指南。

- 我们讨论了几个开放的研究挑战和新见解,以促进未来的工作。

第2节介绍了时间序列表示学习的定义和具体背景知识。在第3节中,我们全面回顾了关注神经架构方面的方法。然后,在第4节中,我们讨论了关注推导新学习目标的方法。第5节对数据中心方法进行了回顾。此外,我们在第6节和第7节分别讨论了时间序列表示学习的评估协议和有前途的未来研究方向。最后,第8节总结了这篇综述。

结论

本文介绍了一项通用时间序列表示学习研究及其对下游时间序列分析的重要性。我们提供了一份全面且最新的关于时间序列通用表示学习的文献综述,通过从设计角度对最近的进展进行分类。我们的主要目标是回答每个基本设计元素——神经架构、学习目标和训练数据——在最先进的时间序列表示学习方法中如何贡献于学习表示质量的提升,从而形成一个具有十五个子类别的新型结构化分类法。尽管大多数最先进的研究在其方法中考虑了所有设计元素,但只有一个或两个元素是新提出的。根据对选定研究的当前综述,我们发现数据中心方法中的分解和转换方法以及样本选择技术仍然未被充分探索。此外,我们提供了关于标准实验设置和特定下游任务广泛使用的时间序列数据集的实用指南,并讨论了与时间序列表示学习相关的各种开放挑战和未来研究方向。最终,我们希望这篇综述能成为对时间序列通用表示学习方法有多方面理解兴趣的从业者和研究人员的宝贵资源。