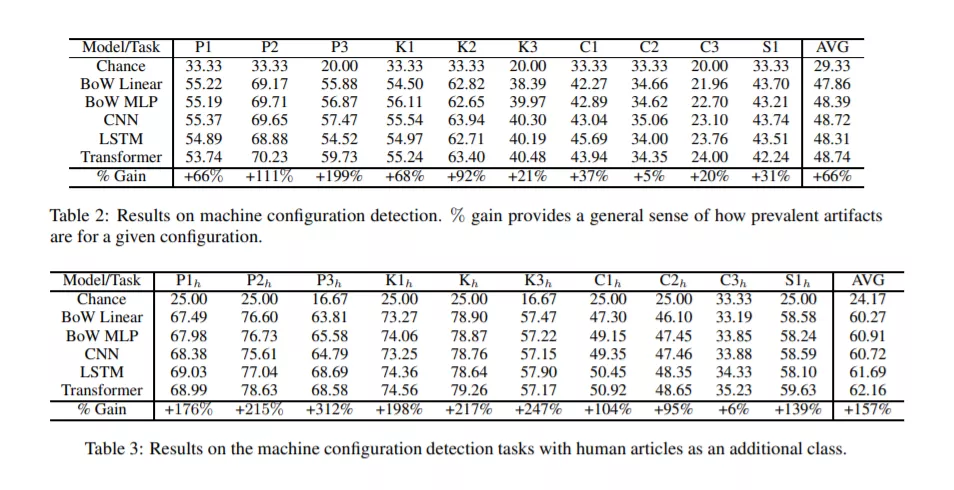

本文试图对神经文本生成模型的基本性质有更深入的理解。对机器生成文本中由于建模选择而出现的构件的研究是一个新兴的研究领域。在此之前,这些人工制品在生成文本中出现的范围和程度还没有得到很好的研究。为了更好地理解生成文本模型及其构件,我们提出了一项新的任务,即区分给定模型的几个变体中哪个生成了一段文本,我们进行了一系列诊断测试,以观察建模选择(例如,抽样方法、top-k概率、模型架构等)是否在它们生成的文本中留下可检测的构件。我们的关键发现得到了一组严格实验的支持,即存在这样的构件,并且可以通过单独观察生成的文本推断出不同的建模选择。这表明,神经文本生成器对各种建模选择的敏感度可能比之前认为的要高。

成为VIP会员查看完整内容