深度学习笔记系列(二):特征值,特征向量与SVD奇异值分解

本文是深度学习笔记系列文章,本次文章将介绍线性代数里比较重要的概念:特征值,特征向量以及SVD奇异值分解。

向量

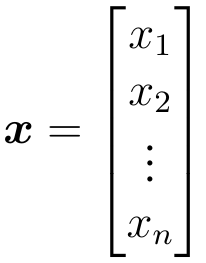

回顾线性代数中,含有n个元素的向量可以表示为:

一般默认向量为列向量,也就是n行1列的矩阵,行向量表示为x的转置即

特征值和特征向量

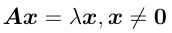

当维度为n*n的方阵A、n维向量x和实数 λ满足下式时:

上式可以看成将矩阵 A 作用在向量 x 上,只对该向量的长度进行变换,此时λ 为矩阵 A 的特征值,x 为对应的特征向量(从几何角度看左乘一个矩阵可以看成一个空间变换)。

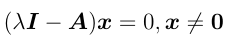

将上式变换一下可得:

当且仅当矩阵

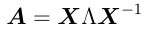

令矩阵 A 的第 i 个特征值为 λi, 对应的特征向量为 xi, 所有特征向量构成的矩阵为 X ,若X可逆,则A可对角化表示为:

其中 Λ 为所以对应特征值组成的对角矩阵.

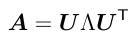

特别的若A为对称矩阵,则A的特征值均为实数,特征向量可化为正交特征向量,即X为正交矩阵,用U表示,则矩阵A可表示为:

SVD奇异值分解

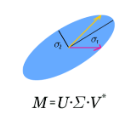

若A为m*n矩阵,则存在m*m的正交矩阵U、n*n的正交矩阵V和m*n的对角矩阵D满足:

其中U为左奇异矩阵,列向量为

SVD应用

SVD一个常见的应用就是降维,如对于图像数据矩阵A进行SVD,取前k大的奇异值,U和V都取前k个向量,再恢复到原图像大小,k取值合理的情况下可以与原图几乎一样,这样就实现了对图像的压缩.

可以发现和PCA主成分分析很相似。在PCA中我们先计算协方差矩阵,再求出前k大特征值对应的特征向量作为主成分,对数据进行降维。

当计算协方差矩阵时,我们需要计算

此系列所有的文章整理后会发布在 https://github.com/linhaow/DLnotes

本文转载在公众号:纸鱼AI,作者:linhw

推荐阅读

Transformer详解《attention is all your need》论文笔记

AINLP-DBC GPU 云服务器租用平台建立,价格足够便宜

我们建了一个免费的知识星球:AINLP芝麻街,欢迎来玩,期待一个高质量的NLP问答社区

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLP君微信(id:AINLP2),备注工作/研究方向+加群目的。