ICML2019最佳论文奖新鲜发布,Google、ETH、MaxPlanck、剑桥成最终赢家

源 / 专知

正在美国加州举办的,第36届国际机器学习大会(ICML)公布了本届会议最佳论文奖结果,分别是来自苏黎世联邦理工大学-MaxPlanck研究所-谷歌大脑的《挑战无监督分离式表示学习常见假设》以及剑桥大学的《稀疏变分高斯过程回归的收敛速度》。

论文便捷下载

关注公众号,后台回复关键词

20190613

即可下载

根据公开数据显示,今年ICML共提交论文数3424篇,录用774,录取率为22.6%。

1、Challenging Common Assumptions in the Unsupervised Learning of Disentangled Representations

本篇论文为苏黎世联邦理工学院、MaxPlanck智能系统研究所、谷歌大脑联合出品。

在本篇文章中,我们对无监督分离式表示学习进行了大规模的评估工作,并针对一些常见的假设进行了细致分析,以便对未来的工作方向提供一些建设性的改进建议。该评估工作实在7个不同的数据集中训练了12000个模型,并涵盖了最重要的方法和评估指标。重要的是,作者还发布了本研究中的相关代码及一万多个预训练模型,由此产生的工具包(disentanglement_lib),允许研究人员基于此进行自己的研究工作,并轻松重现我们的研究工作。

本文从理论和实践两个维度进行了细致验证,具体的贡献点可概括如下:

-

从理论上:如果没有考虑学习方法与数据集所产生的归纳偏置,那么基本无法实现分离式表示的无监督学习过程。

-

从实践上:在大规模可重复的实验研究中,分析了当前主流方法和其归纳偏置,该研究采用了完善的无监督分离式实验方案,本文实现了六种最新的无监督分离式学习方法,并在7个数据集中训练了12000个模型。

-

发布了disentanglement_lib,用于供其他研究人员重现我们的工作。

-

挑战了分离式无监督学习中的一些共识:

-

观察到表示维度具有一定的相关性

-

初始种子与超参数似乎比模型选择更加的重要,没有发现任何证据表明模型可以通过无监督方式可靠的学习到分离式表示特征,另外如果无法访问到ground-truth标签,即使能够迁移预训练得到的超参数,似乎也无法得出高质量的结果。

-

目前没有很强的证据表明,分离式特征对下游任务是有效的,例如通过降低学习的样本复杂性。

2、Rates of Convergence for Sparse Variational Gaussian Process Regression

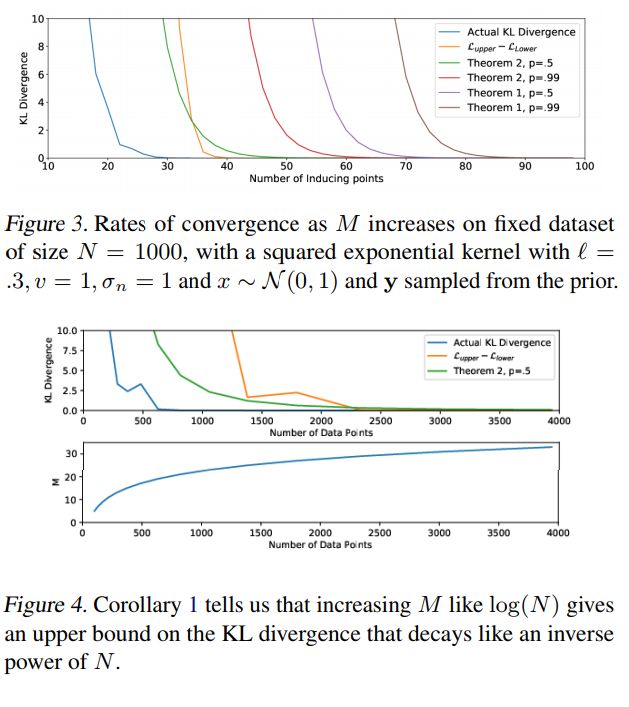

目前实现的高斯过程后验的变分近似算法,可以有效降低数据集计算成本复杂度。虽然计算成本似乎是随数据集规模线性增长的,但算法真正的复杂性却取决于如何增加诱导变量的数量,来保证一定的近似质量。

研究人员通过KL散度的上界特性来解决这一问题,证明了在高概率情况下,诱导变量数目的增长速度比数据集规模要慢。例如,对于具有D维的整体分布回归,使用流行的Squared Exponential核就足够了。结果表明,随着数据集增长,高斯过程后验可以真正近似地逼近目标,并为如何在连续学习场景中增加诱导变量提供具体的规则。

推荐阅读