Transformer模型-深度学习自然语言处理,17页ppt

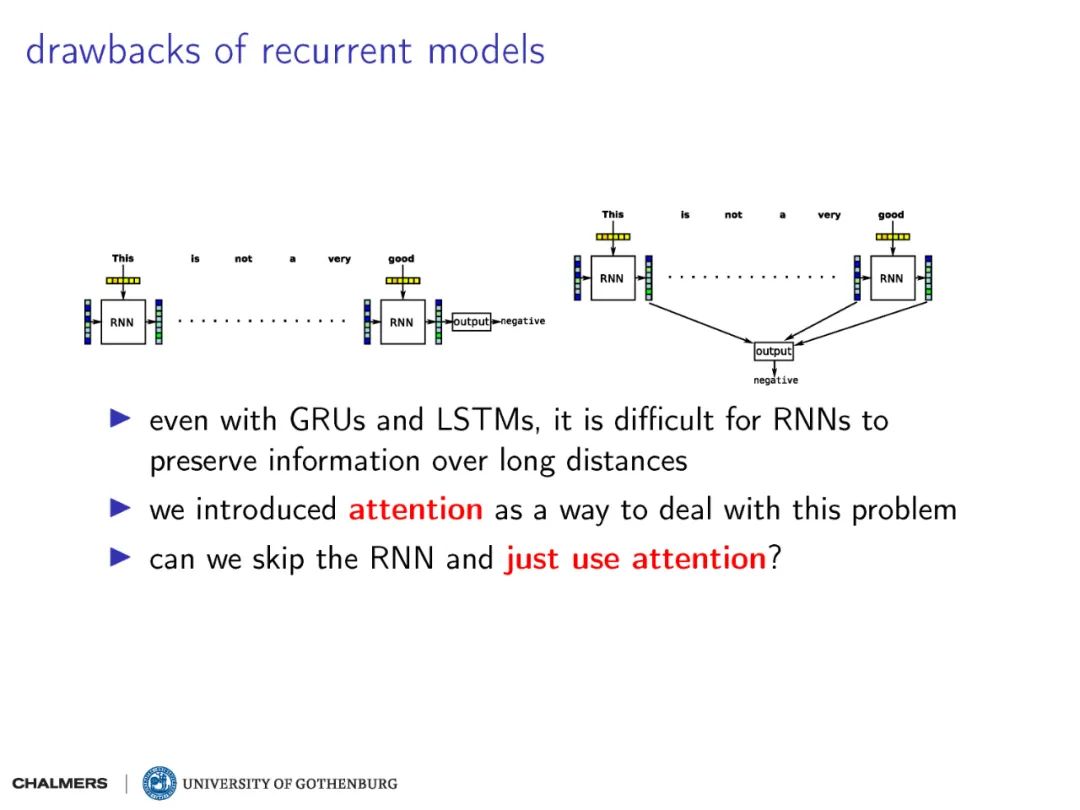

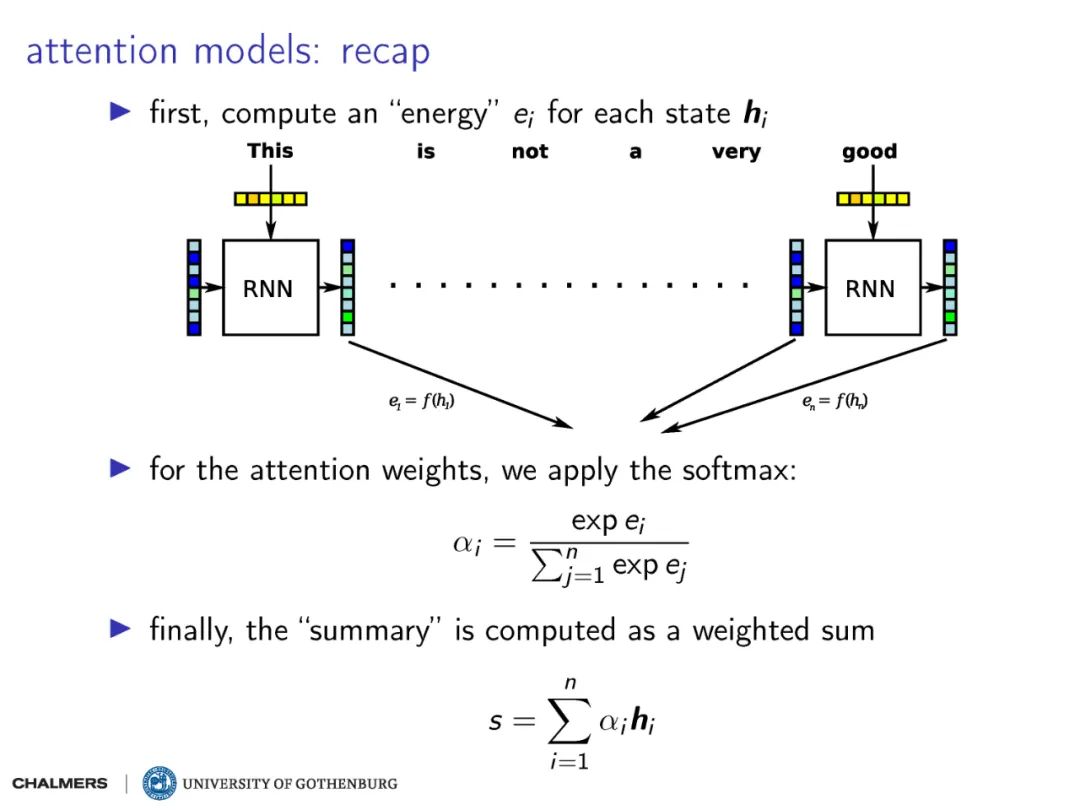

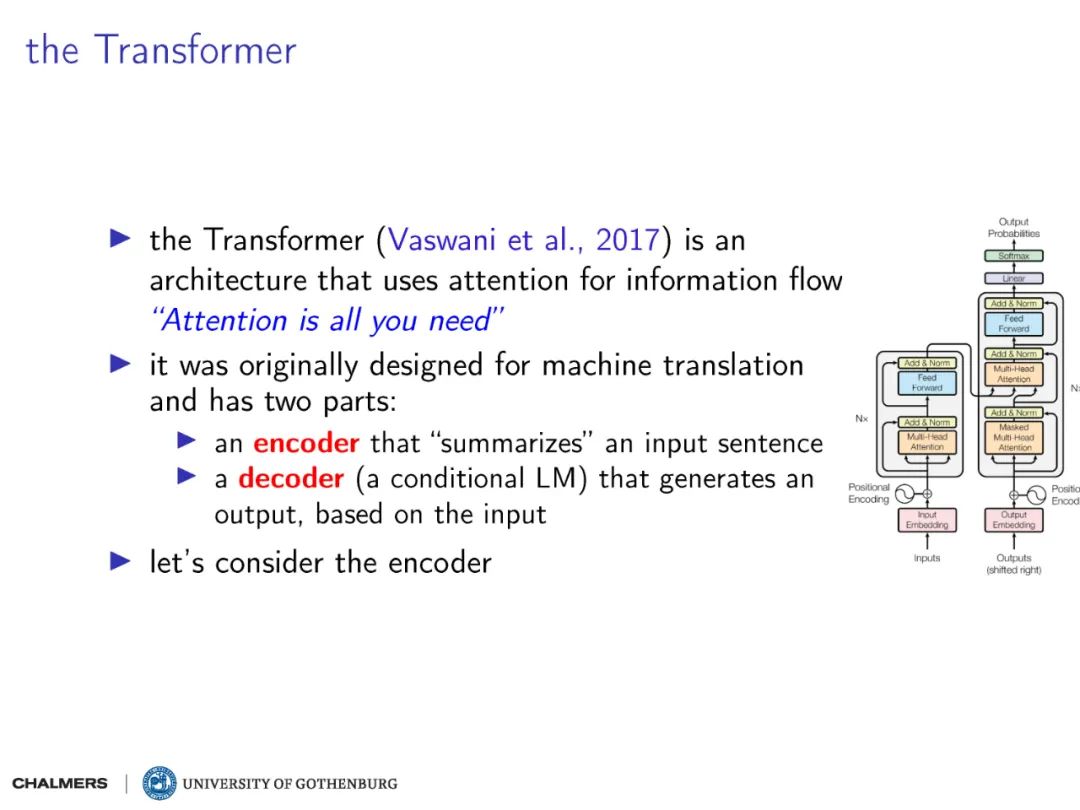

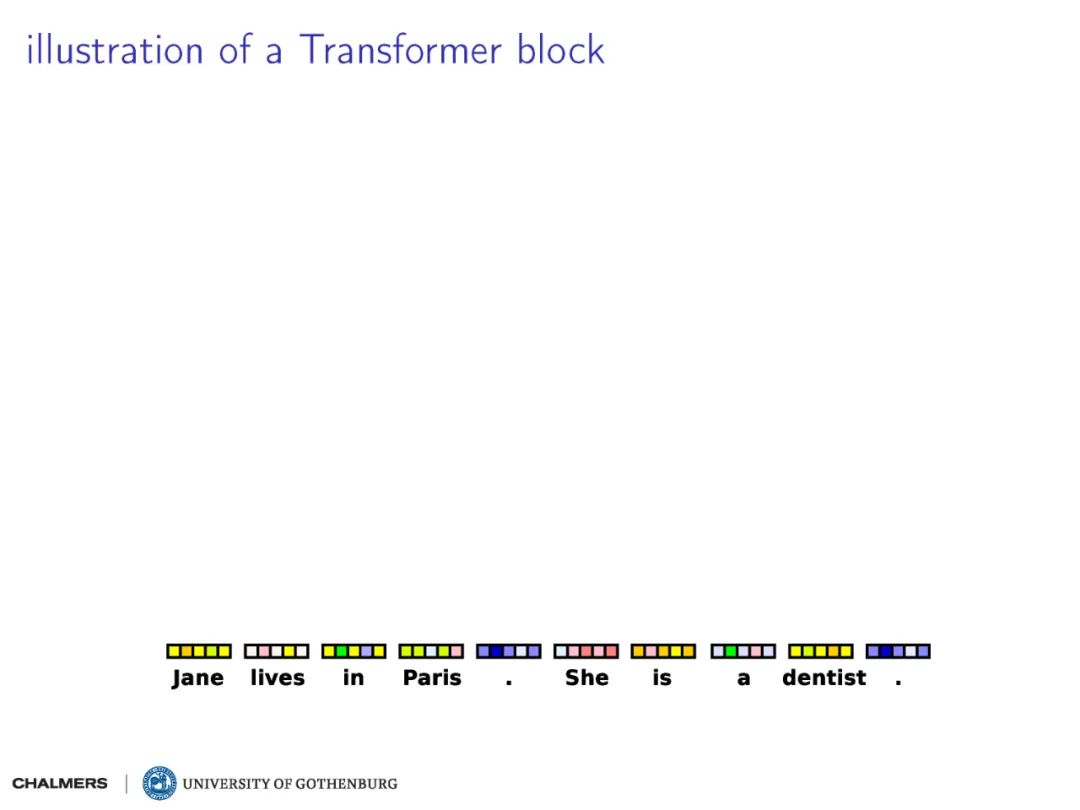

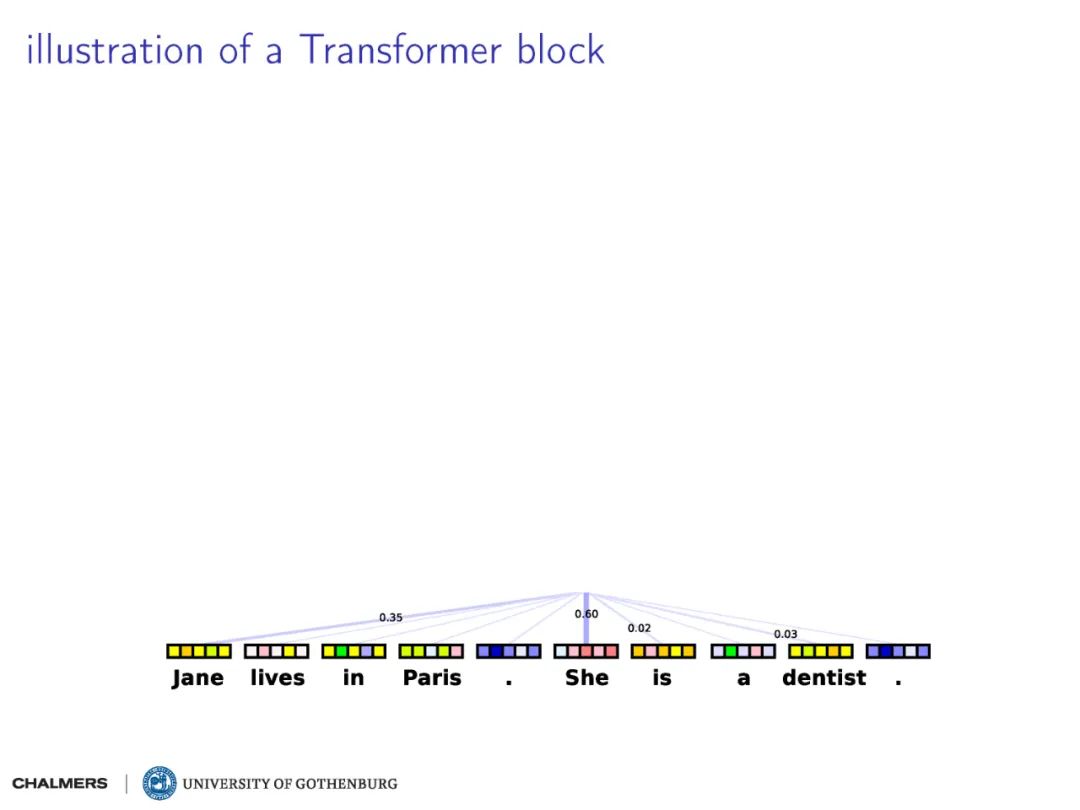

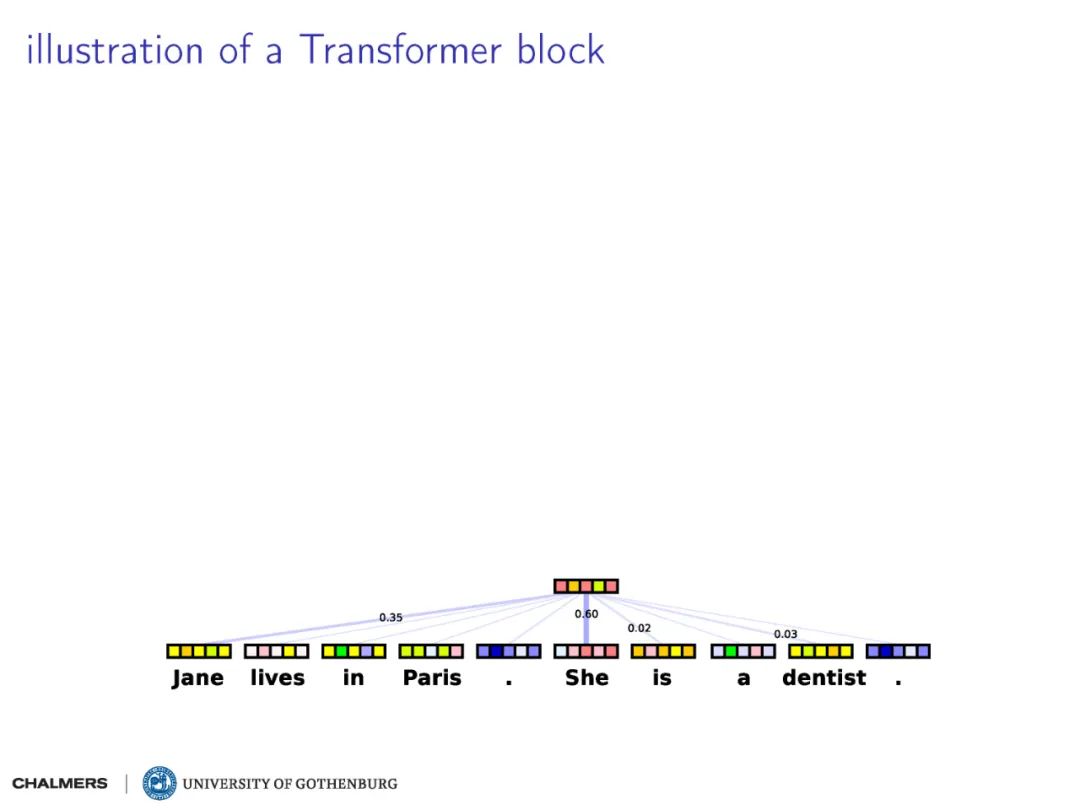

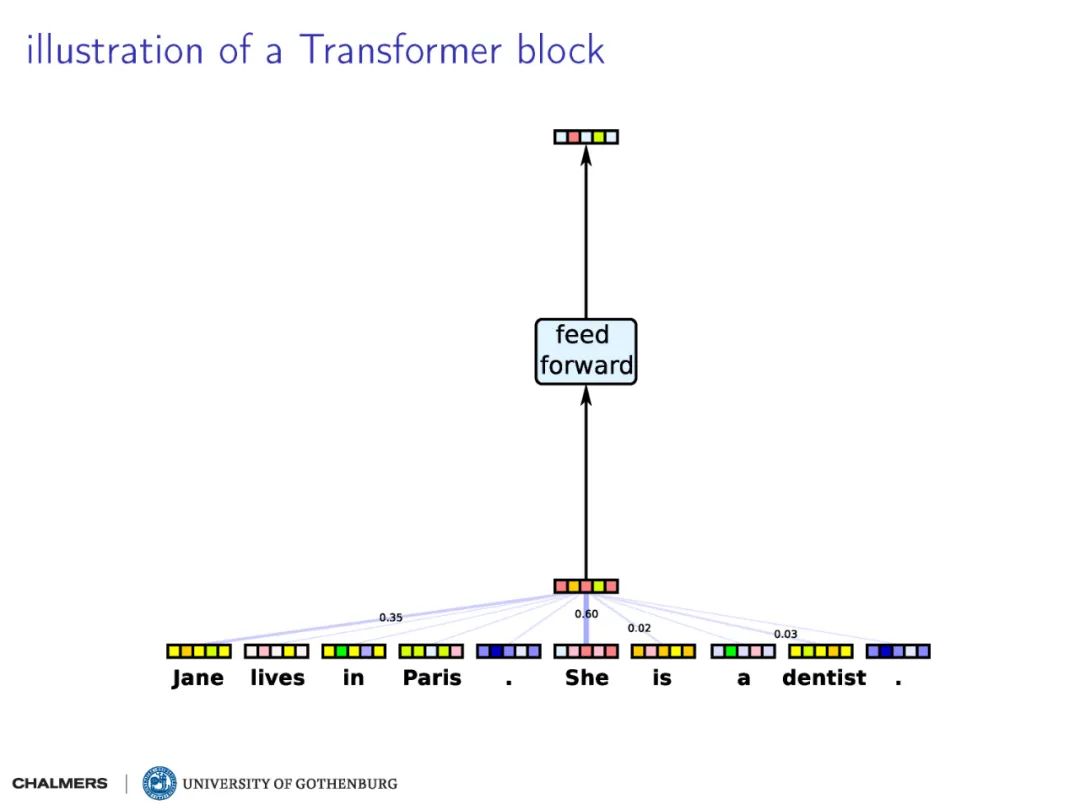

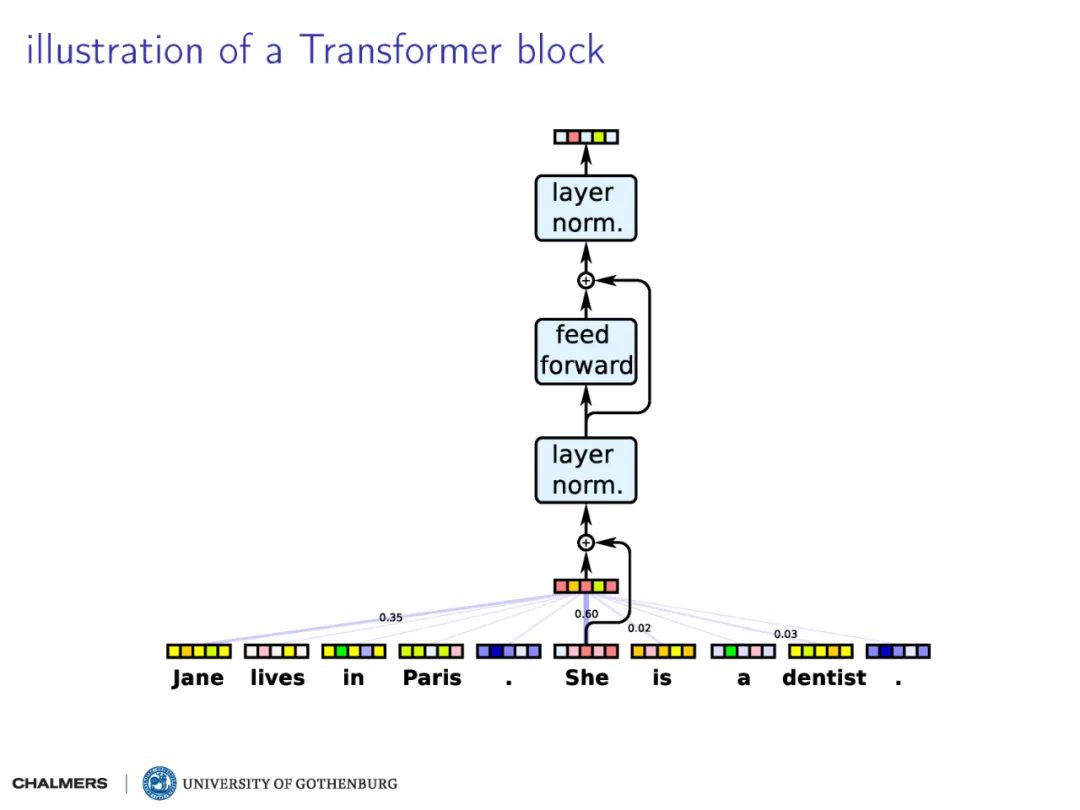

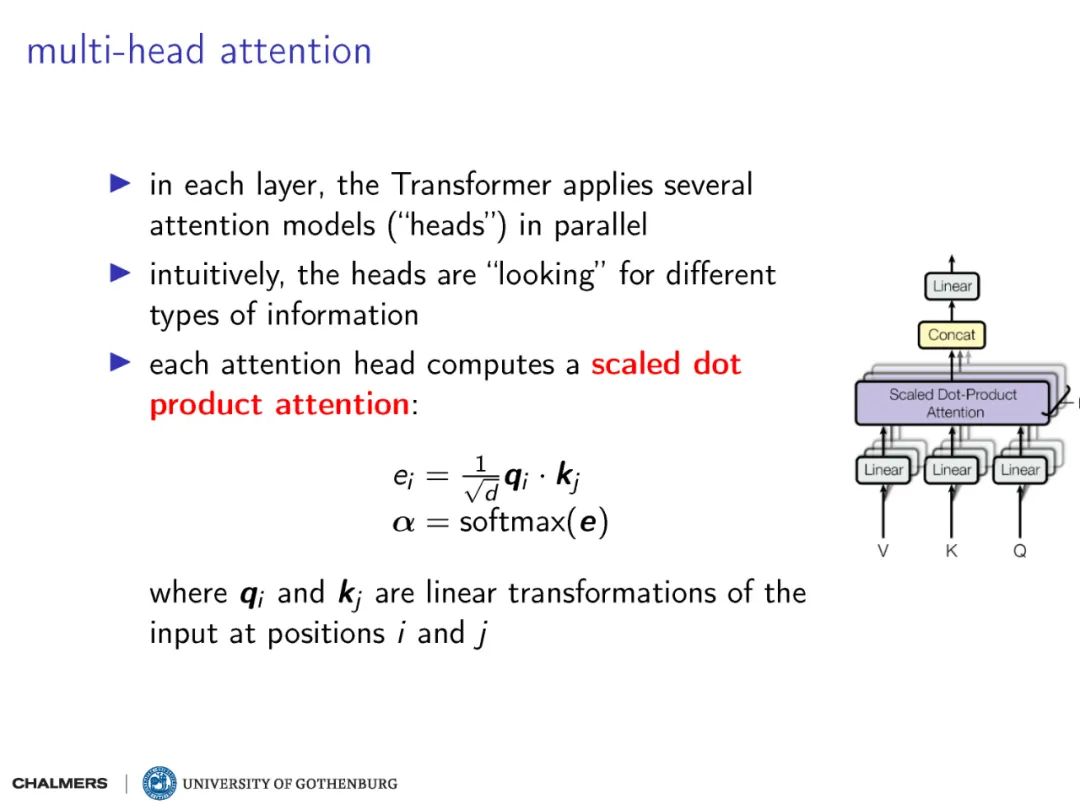

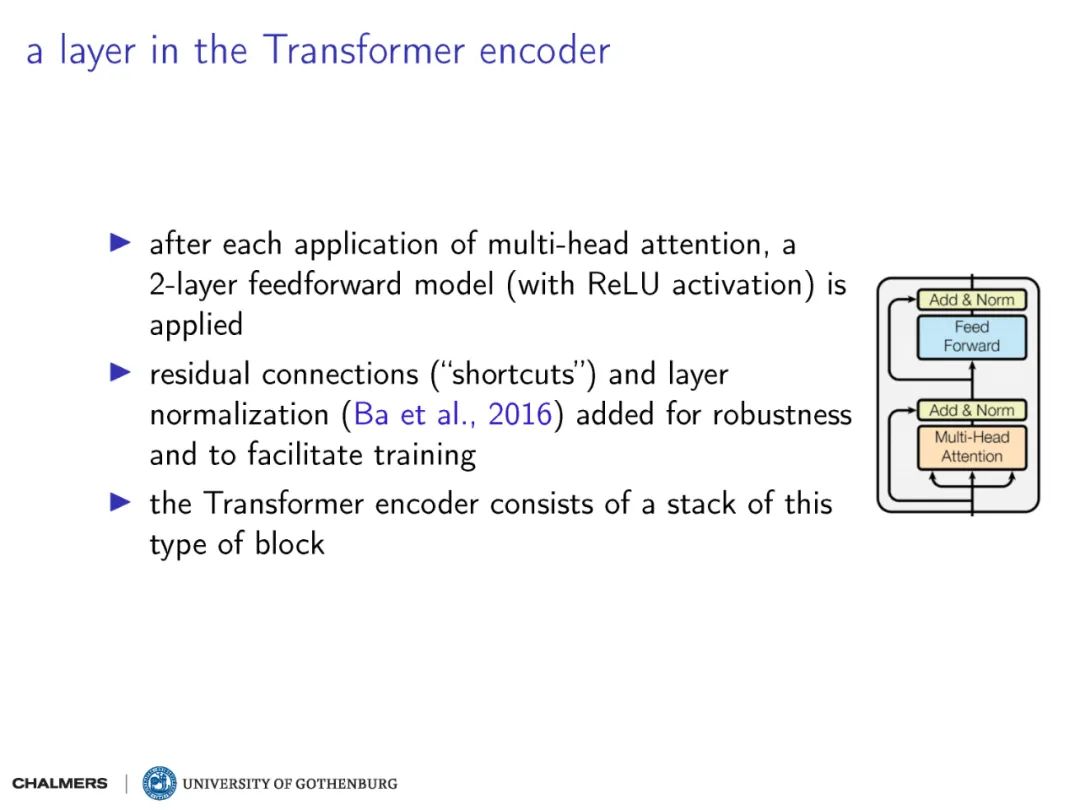

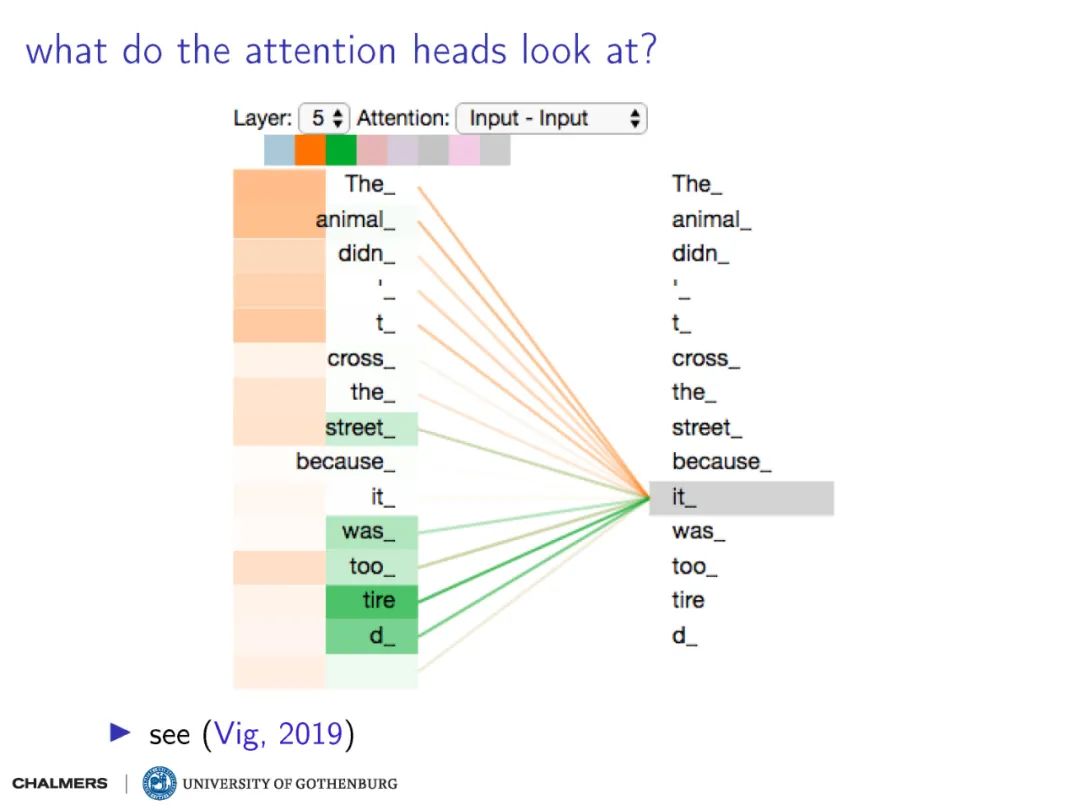

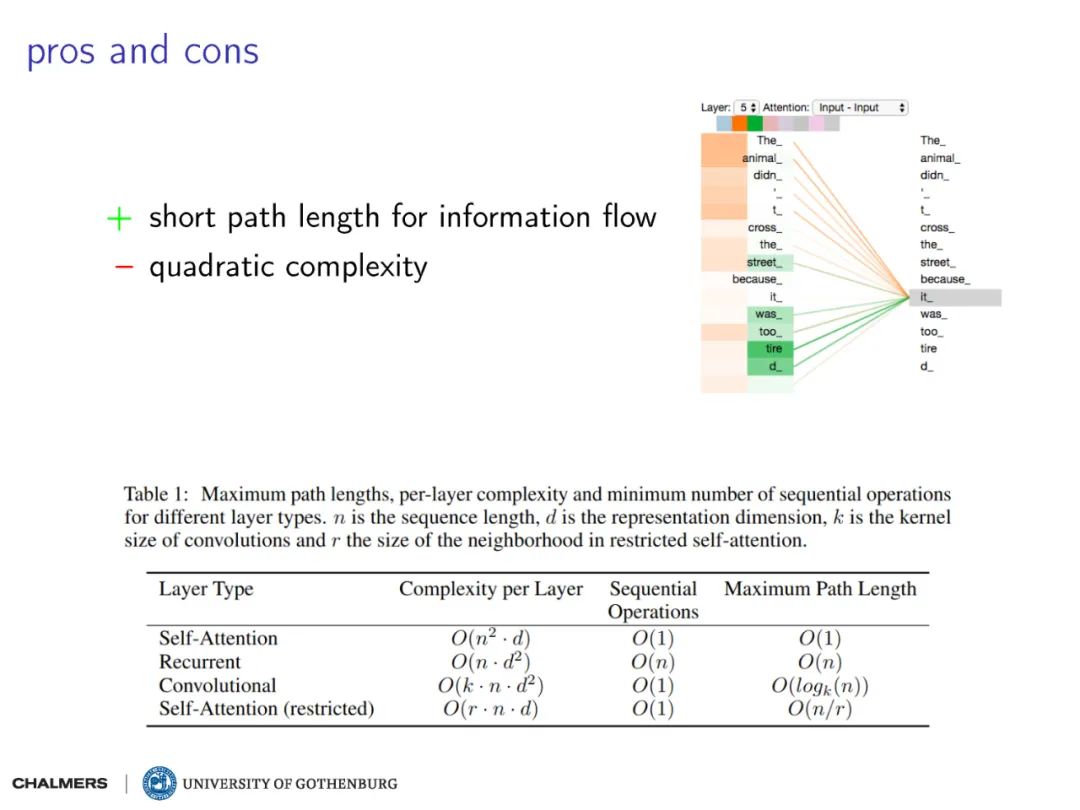

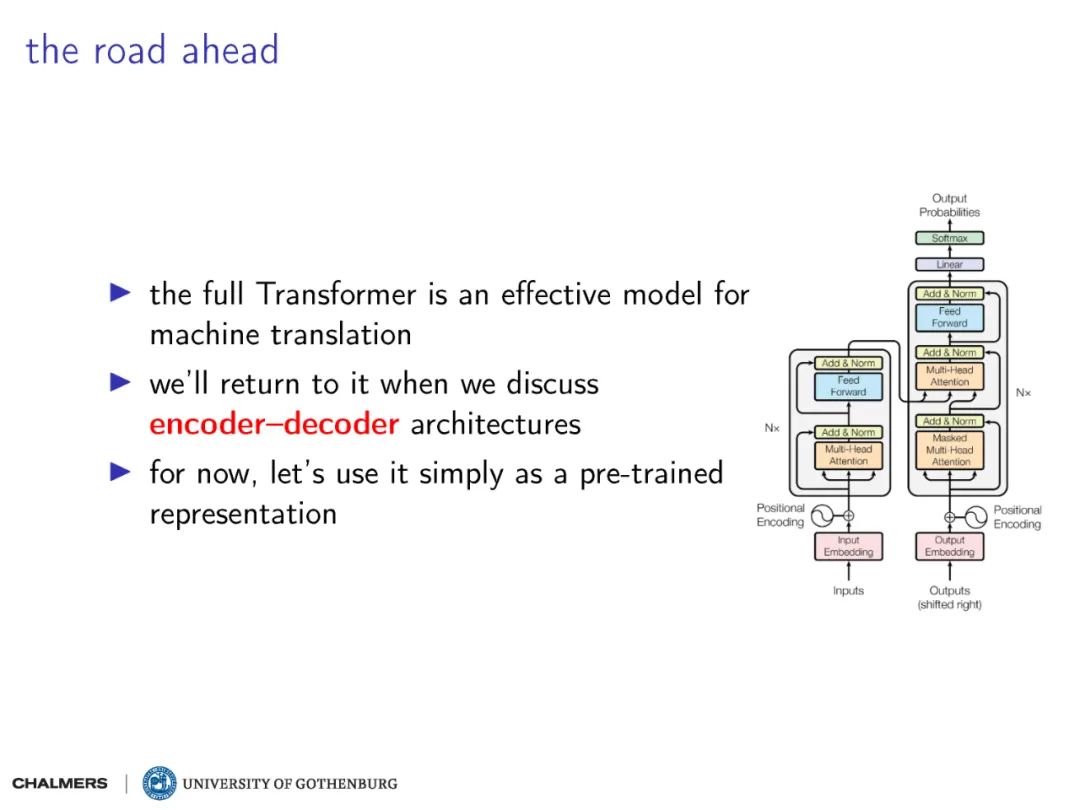

Transformer由论文《Attention is All You Need》提出,现在是谷歌云TPU推荐的参考模型。Transformer是:“首个完全抛弃RNN的recurrence,CNN的convolution,仅用attention来做特征抽取的模型。“ 本文简介了Transformer模型。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“T17” 可以获取《Transformer模型-深度学习自然语言处理,17页ppt》专知下载链接索引

登录查看更多