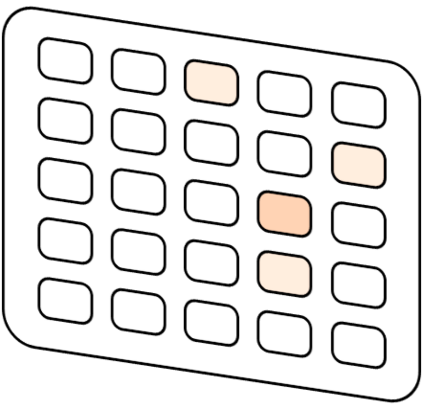

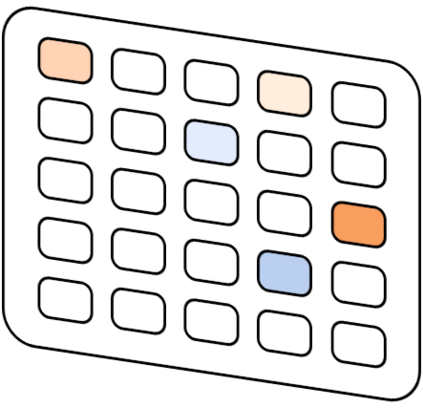

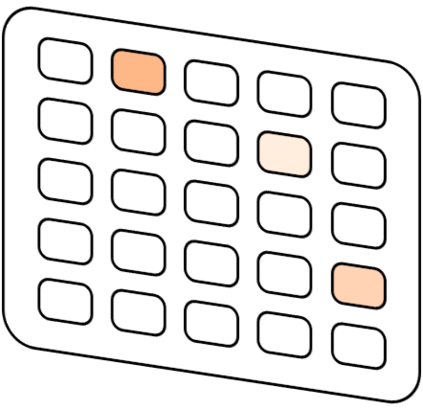

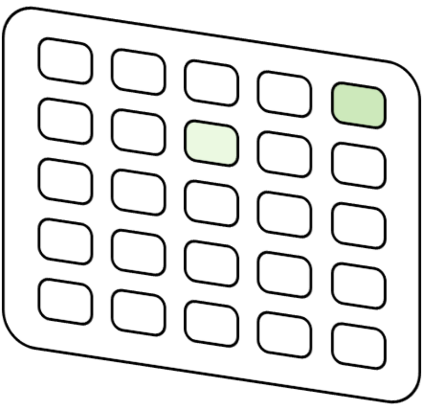

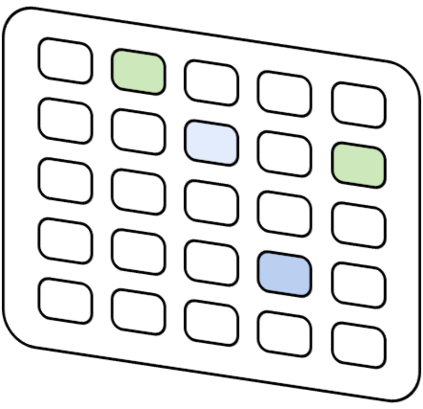

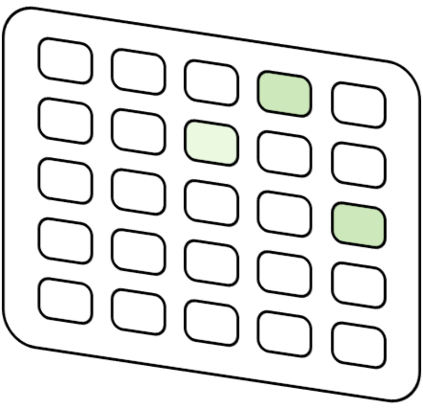

In joint entity and relation extraction, existing work either sequentially encode task-specific features, leading to an imbalance in inter-task feature interaction where features extracted later have no direct contact with those that come first. Or they encode entity features and relation features in a parallel manner, meaning that feature representation learning for each task is largely independent of each other except for input sharing. We propose a partition filter network to model two-way interaction between tasks properly, where feature encoding is decomposed into two steps: partition and filter. In our encoder, we leverage two gates: entity and relation gate, to segment neurons into two task partitions and one shared partition. The shared partition represents inter-task information valuable to both tasks and is evenly shared across two tasks to ensure proper two-way interaction. The task partitions represent intra-task information and are formed through concerted efforts of both gates, making sure that encoding of task-specific features is dependent upon each other. Experiment results on five public datasets show that our model performs significantly better than previous approaches. In addition, contrary to what previous work claims, our auxiliary experiments suggest that relation prediction is contributory to named entity prediction in a non-negligible way. The source code can be found at https://github.com/Coopercoppers/PFN.

翻译:在联合实体和关系提取中,现有工作要么按顺序编码任务的具体特点,导致任务之间特征互动的不平衡,而后来提取的特征与先到的特征没有直接接触。或者以平行的方式编码实体特征和关系特征,这意味着每项任务的特征代表学习基本上相互独立,但投入共享除外。我们提议建立一个分隔过滤网络,以适当模式在任务之间进行双向互动,特征编码分解成两个步骤:分割和过滤。在编码中,我们利用两个大门:实体和关联门,将神经元分成成两个任务分区和一个共享分区。共享分割代表了对两个任务都有价值的任务之间信息,并且均衡地分享了两个任务之间的信息,以确保适当的双向互动。任务划分代表了内部信息,并且通过两扇门的一致努力形成,确保具体任务特征的编码相互依赖。在五个公共数据集上的实验结果显示,我们的模式比以往的方法要好得多。此外,我们的辅助实验表明,与先前的工作要求相反,我们之间的关系预测是两个任务之间有价值的信息,对于确保适当的双向互动互动。任务之间可以找到一个源代码。