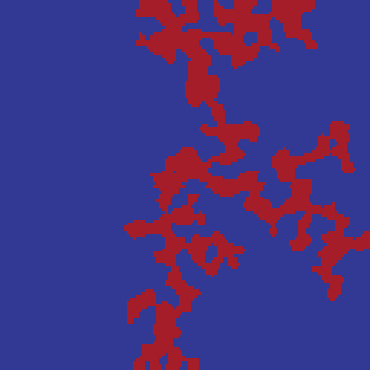

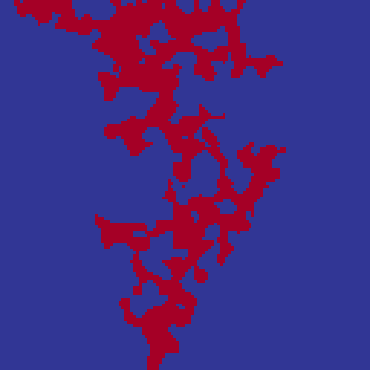

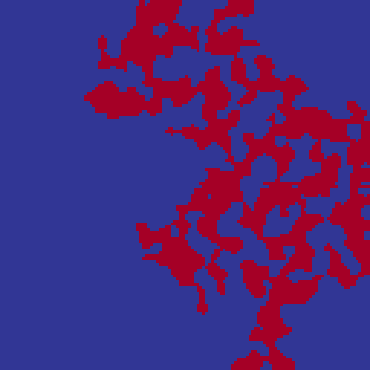

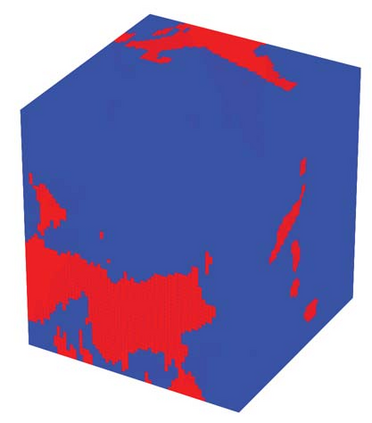

We propose a novel deep learning framework for predicting permeability of porous media from their digital images. Unlike convolutional neural networks, instead of feeding the whole image volume as inputs to the network, we model the boundary between solid matrix and pore spaces as point clouds and feed them as inputs to a neural network based on the PointNet architecture. This approach overcomes the challenge of memory restriction of graphics processing units and its consequences on the choice of batch size, and convergence. Compared to convolutional neural networks, the proposed deep learning methodology provides freedom to select larger batch sizes, due to reducing significantly the size of network inputs. Specifically, we use the classification branch of PointNet and adjust it for a regression task. As a test case, two and three dimensional synthetic digital rock images are considered. We investigate the effect of different components of our neural network on its performance. We compare our deep learning strategy with a convolutional neural network from various perspectives, specifically for maximum possible batch size. We inspect the generalizability of our network by predicting the permeability of real-world rock samples as well as synthetic digital rocks that are statistically different from the samples used during training. The network predicts the permeability of digital rocks a few thousand times faster than a Lattice Boltzmann solver with a high level of prediction accuracy.

翻译:我们提出一个新的深层次学习框架,用于预测数字图像中多孔媒体的渗透性。与进化神经网络不同,我们把固体矩阵和孔隙空间的界限作为点云,作为基于PointNet结构的神经网络的输入。这个方法克服了图形处理器记忆限制的挑战及其对批量大小和聚合选择的影响。与进化神经网络相比,提议的深层学习方法提供了选择较大批量规模的自由,因为网络投入的大小大大缩小。具体地说,我们使用PointNet的分类分支并将其调整为回归任务。作为一个测试案例,我们考虑将二、三个维合成合成数字岩石图像作为输入基于PointNet结构的神经网络。我们调查我们神经网络不同组成部分对其性能的影响,我们从不同角度,特别是从可能的最大批量的角度,将我们的深层学习战略与一个革命神经网络进行比较。我们通过预测真实世界岩石样品的可采性以及合成数字岩石的可合成性,从数字模型的高度上看,从数字模型的可测度上看,从一个不同时期的可测得性水平上,从一个不同样品的可测得。