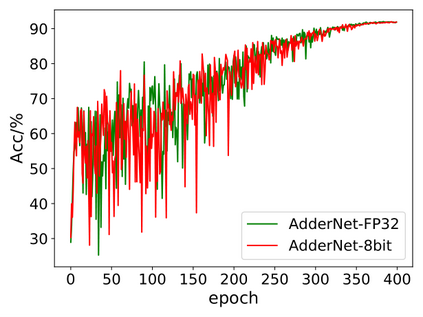

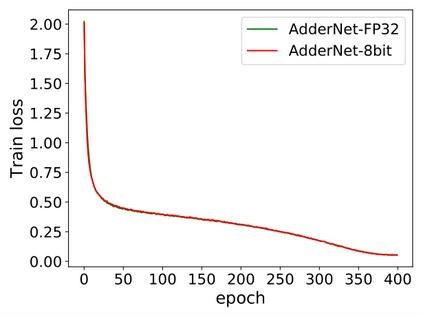

Convolutional neural networks (CNN) have been widely used for boosting the performance of many machine intelligence tasks. However, the CNN models are usually computationally intensive and energy consuming, since they are often designed with numerous multiply-operations and considerable parameters for the accuracy reason. Thus, it is difficult to directly apply them in the resource-constrained environments such as 'Internet of Things' (IoT) devices and smart phones. To reduce the computational complexity and energy burden, here we present a novel minimalist hardware architecture using adder convolutional neural network (AdderNet), in which the original convolution is replaced by adder kernel using only additions. To maximally excavate the potential energy consumption, we explore the low-bit quantization algorithm for AdderNet with shared-scaling-factor method, and we design both specific and general-purpose hardware accelerators for AdderNet. Experimental results show that the adder kernel with int8/int16 quantization also exhibits high performance, meanwhile consuming much less resources (theoretically ~81% off). In addition, we deploy the quantized AdderNet on FPGA (Field Programmable Gate Array) platform. The whole AdderNet can practically achieve 16% enhancement in speed, 67.6%-71.4% decrease in logic resource utilization and 47.85%-77.9% decrease in power consumption compared to CNN under the same circuit architecture. With a comprehensive comparison on the performance, power consumption, hardware resource consumption and network generalization capability, we conclude the AdderNet is able to surpass all the other competitors including the classical CNN, novel memristor-network, XNOR-Net and the shift-kernel based network, indicating its great potential in future high performance and energy-efficient artificial intelligence applications.

翻译:47. 然而,CNN模型通常在计算上密集和消耗能源,因为其设计中往往使用多种倍增操作和相当的精确度参数。因此,很难在资源受限制的环境中直接应用这些模型,如“Things互联网”(IoT)装置和智能手机。为了减少计算复杂性和能量负担,我们在这里展示了一个新的最低要求硬件结构,其中使用了附加器连动神经网络(AderNet),其中原变电由添加器内核取代,仅使用附加器。为了最大限度地挖掘潜在的能源消耗量,我们探索了使用共享算法的AdderNet低位四分解算法,我们为AdderNet设计了专用和通用硬件加速器。为了降低计算复杂性和能量负担,我们在这里展示了一种新式螺旋螺旋式螺旋式螺旋式螺旋桨,同时将原始电流-内电流内电流-内电流-内电流-内电流-内电流-内电流-内存仅添加。此外,ARCR81%内,内置所有电流-内置电流-内置电流-直流-内置电-内置电流-直径。