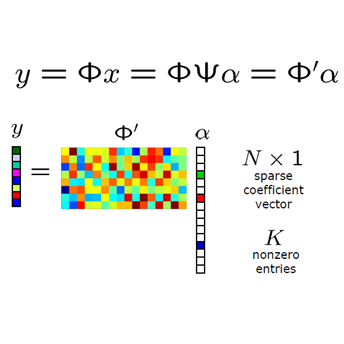

Efficient algorithms for the sparse solution of under-determined linear systems $Ax = b$ are known for matrices $A$ satisfying suitable assumptions like the restricted isometry property (RIP). Without such assumptions little is known and without any assumptions on $A$ the problem is $NP$-hard. A common approach is to replace $\ell_1$ by $\ell_p$ minimization for $0 < p < 1$, which is no longer convex and typically requires some form of local initial values for provably convergent algorithms. In this paper, we consider an alternative, where instead of suitable initial values we are provided with extra training problems $Ax = B_l$, $l=1, \dots, p$ that are related to our compressed sensing problem. They allow us to find the solution of the original problem $Ax = b$ with high probability in the range of a one layer linear neural network with comparatively few assumptions on the matrix $A$.

翻译:用于低定线性系统稀疏溶液的高效算法 $Ax = b$ 已知的基质 $A$满足了合适的假设,例如限制的等离子属性(RIP) 。如果没有这种假设,我们鲜为人知,而且对美元没有任何假设,问题就在于$NP$-硬。通常的做法是以0美元 < p < 1美元以1美元以1美元取代1美元=1美元,美元=1美元,美元=1美元,美元=1美元,美元=1美元,美元=1美元,美元=2美元,美元=1美元,美元=1美元,美元=1美元,美元=1美元,美元=1美元,美元=1美元,美元=1美元,美元=1美元,美元=1美元,美元=1美元,美元=1层线性神经网络的极有可能在1层线性神经网络范围内找到的解决方案,而美元=b美元=1美元。在本文件中,我们考虑一种替代办法,而不是适当的初始值。