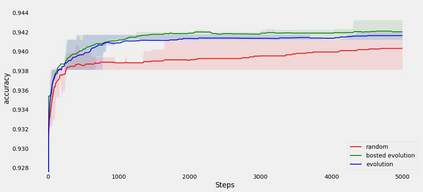

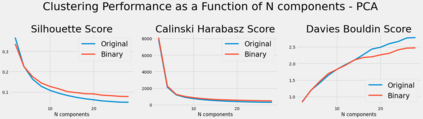

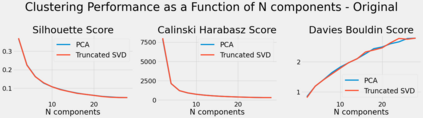

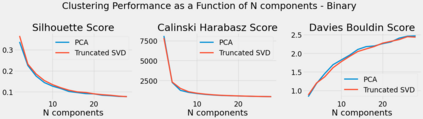

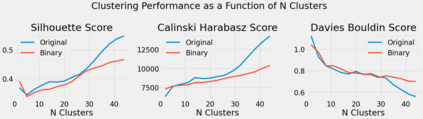

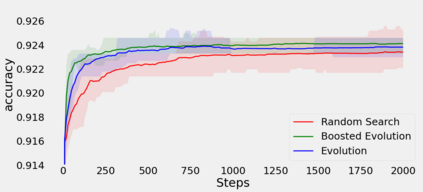

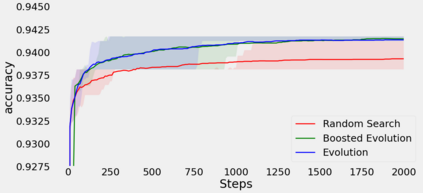

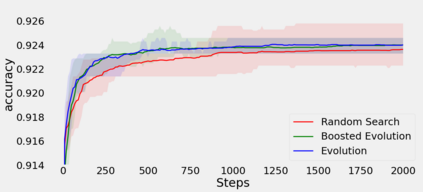

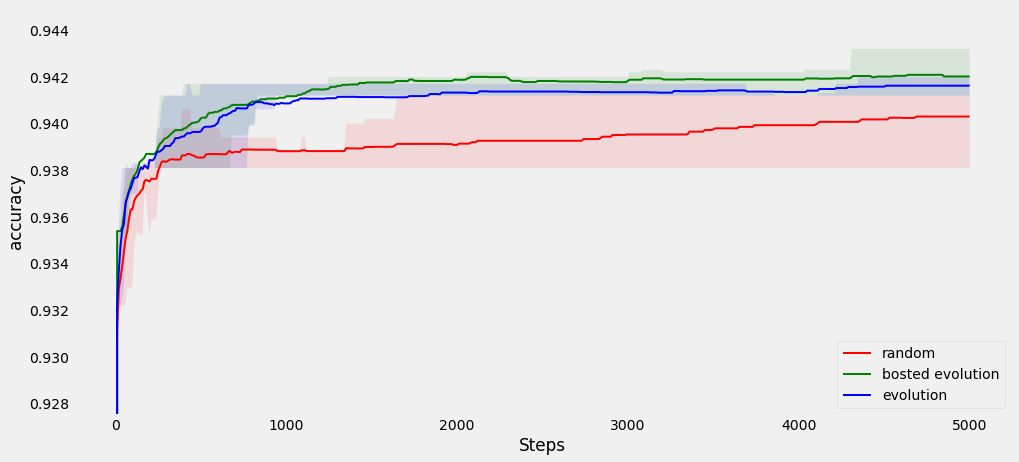

Lots of effort in neural architecture search (NAS) research has been dedicated to algorithmic development, aiming at designing more efficient and less costly methods. Nonetheless, the investigation of the initialization of these techniques remain scare, and currently most NAS methodologies rely on stochastic initialization procedures, because acquiring information prior to search is costly. However, the recent availability of NAS benchmarks have enabled low computational resources prototyping. In this study, we propose to accelerate a NAS algorithm using a data-driven initialization technique, leveraging the availability of NAS benchmarks. Particularly, we proposed a two-step methodology. First, a calibrated clustering analysis of the search space is performed. Second, the centroids are extracted and used to initialize a NAS algorithm. We tested our proposal using Aging Evolution, an evolutionary algorithm, on NAS-bench-101. The results show that, compared to a random initialization, a faster convergence and a better performance of the final solution is achieved.

翻译:大量神经结构搜索(NAS)研究致力于算法开发,目的是设计效率更高、成本更低的方法。然而,对这些技术初始化的调查仍然很吓人,目前大多数NAS方法依赖随机初始化程序,因为搜索前获取信息成本很高。然而,最近提供的NAS基准使得计算资源原型低。在本研究中,我们提议利用数据驱动初始化技术加速NAS算法,利用NAS基准的可用性。特别是,我们建议了两步方法。首先,对搜索空间进行了校准组合分析。第二,提取了半机器人,并用于初始化NAS算法。我们用NAS-bunch-101用老化、进化算法测试了我们的提案。结果显示,与随机初始化相比,最终解决方案的更快趋同和更好的表现已经实现。