主题: Opportunities and Challenges in Explainable Artificial Intelligence (XAI): A Survey

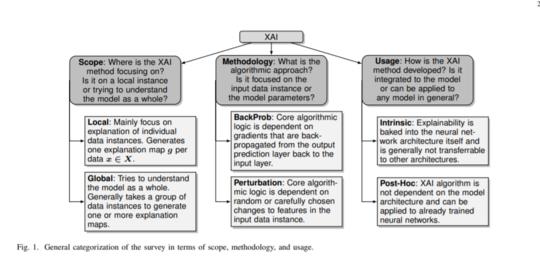

摘要: 如今,深度神经网络已广泛应用于对医疗至关重要的任务关键型系统,例如医疗保健,自动驾驶汽车和军事领域,这些系统对人类生活产生直接影响。然而,深层神经网络的黑匣子性质挑战了其在使用中的关键任务应用,引发了引起信任不足的道德和司法问题。可解释的人工智能(XAI)是人工智能(AI)的一个领域,它促进了一系列工具,技术和算法的产生,这些工具,技术和算法可以生成对AI决策的高质量,可解释,直观,人类可理解的解释。除了提供有关深度学习当前XAI格局的整体视图之外,本文还提供了开创性工作的数学总结。我们首先提出分类法,然后根据它们的解释范围,算法背后的方法,解释级别或用法对XAI技术进行分类,这有助于建立可信赖,可解释且自解释的深度学习模型。然后,我们描述了XAI研究中使用的主要原理,并介绍了2007年至2020年XAI界标研究的历史时间表。在详细解释了每种算法和方法之后,我们评估了八种XAI算法对图像数据生成的解释图,讨论了其局限性方法,并提供潜在的未来方向来改进XAI评估。

成为VIP会员查看完整内容

相关内容

人工智能(Artificial Intelligence, AI )是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。 人工智能是计算机科学的一个分支。

专知会员服务

14+阅读 · 2019年11月22日