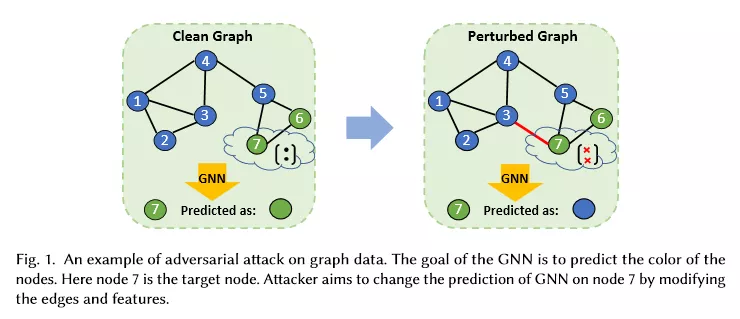

【简介】深度神经网络(DNNs)在各项任务上都取得了不俗的表现。然而,最近的研究表明通过对输入进行很小的扰动就可以轻易的骗过DNNs,这被称作对抗式攻击。作为DNNs在图上的扩展,图神经网络(GNNs)也继承了这一缺陷。对手通过修改图中的一些边等操作来改变图的结构可以误导GNNs作出错误的预测。这一漏洞已经引起了人们对在安全领域关键应用中采用GNNs的极大关注,并在近年来引起了越来越多的人的研究兴趣。因此,对目前的图对抗式攻击和反制措施进行一个全面的梳理和回顾是相当有必要的。在这篇综述中,我们对目前的攻击和防御进行了分类,以及回顾了相关表现优异的模型。最后,我们开发了一个具有代表性算法的知识库,该知识库可以使我们进行相关的研究来加深我们对基于图的攻击和防御的理解。

成为VIP会员查看完整内容

相关内容

Arxiv

6+阅读 · 2018年3月24日