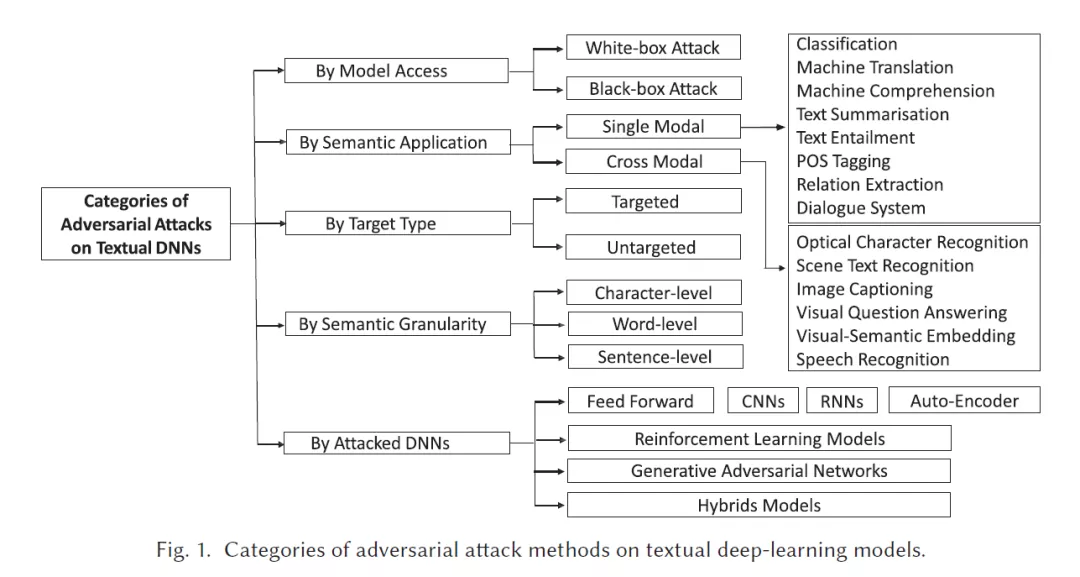

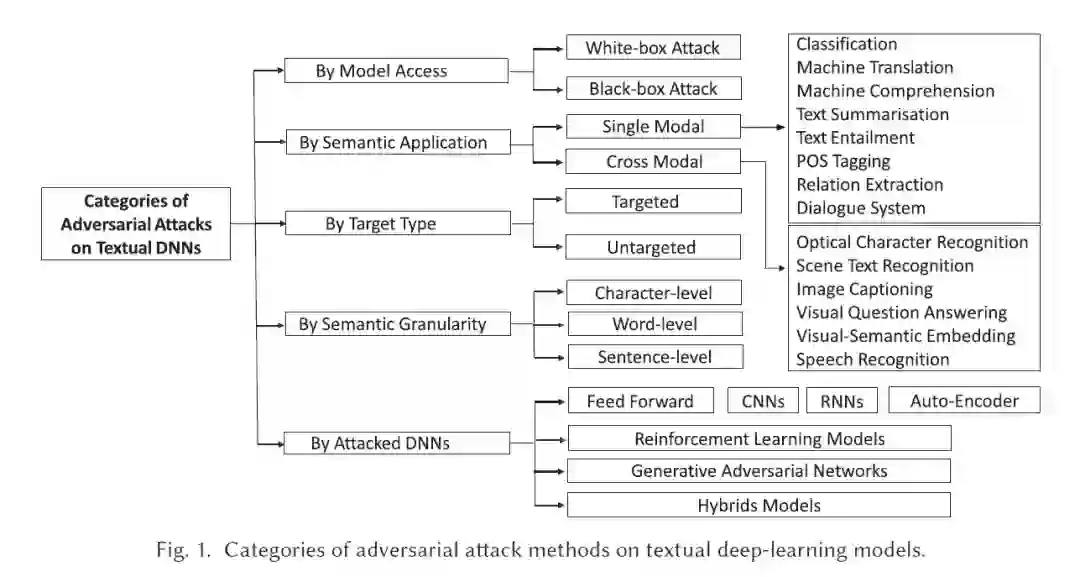

随着高计算设备的发展,深度神经网络(DNNs)近年来在人工智能(AI)领域得到了广泛的应用。然而,之前的研究表明,DNN在经过策略性修改的样本(称为对抗性样本)面前是脆弱的。这些样本是由一些不易察觉的扰动产生的,但可以欺骗DNN做出错误的预测。受图像DNNs中生成对抗性示例的流行启发,近年来出现了针对文本应用的攻击DNNs的研究工作。然而,现有的图像扰动方法不能直接应用于文本,因为文本数据是离散的。在这篇文章中,我们回顾了针对这一差异的研究工作,并产生了关于DNN的电子对抗实例。我们对这些作品进行了全面的收集、选择、总结、讨论和分析,涵盖了所有相关的信息,使文章自成一体。最后,在文献回顾的基础上,我们提出了进一步的讨论和建议。

成为VIP会员查看完整内容