【泡泡一分钟】基于三维可变形Eye-Face模型的实时视线跟踪(ICCV2017-105)

每天一分钟,带你读遍机器人顶级会议文章

标题:Real Time Eye Gaze Tracking with 3D Deformable Eye-Face Model

作者:Kang Wang, Qiang Ji

来源:ICCV 2017 ( IEEE International Conference on Computer Vision)

编译:张建 周平

审核:陈世浪

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

基于3D模型的视线估计方法被广泛的研究,因为它们具有良好的精度和处理自由头部运动的能力。带有复杂硬件系统(如红外光,3D传感器等)的传统方法被限制在受控的环境中,这大大限制了它们的实际应用。

在本文中,我们提出了一种带有单一网络摄像头的基于三维模型的视线估计方法,可以进行即时并且便携的视线跟踪。

关键的想法是利用所提出的三维eye-face模型,我们可以从观察到的二维面部标志估计出三维视线。所提出的系统包括从多个训练对象离线学习的三维可变形eye-face模型。如果给定可变形模型,个体的三维eye-face模型和个人的眼睛参数可以通过统一的标定算法恢复。

实验结果表明,该方法优于目前最先进的方法,同时允许方便的系统建立与自由的头部移动。一个30 FPS的实时眼部跟踪系统也验证了所提出方法的有效性和效率。

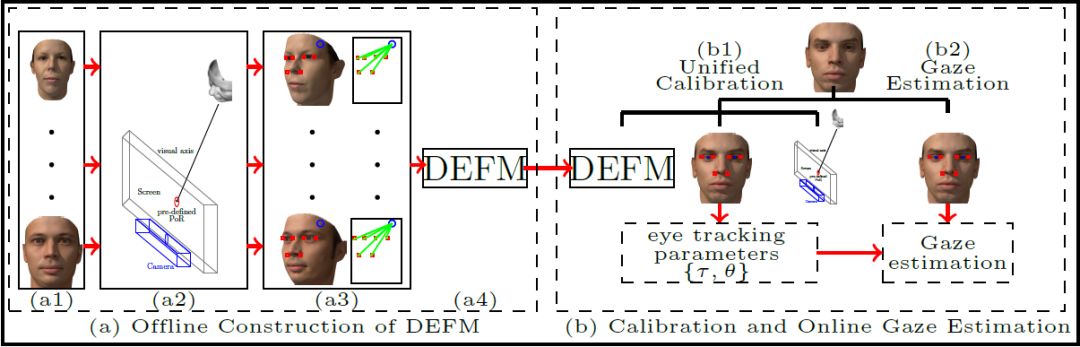

图1 所提出的视线估计框架的概述。

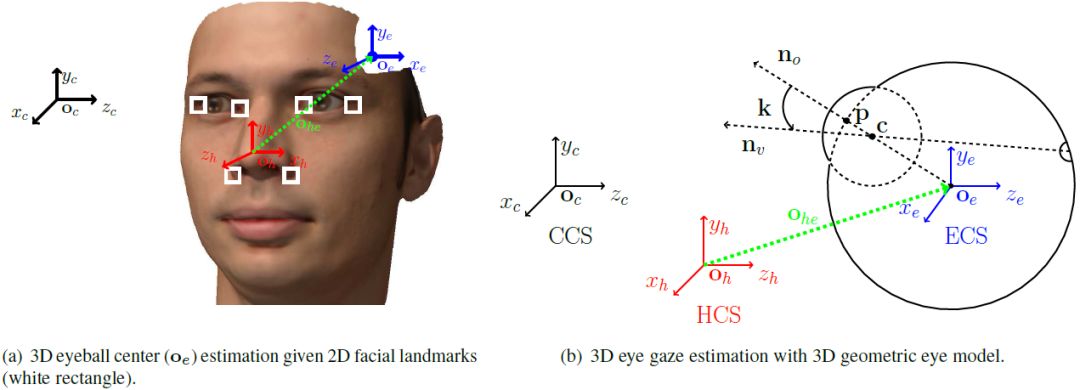

图2 基于三维模型带有面部标志的视线估计

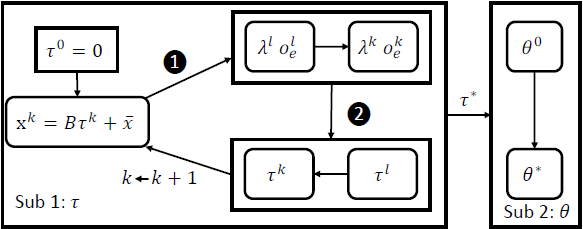

图3 标定流程概述

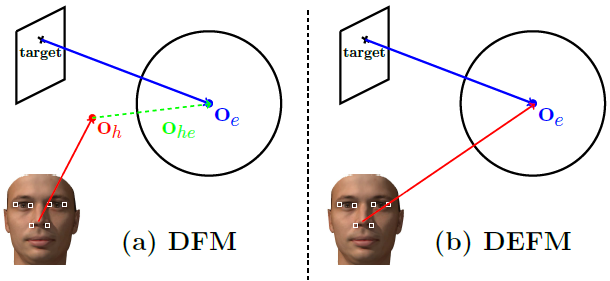

图4 DFM和DEFM标定的几何图解。

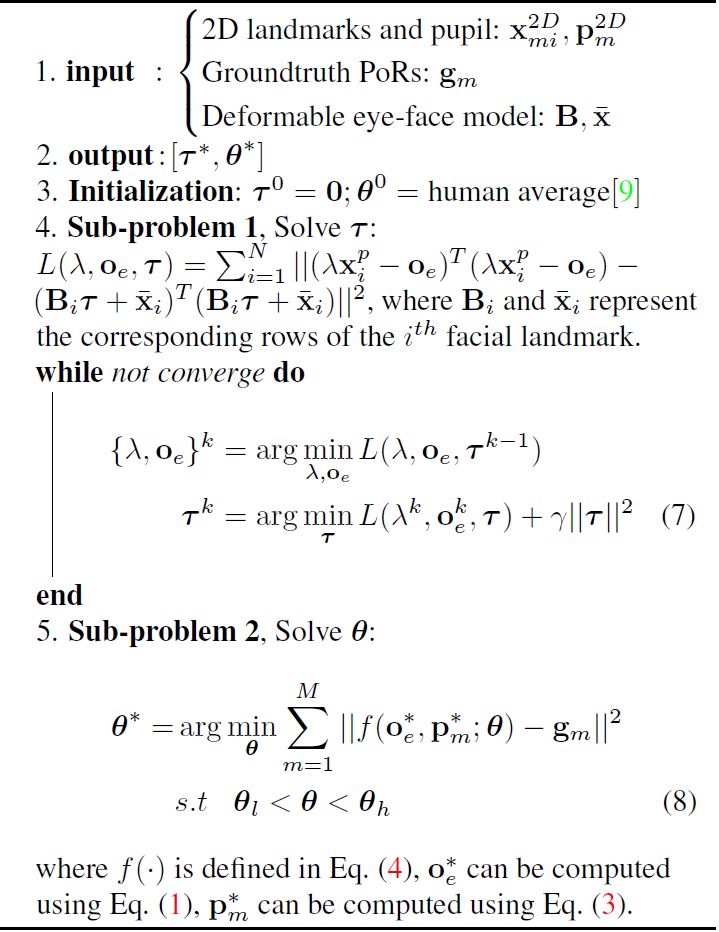

算法1:标定算法

Abstract

3D model-based gaze estimation methods are widely explored because of their good accuracy and ability to handle free head movement. Traditional methods with complex hardware systems (Eg. infrared lights, 3D sensors, etc.) are restricted to controlled environments, which significantly limit their practical utilities. In this paper, we propose a 3D model-based gaze estimation method with a single web-camera, which enables instant and portable eye gaze tracking. The key idea is to leverage on the proposed 3D eye-face model, from which we can estimate 3D eye gaze from observed 2D facial landmarks. The proposed system includes a 3D deformable eye-face model that is learned offline from multiple training subjects. Given the deformable model, individual 3D eye-face models and personal eye parameters can be recovered through the unified calibration algorithm. Experimental results show that the proposed method outperforms state-of-the-art methods while allowing convenient system setup and free head movement. A real time eye tracking system running at 30 FPS also validates the effectiveness and efficiency of the proposed method.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com